Lexikon der Neurowissenschaft: Sprache

Essay

Rüdiger Vaas

Sprache

Als die Mücke zum ersten Male den Löwen brüllen hörte, da sprach sie zur Henne: "Der summt aber komisch." "Summen ist gut", fand die Henne. "Sondern?" fragte die Mücke. "Er gackert", antwortete die Henne. "Aber das tut er allerdings komisch." (Günther Anders: Der Löwe). – Was ist Sprache? Wie entsteht sie im Gehirn? Wie und warum ist die menschliche Sprachfähigkeit entstanden, wie hat sie sich entwickelt? Wie prägt Sprache unser Denken und Weltbild? "Vielleicht ist dazu die Sprache da: daß wir die Welt verstehen können, ohne völlig von ihr überwältigt zu werden", sagte Carl Sagan. Mit der Sprache versuchen wir auch, die Sprache selbst zu verstehen. Dies ist ein transdisziplinäres Unternehmen im Fadenkreuz von Linguistik, Kognitionswissenschaft, Neurowissenschaft, Anatomie, Anthropologie, Psychologie, Ethnologie, Evolutionsbiologie, Informatik, Archäologie, Geschichte und Philosophie. Und doch gilt, mit den Worten von Elias Canetti: "Alle Theorien der Sprache bis zum heutigen Tage können ihr nichts anhaben."

Was ist Sprache?

Sprache (E language) ist ein auf mentalen Prozessen basierendes, sozial bedingtes und historischer Entwicklung unterworfenes Mittel zum Ausdruck bzw. Austausch von Gedanken, Gefühlen, Vorstellungen, Erkenntnissen und Informationen sowie zur Fixierung und Tradierung von Erfahrung und Wissen. Dies geschieht in erster Linie mit komplex strukturierten Lautfolgen, kann jedoch auch in anderen Medien erfolgen (Gestik, Mimik, Gebärdensprache, visuelle Zeichen in Bilder- und Schriftsprachen usw.) In diesem Sinn bezeichnet Sprache eine artspezifische, nur dem Menschen eigene Fähigkeit, die sich von Tiersprachen unterscheidet u.a. durch Kreativität (praktisch unendliche Anzahl möglicher Sätze), die Fähigkeit zur begrifflichen Abstraktion und der Kommunikation nicht nur über anwesende, sondern auch über abwesende oder nicht existierende, d.h. bloß vorgestellte Gegenstände sowie durch die Möglichkeit metasprachlicher Reflexion (z.B. des Sprechens über Sprache wie in diesem Text). Dies kann nicht auf Nachahmungslernen reduziert werden und ist eine Voraussetzung für die Entstehung von Kultur (Kunst, Religion, Philosophie, Wissenschaft, Ethik usw). Die Sprachfähigkeit gilt seit der Antike als differentia specifica des Menschen gegenüber allen anderen irdischen Lebewesen. Ob dieser Unterschied allerdings wirklich so groß ist, wird durch Forschungen insbesondere mit Menschenaffen und Delphinen in Frage gestellt: Sie zeigen, daß diese Tiere eine rudimentäre Sprachfähigkeit besitzen bzw. mit menschlicher Hilfe entwickeln können. Auch Computerprogramme erhalten mehr und mehr Sprachbefähigungen. Sprache muß unterschieden werden vom Denken (siehe unten), vom Lesen und Schreiben (Fähigkeiten, die sich erst später herausgebildet haben) sowie von der Beherrschung normativer Regeln (z.B. dem "korrekten" Gebrauch, der durch Lehrer oder Regelwerke vorgeschrieben wird). Die wissenschaftliche Erforschung der Sprache ist deskriptiv, nicht präskriptiv. Strenggenommen gibt es keine sprachliche Homogenität, keine zwei Menschen sprechen exakt dieselbe Sprache. Auch gibt es keine Hinweise und Kriterien dafür, daß irgendeine menschliche Sprache primitiver ist als irgendeine andere (mit Ausnahme der Pidginsprachen, s.u.).

Unterscheidungen: Sprache ist bei genauerer Betrachtung ein mehrdeutiger Begriff. Dieser meint: 1) ganz allgemein ein Kommunikationssystem im Sinn der Semiotik und Informationstheorie; hier sind auch formallogische (z.B. Programmiersprachen; Programmierung) und andere Symbolsprachen (z.B. Flaggensignale) inbegriffen sowie die Kommunikationsformen der Tiere (z.B. Bienensprache); 2) die menschliche, genetisch mitbedingte und neurophysiologisch fundierte Sprachfähigkeit oder Kompetenz (franz. faculté de langage); 3) eine Einzelsprache (franz. langue) wie Deutsch, Türkisch oder Japanisch, d.h. die Konkretisierung der Sprachfähigkeit in einer Sprachgemeinschaft in einem bestimmten zeitlichen und geographischen Raum und deren Ausdruck in konkreten Kommunikationsereignissen (Sprechvorgängen); 4) einen Sprechvorgang als individuelle Tätigkeit in einer Einzelsprache und somit das Sprechen, die Sprachverwendung, Rede oder Performanz (franz. parole) einschließlich eines bestimmten Dialekts, Soziolekts usw. (Die französischen Bezeichnungen wurden angeführt, da sie in der Linguistik zur Unterscheidung der verschiedenen Bedeutungen verwendet werden.)

Funktion: Die Sprachfähigkeit hat vielerlei Nutzen: Übermittlung von Informationen, Anweisungen und Befehlen, Fragen, Benennen und Kategorisierung, Ausdruck von Gefühlen, Knüpfen und Festigung sozialer Bindungen ("Small-Talk"), Koordination und Planung von Handlungen, Beeinflussung anderer, Lüge und Täuschung, Wortspiele und Poesie usw.

Merkmale: Die Sprachfähigkeit ist angeboren und entwickelt sich im Lauf der biologischen Reifung und der Sozialisation jedes Menschen zu einem kompletten System. Sprachentwicklungsstörungen können diesen Prozeß ver- oder behindern, führen aber häufig zur Ausbildung anders strukturierter, funktional meist vergleichbarer Kommunikationssysteme, insbesondere der Gebärdensprachen Gehörloser. Das physische Substrat sind Ketten von Sprachlauten, die in der Zeit (bzw. als Ketten von Zeichen auf einem Schriftträger im Raum) linear angeordnet sind und Elemente aller Ebenen des jeweiligen Sprachsystems ausdrücken ( siehe Abb. 1 ): 1) das Sprachlautinventar als spezifische Auswahl aus einem universellen Repertoire, aus dessen Vokalen und Konsonanten Silben gebildet werden ( siehe Zusatzinfo 1 ); 2) die Semantisierung des Lautinventars als Phoneme (kleinste bedeutungsunterscheidende Lauteinheiten), die von der Phonologie beschrieben wird; 3) die spezifische Verkettung der Phoneme zu Morphemen (kleinste bedeutungstragende Einheiten), Wörtern und Wortformen, die von der Morphologie beschrieben wird; 4) die Verbindung der Morpheme zu Phrasen, Sätzen und Texten bzw. Diskursen (Erzählungen).

Die Syntax beschreibt die zulässigen Kombinationen von Wörtern zu Phrasen und Sätzen ("Grammatik"). Dabei stechen drei Prinzipien hervor: a) Wortsequenzen sind in Phrasen gruppiert, die wiederum in größere Phrasen gruppiert sind usw., was eine baumartige Phrasenstruktur ergibt. Wenn z.B. Groucho Marx sagt "Ich erschoß einmal einen Elefanten in meinem Schlafanzug. Wie er in meinen Schlafanzug kam, werde ich niemals wissen", entsteht der Witz dadurch, daß es zwei Phrasenstrukturen für dieselbe Wortsequenz gibt: "[Ich erschoß] [einen Elefanten] [in meinem Schlafanzug]" und "[Ich erschoß] [einen Elefanten in meinem Schlafanzug]". b) Das Verb bestimmt, wie die Wortbedeutungen in einer Phrasenstruktur zu einer zusammenhängenden Aussage integriert werden. Z.B. benötigen transitive Verben ein Akkusativobjekt, das bei der Umwandlung ins Passiv zum Subjekt wird ("Das Kind sieht den Hund" bzw. "Der Hund wird vom Kind gesehen"), intransitive Verben benötigen kein Objekt und können nur ein unpersönliches Passiv bilden ("Das Kind lacht" bzw. "Es wurde viel gelacht"). c) Zwei Phrasen in einem Satz können so verbunden werden, daß sie auf dasselbe referieren (Anapher, Anaphora). Z.B. beziehen sich "das Kind" und "sich" im Satz "Das Kind wäscht sich" auf dieselbe Person.

Die Semantik beschreibt die Bedeutungen, die mit allen lexikalischen Einheiten und Sätzen verknüpft sind. Ein Wort ist die kontingente, durch Konventionen relativ verbindlich gebrauchte Assoziation zwischen einem Lautmuster und einer Bedeutung (Arbitrarität der sprachlichen Zeichen). Das Lexikon umfaßt die Gesamtheit der Wörter einer Sprache, einschließlich ihrer morphologischen und syntaktischen Besonderheiten. Hinzu kommen die Prosodie (die Betonungsmuster und Tonhöhenverläufe, die die wörtliche Bedeutung modifizieren können) und die Pragmatik (Regeln und Normen für die Sprachverwendung, siehe Tab. 1 ). Damit erschöpft sich die menschliche Kommunikation freilich nicht. Andere Formen wie Mimik, Gestik, Körperhaltung, Blicke, Laute usw. gehen über die Sprachfähigkeit hinaus und spielen auch im Tierreich eine wichtige Rolle.

Neurolinguistik

Die neuronalen Grundlagen der Sprache (Verständnis, Repräsentation, Produktion und Entwicklung, einzelsprachliche Unterschiede, Ausfälle und Therapie) sind das Forschungsgebiet der Neurolinguistik. Die wichtigsten Forschungsmethoden sind das Studium von Läsionen (z.B. Aphasie), Experimente mit wachen Gesunden (z.B. dichotisches Hören, elektrische Stimulationen, Betäubung mit dem Natriumamytaltest) und physiologische Messungen (Elektroencephalogramm, evozierte Potentiale, Magnetencephalographie, Positronenemissionstomographie, funktionelle Kernspinresonanztomographie).

Sprachlateralisierung: Die Sprachregionen in der menschlichen Großhirnrinde sind in der Regel asymmetrisch verteilt, d.h. bei fast allen Rechtshändern und bei etwa zwei Drittel der Linkshänder in der linken Gehirnhälfte lokalisiert ( siehe Zusatzinfo 2 ; Asymmetrie des Gehirns). Das gilt auch für Gebärdensprachen, die auf visuomotorischen und nicht auditorischen Sprachsignalen basieren (und ebenfalls einer Aphasie zum Opfer fallen können). Nur bei etwa 3% der Menschen ist die rechte Hemisphäre sprachdominant oder sind beide Hirnhälften für Sprache gleichermaßen zuständig. Neuroanatomisch weist die Großhirnrinde hauptsächlich drei Asymmetrien auf ( siehe Abb. 2 ). Die Hemisphärenspezialisierung ist mit fünf Jahren schon deutlich nachweisbar und mit der Pubertät weitgehend abgeschlossen. Dann können Schäden in der sprachdominanten Hirnhälfte oder eine Hemisphärektomie kaum mehr kompensiert werden, wobei aber in der nichtdominanten Hemisphäre auch noch elementare und eher ganzheitliche sprachliche Verarbeitungsfunktionen verfügbar bleiben, was für die Rehabilitation von Aphasikern bedeutsam ist. So hat die rechte Hemisphäre, wie z.B. Untersuchungen von gekreuzter Aphasie und Experimente mit Split-Brain-Patienten zeigten, ein überraschend gutes Hörverständnis für Substantive und Verben, eine gewisse Lese-, aber keine Schreibfähigkeit, keine Silben-Sequenzierung und kein syntaktisches Verständnis. Auch Verständnis und Ausdruck der Prosodie erfolgen überwiegend rechtsseitig.

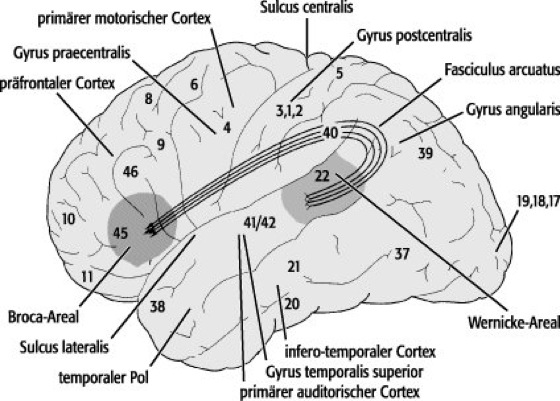

Stimulation: Die Reizung vieler corticaler Areale mit elektrischem Strom niedriger Spannung führt zu mehr oder weniger spezifischen Sprachstörungen. Zu diesen Gebieten gehören das Broca-Areal (Brodmann-Areal 44 und 45, unmittelbar vor dem Motorcortex) und das Wernicke-Areal (Brodmann-Areal 22, direkt hinter und seitlich zur auditorischen Cortex-Region) sowie in beiden Hemisphären die Areale mit sensorischer und motorischer Repräsentation des Gesichts und das supplementär-motorische Areal (SMA). Die Reizung kann Lautäußerungen in Form lang anhaltender Vokale erzeugen (bei Stimulation eines Gesichtsareals oder eines SMA) oder das Sprechen verhindern, die richtige Wortverwendung beeinträchtigen, aphasieähnliche Formen hervorrufen (verwaschene Sprache, verzerrte Aussprache, Perseveration), eine Verwechslung von Zahlen beim Zählen auslösen oder bei erhaltener Sprachfunktion vorübergehend die Benennung bekannter Objekte unterbrechen bzw. eine falsche Benennung verursachen. Die Lokalisation corticaler Sprachareale variiert zwischen verschiedenen Personen beträchtlich, wobei die Areale bei Männern meist ausgedehnter sind als bei Frauen (jedenfalls im hinteren Schläfenlappen; im Frontallappen und in der Insula könnte es umgekehrt sein). Bei mehrsprachigen Menschen wird die schlechter beherrschte Sprache durch Reizung eines größeren Sprachareals unterbrochen. Die Stimulations-Experimente zeigen also, daß die Sprachfähigkeit entgegen dem Wernicke-Geschwind-Modell nicht streng in eng begrenzten Cortex-Arealen lokalisiert ist, daß aber gewisse Bereiche für die Sprachfähigkeit notwendig sind.

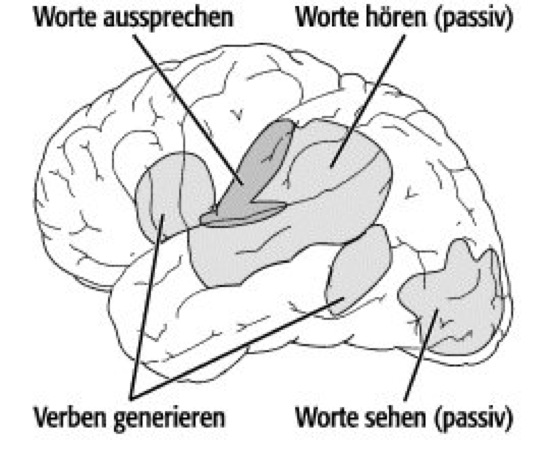

Lokalisation und Organisation: Die neuronale Basis der Sprache ist ähnlich wie Wahrnehmung und Gedächtnis organisiert: Sprachfunktionen sind über einen großen Bereich des Cortex verteilt, also nicht einfach nur als separates Teilstück addiert worden ( siehe Abb. 3 , siehe Zusatzinfo 3 , siehe Zusatzinfo 4 ). Außerdem existieren mehrere, teilweise unabhängige "Kanäle" für die Sprachfunktionen: für die Verarbeitung von visuellem und auditivem Material, für die Generierung von Verben (Syntax) und Substantiven, für automatisches und für geplantes Sprechen sowie für die Produktion einzelner und multipler Phoneme ( siehe Abb. 4 ). So wie sich nicht auf eine bestimmte Hirnregion deuten läßt, die "sieht" oder sich "erinnert", läßt sich auch kein Ort lokalisieren, der "redet". Die Sprachfähigkeit hängt von einem komplexen Gefüge sensorischer Integration, symbolischer Assoziation, motorischer Fertigkeiten, gelernter syntaktischer Muster und dem verbalen Gedächtnis sowie dem begrifflichen und kategoriespezifischen Wissen ab ( siehe Tab. 2 ).

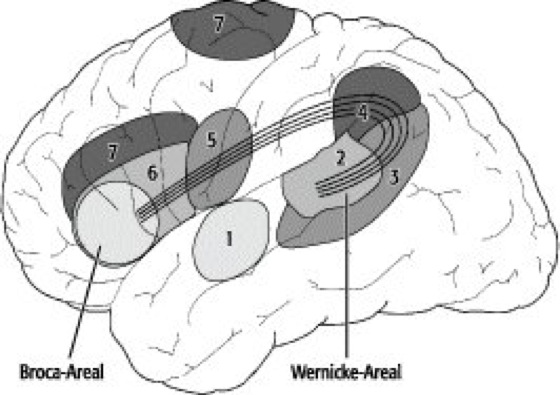

Läsionen: Alle diese Komponenten können ganz, teilweise oder kombiniert ausfallen ( siehe Abb. 5 , siehe Zusatzinfo 5 ). Eine Fülle von Sprachstörungen sind die Folge solcher Läsionen: Aphasie (z.B. amnestische Aphasie, Broca-Aphasie, globale Aphasie, Leitungsaphasie, Wernicke-Aphasie, vgl. Aphasie, Tab. 2), Agrammatismus, Agraphie, Alexie, Anomie, Aprosodie, Anarthrie, Dysarthrie, Sprechapraxie. Der Schweregrad einer Aphasie variiert bei Läsionen in der Broca-Region stärker als in der Wernicke-Region, was vielleicht vom Ausmaß der subcorticalen Schädigung abhängt, die zu einer Verletzung der Broca-Region hinzukommen kann. Auch Läsionen der Insula können zu einer schweren Aphasie führen. Subcorticale Strukturen sind für die Sprachfähigkeit ebenfalls von Bedeutung, insbesondere der linke posteriore Thalamus einschließlich des Pulvinar thalami, des Nucleus posterolateralis und Nucleus lateralis ventralis. Läsionen dort führen zu Sprechstörungen, z.B. Perseveration und verlangsamter Sprechgeschwindigkeit, oder zu einer, meist vorübergehenden, Dysphasie. Der Sprachgebrauch in der alltäglichen Kommunikation beruht allerdings nicht nur auf bestimmten Fähigkeiten, die z.B. bei einer Aphasie selektiv gestört sind, sondern erfordert auch pragmatische Kenntnisse, die auf dem Einhalten von Konventionen und der Beachtung situationsgebundener Informationen beruhen. Diese Fähigkeiten können durch rechtsseitige Läsionen oder ein Schädel-Hirn-Trauma beeinträchtigt werden, insbesondere wenn vordere Cortex-Areale betroffen sind ( siehe Tab. 1 ).

Zusammenfassung: Bislang gibt es kein einheitliches Modell, das alle diese Ausfälle sowie die anderen neurowissenschaftlichen Erkenntnisse vollständig und widerspruchsfrei erklären kann. Das erste umfassende, nur auf dem Studium von Läsionen beruhende Modell, das noch immer populäre Wernicke-Geschwind-Modell, reicht nicht aus, um alle heute bekannten Fakten verständlich zu machen. Auch läßt sich der alte Streit zwischen einer holistischen oder einer modularen, lokalisierten Organisation der neuronalen Systeme für die Sprachfähigkeit nicht eindeutig entscheiden (modulare Systeme): sowohl für die eine als auch für die andere Position gibt es Indizien. Fest steht aber, daß die Sprachfähigkeit auf einem hierarchischen, parallelen Netzwerk zahlreicher corticaler und subcorticaler Strukturen besteht. Insbesondere drei große Systeme stehen bei der Sprachproduktion und dem Sprachverständnis in enger Wechselwirkung: 1) Das Implementierungssystem (E language implementation system) umfaßt das Broca- und Wernicke-Areal, Teile der Insula sowie die Basalganglien. Es verarbeitet auditorische Sprachsignale, aktiviert das begriffliche Wissen, ist für phonetische und syntaktische Analyse und Bildung zuständig sowie für die Artikulation. 2) Das Mediationssystem (E mediational system) beruht auf vielen verschiedenen Regionen im Schläfen-, Scheitel- und Frontallappen. Es vermittelt zwischen dem Implementierungssystem und dem Begriffssystem. 3) Das Begriffssystem (E conceptual system) basiert auf zahlreichen weiteren Regionen der höherstufigen Assoziationscortices, in denen das begriffliche Wissen (Lexikon) repräsentiert wird.

Spracherwerb

Konzept der angeborenen Universalgrammatik: Alle menschlichen Sprachen basieren auf ähnlichen Prinzipien. Jedes nicht behinderte oder sozial deprivierte Kind kann sich jede beliebige Sprache aneignen oder auch zwei und mehr. Einzelsprachen werden erlernt, aber die Fähigkeit, eine Sprache zu erlernen, ist angeboren. Einzelkinder, die ohne sprachliche Umgebung aufwachsen ("Wolfs-" oder "Kaspar-Hauser-Kinder"), bleiben stumm, doch mehrere Kinder in einer sprachlich deprivierten Umwelt erschaffen sich gemeinsam eine eigene Sprache. So entstanden z.B. manche Gebärdensprachen Taubstummer; und Kinder, die im 18. und 19. Jh. im sprachlichen Mischmasch von Sklaven ohne richtige Muttersprache aufwuchsen, entwickelten aus deren Pidgin-Sprachbrocken syntaktisch differenzierte sogenannte Kreolensprachen. (Pidginsprachen sind phonologisch, morphologisch und syntaktisch stark reduzierte Kommunikationsformen mit einem geringen Wortschatz, die sich in Notsituationen herausbilden, wenn Menschen keine gemeinsame Sprache haben). Dies spricht dafür, daß es eine angeborene neuronale Grundlage des Spracherwerbs gibt (E language acquisition device, Abk. LAD), eine Universalgrammatik im Kopf jedes Menschen, wie Noam Chomsky vorgeschlagen hat. Dafür spricht auch, daß Kinder in einer bis zur Pubertät reichenden kritischen Periode (sensitive Phase) eine Sprache viel schneller und auf andere Weise lernen als Erwachsene (und Läsionen viel besser kompensieren können), obwohl ihnen anderes, weniger komplexes Wissen viel länger unzugänglich bleibt. Die Hypothese ist allerdings umstritten, da die Kapazität für den Spracherwerb auch ein Spezialfall einer breiter angelegten Fähigkeit der Mustererkennung sein könnte, so daß es in diesem Fall kein spezifisches LAD im Gehirn gäbe. Dagegen wiederum sprechen aber erblich bedingte spezifische Sprachentwicklungsstörungen, die trotz intakter genereller Intelligenz, Sinneswahrnehmungen, sozialer Fähigkeiten usw. mit einer starken Beeinträchtigung des Sprechens und Verstehens einhergehen, insbesondere der Syntax. Umgekehrt gibt es mental stark zurückgebliebene Kinder (z.B. mit Williams-Beuren-Syndrom), deren Sprachfähigkeit nahezu unversehrt ist. Außerdem haben Sprachen syntaktische Eigenschaften, die den Begriffen und Kategorien des Denkens zuwiderlaufen, aber mühelos gelernt werden. Z.B. hat "Es" in den Sätzen "Es [das Kind] rennt" und "Es regnet" dieselbe syntaktische Funktion (beide sind das Subjekt des Satzes und können zur Frage umgestellt werden: "rennt/regnet es?"), obwohl "Es" im zweiten Fall ein grammatikalischer Platzhalter ohne kognitiven Gehalt ist.

Stufen des Spracherwerbs: Grob läßt sich normale Sprachentwicklung einteilen in die Lallphase mit Schnalzlauten (Ausprobieren der Sprechorgane), die Einwortphase, die Zweiwortphase und die Mehrwort- oder Satzphase. Schon kurz nach der Geburt können Kinder Sprachlaute unterscheiden, auch solche, die in der Sprache ihrer Umwelt nicht vorkommen. Babys japanischer Sprecher sind z.B. in der Lage, /l/ und /r/ zu diskriminieren (wie Verhaltenstests und ereigniskorrelierte Potentiale zeigen), was sie mit etwa zehn Monaten nicht mehr können. Die einzelsprachspezifische Phonem-Wahrnehmung basiert also auf einem aktiven Verlernen. Sieben Monate alte Säuglinge können ihnen bekannte Wörter noch 24 Stunden später aus längeren Passagen heraushören. Nach Schreien und Gurren sowie (ab etwa dem vierten Monat) Babbeln und Plappern beginnen Kinder mit fünf bis sieben Monaten sprachähnliche Laute zu formen, mit sieben bis acht Monaten Silben ihrer Muttersprache zu babbeln, und einige Monate später produzieren sie satzähnliche Lautketten (die Babysprache der Erwachsenen erleichtert durch die Wiederholungen und höhere Tonlage das lautliche Nachahmungslernen). Die ersten Wörter sprechen sie ungefähr zwölf Monate nach der Geburt, und ab dem 18. Monat wächst ihr Wortschatz rapide an. Mit drei Jahren beherrscht ein Kind bis zu 2000 Wörter aktiv (mit Deklinations- und Verbformen sogar 3000 Lexeme). Mädchen sind den Jungen in der Entwicklung oft zwei bis drei Monate voraus. Sechsjährige können rund 13000 Wörter verstehen, Abiturienten über 50000. Das heißt, daß Kinder alle 100 Minuten ihrer wachen Zeit eine Wort-Bedeutung-Assoziation lernen. Syntaktische Einsichten zeigen sich bereits in der Zweiwortphase (etwa ab dem 18. Monat). Ab dem zweiten Lebensjahr beginnen Kinder Phrasen und Sätze zu produzieren und Artikel, Präpositionen usw. zu verwenden und lernen Verneinungen, Frage- und Befehlsformen. Mit drei gebrauchen sie grammatische Wörter meist richtig, kennen fast alle syntaktischen Formen und werden allmählich richtige Gesprächspartner. Vorübergehend kommt es zu individuellen Regeln oder Übergeneralisierungen, z.B. Pluralbildung immer mit "e" (z.B. Tisch/Tische, Ball/Balle) oder Partizip-Bildung mit "t" (z.B. lachen/gelacht, laufen/gelauft). Bis zum fünften Jahr beherrschen die Kinder die meisten syntaktischen Regeln und benutzen und beugen z.B. auch die starken Verben korrekt.

Semantisch lassen sich folgende wichtige Neuerungen in der kindlichen Sprachentwicklung hervorheben: 1) Von den Lautungen der ausgehenden Lallphase zu den typischen Kinderwörtern und einzelsprachlichen Ausprägungen: Spontan artikulierte, aber noch sinnfreie Lautungen werden von den Bezugspersonen aufgegriffen und mit dem Sinn gefüllt, den sie den Lautmustern zuerkennen. Dabei werden einzelsprachliche Gewohnheiten deutlich. Beispiel: "Mama" = Mutter; ähnlich auch in anderen Sprachen z.B. "mamar", span. = stillen, säugen; "mama", jap. = essen; aber "Mama", georgisch = Vater (Mutter = "Dedar"). 2) Onomatopoetische (lautmalende) Bildungen: Das Kind versucht Lautnachahmungen von Geräuschen, mit oder auch ohne Unterstützung der Erwachsenen, und gelangt zu kindertümlich onomatopoetischen Bildungen, die auf diese Geräusche und deren Quellen hinweisen. Beispiel: "brrr" = Auto. 3) Imitation bzw. Repetition: Nachahmung gehörter Laute, oft mit lautmalerischen Bezügen; das Kind versucht, aus der Situation heraus den Sinn zu erfassen, meist mit Hilfe der Erwachsenen. Beispiel: "ticktack" = Uhr, "wauwau" = vierbeiniges Lebewesen (Hund). 4) Globalworte: Erste sinnhaltige Lautungen werden für zahlreiche verschiedene, jedoch meist verwandte Gegenstände gebraucht. Einschränkungen folgen erst später. Beispiel: "Papa" = große Menschen, wird zu Männer, dann Väter (Männer mit Kindern) und schließlich zum eigenen Vater (nur ein Fallbeispiel, tritt keineswegs bei allen Kindern exakt so auf). 5) Orientierung an normsprachlichen Bezeichnungen: Eine sinnerfüllte Lautung wird für einen Gegenstand bzw. eine Erscheinung und deren Gegenteil verwendet. Beispiel: "obn" = oben, unten; "(h)eiß" = heiß, kalt. 6) Erste Eigennamen (beginnende Unterscheidung von Name und Wort = nomen proprium/appellativum). Beispiel: Vornamen anderer Kinder. 7) Zunehmende Bezeichnungsdifferenzierung: Die zunächst auf ähnliche Phänomene ausgedehnten Wortgebilde werden nach dem Erwerb differenzierender Nachbarbezeichnungen auf den Gegenstandsbereich eingeschränkt, für den sie in der geltenden Sprachnorm vorgesehen sind. Beispiel: "wauwau" = "Vierbeiner" wird zu "Hund". 8) Ablösung kindertümlicher durch normsprachliche Bezeichnungen. Beispiel: "mamam" wird zu "Essen". 9) Aufbau von Begriffsordnungen mit Ober- und Unterbegriffen: Neue, zutreffende Oberbegriffe lösen vorläufige kindertümliche Sammelbegriffe ab. Beispiel: "wauwau" wird zu "Tier". 10) Oberbegriffe der Erwachsenensprache, die für den Umgang des Kindes unwichtig sind, werden erst nach dem dritten Lebensjahr gelernt. Beispiel: "Essen/Nahrungsmittel" folgt lange nach "Milch, Brot, Butter" usw.; "Geschirr" nach "Tasse, Becher, Teller" usw.; "Möbel" nach "Stuhl, Tisch, Bett" usw. Die Gewinnung gültiger Oberbegriffe ist zunächst weniger eine Abstraktionsleistung als dem Vorteil zu verdanken, vieles ansprechbar und damit erreichbar zu machen. Leitprinzipien des kindlichen Spracherwerbs sind Effektivität und Ökonomie.

Sprache bei Tieren?

Zu Unrecht als Sprache bezeichnet werden Lautäußerungen von Vögeln, z.B. Papageien, die in der Lage sind, menschliche Wörter und Laute täuschend ähnlich "nachzusprechen". Hier handelt es sich bloß um Nachahmung. Die natürlichen Kommunikationsformen bei Tieren unterscheiden sich stark von der menschlichen Sprache. Sie beruhen auf einem der folgenden drei Prinzipien: 1) ein eng begrenztes Repertoire von Rufen, z.B. um vor Feinden zu warnen oder ein Territorium für sich zu beanspruchen (auch menschliche Säuglinge haben solche angeborenen, universellen Schreie: für Hunger und Schmerz); sie werden in der Regel instinktiv geäußert; 2) ein kontinuierliches analoges Signal, das die Stärke einer bestimmten Bedingung mitteilt, z.B. die Entfernung und Richtung einer Futterquelle beim Bienentanz; 3) Sequenzen scheinbar zufällig angeordneter Signale, die ein bestimmtes Thema variieren, z.B. im Gesang der Singvögel. Es gibt keinen Hinweis auf die Existenz einer diskreten, potentiell unendlichen kombinatorischen Vielfalt bedeutungstragender kommunikativer Elemente anderswo als in der menschlichen Sprache. Manche Spezies können aber lernen, bestimmte Aspekte menschlicher Sprache zu imitieren oder zu erwerben. Ob diese Fertigkeiten homolog zur menschlichen Sprache sind, also ähnliche Eigenschaften und eine gemeinsame evolutionäre Abstammung aufweisen, oder ob sie analog sind, ist umstritten. Immerhin zeigen Menschenaffen, die von Kindheit an unter Menschen aufwachsen, erstaunliche Fähigkeiten ( siehe Zusatzinfo 6 ). So haben die Bonobos (Zwergschimpansen) Kanzi, Panbanisha und Nyota ohne Anweisung viele hundert englische Wörter ihrer Pfleger gelernt, ferner über 300 verschiedene Lexigramme: abstrakte Symbole auf einer Computertastatur, die für einzelne Wörter wie "Banane", "auf", "im" und "Eimer" stehen ( siehe Abb. 6 ). Damit können sie mit Menschen kommunizieren, aber auch untereinander. Hunderte strenger, detaillierter Tests haben erwiesen, daß die Menschenaffen die Wörter und Lexigramme verstehen sowie Objekten, Fotos, Handlungen und anderen Lexigrammen zuordnen können, und zwar auch in Kontexten und Kombinationen, die neu sind. Sagt man Kanzi beispielsweise, er soll ein Foto mit einer Banane unter verschiedenen Bildern auswählen oder eine Tomate aus dem Mikrowellenherd holen, tut er dies fast immer korrekt. Er bringt die Tomate auch dann, wenn eine andere direkt vor ihm auf dem Tisch liegt. Er versteht selbst Worte von einer künstlichen Computerstimme oder von Menschen, denen er nie zuvor begegnet ist. Sein Verständnis kurzer englisch gesprochener Sätze ist so gut wie das zwei- bis zweieinhalbjähriger Kinder. Er berücksichtigt sogar grammatische Beziehungen zwischen den Wörtern und hält bestimmte Wortordnungen ein. Z.B. unterscheidet er, ob die Schlange den Hund oder der Hund die Schlange beißt. Mit Spielzeugtieren ahmt Kanzi die beiden Aktionen auf Anweisung korrekt nach. Die Lexigramme eignen sich übrigens sogar zur Kommunikation mit stark geistig und sprachbehinderten Menschen, von denen allein in den USA über eine Million leben. – Linguisten wiesen die Forschungsberichte lange als übertrieben oder unglaubhaft zurück. Noam Chomsky hält die Vorstellung von sprechenden Affen für Wunschdenken: "Diese Art von Forschung ist eine Form des Fanatismus." Die Interpretation sei irrational, weil nur Menschen ein Sprachmodul im Gehirn hätten, eine angeborene Universalgrammatik, die allen Einzelsprachen zugrunde liege. Tieren sprachliche Fähigkeiten beizubringen sei daher, als wolle man Menschen das Fliegen lehren, indem man sie mit den Armen flattern ließe. "Menschen können zehn Meter weit fliegen. Das tun sie bei der Olympiade. Aber ist das Fliegen?" Allerdings sind das Satzverständnis der Bonobos und ihre Lexigramm-Botschaften nicht auf Nachahmungen beschränkt, und sie lassen sich nicht auf einen "Kluger-Hans-Effekt reduzieren" (nach einem Pferd, das angeblich rechnen konnte, aber in Wirklichkeit nur auf unbewußte Signale seines Halters reagierte). Die Affen verstehen auch Wortfolgen, die sie niemals zuvor gehört haben, und sie prägen selbst neue Wortkombinationen, die im jeweiligen Kontext Sinn machen. Zuweilen korrigieren die Bonobos ihre menschlichen Partner sogar, belügen sie oder informieren sie über Ereignisse, von denen sie nichts wissen. Die in einem englischsprechenden kulturellen Umfeld aufwachsenden Bonobos machen auch spontane Versuche zu sprechen. Aufgrund der anatomischen Gegebenheiten modifizieren sie die Laute allerdings auf eine Weise, die für englische Sprecher nicht unmittelbar verständlich ist. Akustische Spektralanalysen zeigten aber, daß die Laute, die Kanzi von sich gab, als er bestimmte Nahrungsmittel auswählte oder haben wollte, zumindest teilweise keine zufällig erzeugten, ständig veränderlichen Geräusche waren, sondern wie Wörter verwendet wurden. Für Objekte wie Banane, Melone, Grapefruit, Saft und Sellerie haben die zeitabhängigen Frequenzkurven der Spektrogramme statistisch eindeutige Charakteristika. Die jeweiligen Vokalisationen ähneln sich innerhalb der Kategorien und unterscheiden sich zwischen den Kategorien: Sie sind lexikalisch signifikant. "Je mehr wir über die Bonobos in Erfahrung bringen, desto raffinierter scheinen uns ihre Kommunikationsmöglichkeiten", sagt Sue Savage-Rumbaugh. Als sie Mitte der 1990er Jahre eine Zeit lang wilde Zwergschimpansen im Kongo beobachtete, fand sie Indizien für komplexe Verständigungsprozesse. Bonobos leben nämlich in großen Gruppen und müssen ihre Wanderungen koordinieren. Dafür liegt eine akustische Verständigung im dichten Dschungel mit eingeschränkter Sicht nahe. Außerdem scheinen sie Wegmarkierungen für Nachzügler anzulegen. Möglicherweise sind also nicht die Affen, sondern wir begriffsstutzig. "Vielleicht hat uns unsere kulturelle Basis bislang davon abgehalten, die Existenz der Sprache bei wilden Schimpansen zu erkennen", spekuliert Sue Savage-Rumbaugh. "Wenn wir sie verstehen wollen, müssen wir von unseren kulturzentrierten Methoden Abstand nehmen und mit ihnen im Regenwald leben." Übrigens: Panbanisha überraschte kürzlich die Forscher, als sie Strichmuster mit einer Kreide auf den Boden malte: Einige sahen den Lexigrammen verblüffend ähnlich: Panbanisha hatte selbständig mit Schreibversuchen begonnen.

Ursprung und Evolution der Sprache

Nichts steht dagegen, daß die Sprachfähigkeit und ihre neuronalen Grundlagen ein Produkt der Evolution sind; daraus folgt aber nicht notwendigerweise, daß Vorstufen der menschlichen Sprache heute noch bei anderen Spezies zu finden sind. Homo sapiens hat sich von seinen nächsten lebenden Verwandten, den Schimpansen und Bonobos, schon vor rund sechs bis acht Millionen Jahren getrennt. Diese Zeitspanne entspricht etwa 300000 Generationen seit dem letzten gemeinsamen Ahnen, in denen sich die menschliche Sprachfähigkeit mehr oder weniger graduell entwickelt haben könnte, selbst wenn die sprachlichen Leistungen von Kanzi und anderen Affen denen der Menschen nicht homolog, sondern analog wären. Sprachursprung und Sprachevolution liegen freilich im Dunkel der Vorgeschichte verborgen und sind daher seit Jahrhunderten Gegenstand wilder Spekulationen und teilweise kurioser Thesen ( siehe Tab. 3 ). Fest steht, daß bestimmte Fähigkeiten notwendige Voraussetzungen für die Evolution des Sprachvermögens waren: eine willentliche Kontrolle der Atmung (Willkürmotorik), eine Veränderung des Vokaltraktes ( siehe Zusatzinfo 7 ) sowie neuronale Entwicklungen zur Steuerung der Sprechmotorik, zur Fähigkeit lautlicher Imitationen und der Herausbildung von Syntax. – Homo habilis hat vor 2,5 bis 2 Millionen Jahren bereits Werkzeuge hergestellt, und aus Abdrücken seines Schädelinneren wurde auf Asymmetrien der Großhirnhälften geschlossen einschließlich der Windungen, die bei heutigen Menschen eine Voraussetzung der Sprachfähigkeit sind (Broca-Region, supramarginaler und angularer Gyrus). Homo erectus besiedelte von Afrika aus vor 1,5 bis 0,5 Millionen Jahren Europa und Asien und verwendete das Feuer. Ob und wie gut er und auch schon Homo habilis sprechen konnten und inwiefern das zu ihrer Ausbreitung beitrug, ist unklar. Auch die sprachlichen Fähigkeiten des Neandertalers sind umstritten ( siehe Zusatzinfo 7 ). Homo sapiens sapiens entstand wohl vor etwa 200000 Jahren in Afrika und verließ den Kontinent vor 100000 Jahren. Er schuf komplexere Werkzeuge als die anderen Frühmenschen und konnte wahrscheinlich sprechen. Die großen Populationen ("Rassen") haben vor vielleicht 50000 Jahren begonnen, sich auseinander zu entwickeln. Da sie heute alle ununterscheidbare sprachliche Fähigkeiten besitzen, gilt diese Zeit meist als jüngstes Datum für eine vollentwickelte Sprachfähigkeit. Die ältesten bekannten Schriftzeichen sind demgegenüber mehr als 5000 Jahre alt.

Kategorisierung und soziale Kognition: Sprache ist ein nützliches Werkzeug und Medium für explizite Repräsentationen und Metarepräsentationen einschließlich Ich-Bewußtsein, Handlungsabsichten und höherstufige Wünsche (Willensfreiheit). Dadurch werden äußere und innere Zustände besser abgebildet und stehen einer Bewertung effektiver zur Verfügung, was wiederum einen Zugewinn an Handlungsspielraum zur Folge hat, insbesondere in komplexen sozialen Situationen. Intentionale Einstellung, soziale Kognition und Sprachvermögen haben somit wahrscheinlich koevolutionär miteinander interagiert und sich in ihrer Entwicklung gegenseitig verstärkt. Damit scheint auch die rapide Volumenvergrößerung der Großhirnrinde um das Drei- bis Vierfache in den letzten fünf Millionen Jahren der menschlichen Evolution zusammenzuhängen. Allerdings ist es unwahrscheinlich, daß der Ursprung der Sprache direkt in der sozialen Kognition wurzelt. Zum einen weisen auch unsere "sprachlosen" Verwandten ein komplexes Sozialverhalten auf. Zum anderen sind für leistungsfähigere Repräsentationen komplexe syntaktische Strukturen erforderlich, denn andernfalls wäre die Mehrdeutigkeit von Wörtern und ihren Referenten und Relationen mehr verwirrend als hilfreich. Eine primitivere Protosprache hat sich deshalb wohl zunächst aufgrund anderer Selektionsfaktoren entwickelt ( siehe Zusatzinfo 8 ). Besonders der enorme Vorteil einer besseren Kategorisierung ist hier von Bedeutung: Schon mit Hilfe eines kleinen Wortschatzes (Namen und abstrakte Beschreibungen) verbunden mit Gestik können Gefahren, Nahrungsplätze, gute und schlechtere Nahrungsquellen usw. identifiziert und mitgeteilt sowie Handlungen koordiniert werden. Die Folge ist ein Gewinn von Zeit und eine Verminderung von Energie und Risiko. Da die Mitteilung von Informationen meist nur mit geringen Kosten verbunden ist, fallen Täuschungen und Lügen kaum ins Gewicht, und der reziproke Altruismus kann sich ausbreiten. Basierend auf dem Nutzen der Kategorisierung sowie anderer Merkmale (Benennung, Warnrufe, Ausdruck von Emotionen usw.) konnte die Protosprache ihr lexikalisches und syntaktisches Inventar erweitern. So wurde sie schließlich auch in sozialen Kontexten mehr und mehr relevant, bis hin zu einer "Waffe" im zwischenmenschlichen Kampf ums Dasein (einschließlich Lügen und Bündnispolitik), ein Werkzeug für die soziale Intelligenz, ein Mittel für die Ausbildung von Kultur und die generationenübergreifende Weitergabe von Wissen. Sprache ist eines der wichtigsten Instrumente, um die Welt zu verstehen und zu verändern.

Sprachfamilien

Die Verschiedenheit der Sprachen ist das wohl faszinierendste Zeugnis von der Vielfalt der menschlichen Natur. Heute gibt es noch ungefähr 6000 Sprachen auf der Erde, wobei die meisten nicht verschriftlicht sind und sich einige nur schwer voneinander abgrenzen lassen (viele Übergänge von Dialekten). Mit der Untersuchung von Wortschatz, Lautinventar und syntaktischen Eigenheiten können Sprachverwandtschaften ermittelt werden. Sprachen lassen sich dann in Gruppen, Familien und, in spekulativerer Form, sogar Superfamilien und Stämme unterteilen. Je umfassender die Taxa sind, desto umstrittener ist die Klassifikation auch. Die rund zwei Dutzend beschriebenen Sprachfamilien entstammen einer jeweiligen Stammform, die bis zu 10000 Jahre alt ist. Daß Sprachen eine Entwicklungsgeschichte haben und sich diese als Stammbaum rekonstruieren läßt, ist schon Ende des 18. Jh. erkannt worden, Jahrzehnte bevor Charles Darwin seine epochale Abhandlung "Von der Entstehung der Arten" schrieb. Durch die Methode des Sprachvergleichs wurde z.B. die Verwandtschaft fast aller europäischen Sprachen (außer Finnisch, Ungarisch, Baskisch und Etruskisch) sowie der iranischen und indischen Sprachgruppe offenkundig. Ihr Wortbestand sowie die bekannten grammatischen Strukturen der heutigen, aber auch einiger ausgestorbenen und überlieferten Sprachen (wie Latein, Gotisch, Keltisch) lassen sich auf eine gemeinsame, rekonstruierbare Ursprache zurückführen. Seither werden alle diese Sprachen in der Sprachfamilie des Indoeuropäischen (oder Indogermanischen) zusammengefaßt. Sie besteht aus 140 Einzelsprachen und ist heute mit mehr als zwei Milliarden Sprechern, bedingt hauptsächlich durch die Kolonisierungen seit dem 15. Jh., auf der Erde dominant. Mit gröberen Methoden, insbesondere der multilateralen Analyse (statistischer Massenvergleich), wird nach noch größeren Verwandtschaftsbeziehungen gesucht. Eine dieser Superfamilien wird das Eurasiatische oder Nostratische genannt und umfaßt neben dem Indoeuropäischen auch Türkisch, Mongolisch, Koreanisch und Japanisch. Neuerdings helfen genetische Verwandtschaftsanalysen beim Studium der Sprachverwandtschaften, weil die genetischen Stammbäume aufgrund der langen, relativ weitreichenden Isolation der Völker mit den linguistischen weitgehend parallel laufen. Ob alle Sprachen aus einer gemeinsamen Wurzel stammen, ist unbekannt.

Sprachverbreitung

Man kann zwei Typen von Spracharealen unterscheiden: Ausbreitungszonen, große Gebiete, die nur eine oder zwei Sprachfamilien beherbergen (wie Europa oder Nordafrika), und Restzonen, wo viel mehr Familien angesiedelt sind (das gilt etwa für den Kaukasus oder Neuguinea), die häufig Relikte aus ferner Vergangenheit darstellen. Die sprachliche Verschiedenheit ist – nach bisherigen empirischen Feststellungen – besonders groß: weit von den Polregionen entfernt; wo genug Regen fällt oder allgemein Wasser vorhanden ist; wenn Gebirge Isolationsbarrieren bilden (im Kaukasus gibt es beispielsweise 30 Sprachen, die zu sieben verschiedenen Familien zählen); an Küsten (weil sich hier viel Nahrung über das ganze Jahr hinweg finden läßt, weil das Klima gemäßigter ist, weil kleine Gruppen relativ autark bleiben können und es viele Gelegenheiten zu Kontakten mit Angehörigen anderer Sprachen gibt); je weiter die ökonomischen Verhältnisse entwickelt sind (was einhergeht mit Ackerbau, Handelszentren, heute auch Industrialisierung), denn damit hängen in der Regel ein großes Territorium, eine hohe Bevölkerungsdichte und ein stärkerer kultureller und damit auch sprachlicher Austausch mit Nachbarregionen zusammen. Der letztgenannte Punkt, die Ökonomie, ist der wichtigste Faktor, da hier alle anderen Aspekte mehr oder weniger stark hineinspielen. Schließlich kann die sprachliche Verschiedenheit auch durch Kolonisierung und Völkerwanderungen zunehmen. Weitere historische Faktoren spielen immer eine Rolle. – Grundsätzlich lassen sich vier Mechanismen der Sprachverbreitung unterscheiden: 1) Die Erstkolonisierung einer unbewohnten Region geschah zum einen durch Erstbesiedlung infolge der Verbreitung des Homo sapiens von seinem afrikanischen Entstehungsort. Als Spuren dieser Wanderungen erhalten sind Baskisch, die kaukasischen und die Khoi-San-Sprachen, Australisch, Indopazifisch und Amerind. Zum anderen begünstigen Klimaänderungen die Besiedlung neuer Regionen. Insbesondere kam es nach dem Ende der letzten Eiszeit vor rund zehntausend Jahren zu einer globalen Erwärmung. Dies eröffnete die Möglichkeit, sich nördlich des 54. Breitengrads anzusiedeln. Die Familien, die sich aus Pioniersprachen entwickelt haben, sind Uralisch-Jukagirisch, Tschuktschisch-Kamtschatkisch, Na-Dené und Eskimo-Aleutisch. 2) Für die Ersetzung (Verdrängung einer Sprache durch eine andere) am wichtigsten ist die Einführung der Landwirtschaft, die mehrfach und unabhängig voneinander in verschiedenen Regionen der Welt zu verschiedenen Zeiten erfolgte. Der Ackerbau hatte einen starken Anstieg der Bevölkerung und deren räumliche Ausbreitung zur Folge, wodurch die noch vorhandenen Jäger und Sammler mit ihren Sprachen verdrängt oder amalgamiert wurden. Auf diese Weise erklären läßt sich z.B. die Entstehung und Ausbreitung der indoeuropäischen Sprachen, deren Ursprung im anatolischen Raum liegt. (Man schätzt, daß es vor 15000 Jahren, also vor der Erfindung der Landwirtschaft, noch 10000 Sprachen gegeben hat, obwohl die Zahl der Menschen damals vielleicht ein Fünfhundertstel der heutigen betrug.) Außerdem gibt es Sprachersetzungen aufgrund von Handel und Eroberung. Beispiele hierfür sind die Ausbreitung des Chinesischen, des Lateinischen, der altaischen Sprachen in Zentralasien und des Indoeuropäischen, das mit dem Aufkommen nomadischer Hirten schon im 2. Jh. v. Chr. in den Iran sowie nach Pakistan und Nordindien gelangte und im Zuge der Kolonisierung ab dem 15. Jh. auch in Amerika und Australien dominant wurde. 3) Wenn Ersetzungen nicht stattgefunden hätten, wäre Divergenz (Auseinanderentwicklung) die Hauptursache für den Wandel der Sprachen. Die Weltkarte gliche dann einem sprachlichen Flickenteppich. Ein solches Mosaik findet man beispielsweise noch für die Eingeborenensprachen Nordaustraliens, die Gartenbaukulturen auf Neuguinea sowie für den Kaukasus. 4) Schließlich gibt es die Konvergenz, d.h. die Beeinflussung gleichzeitig gesprochener Sprachen durch Entlehnung von Wörtern, Phrasen und grammatischen Formen. – Heute wütet ein rasantes Sprachen-Aussterben. Ein Drittel aller Sprachen weltweit sind akut bedroht, da sie mittlerweile weniger als tausend Sprecher haben! Da vermutlich alle Sprachen mit weniger als 100000 Sprechern im Verlauf der nächsten Jahrhunderte ebenfalls gefährdet sind, bleiben vorläufig nur etwa 600, d.h. 10%, in der "sicheren" Kategorie (von denen sich einige freilich wieder zu neuen Sprachen differenzieren werden). Der Schatz an Wörtern, grammatischen Strukturen, Ausdrucksmitteln und nicht zuletzt auch Denkweisen und innewohnende Weltinterpretationen, der mit dem Verschwinden der Sprachen verlorengeht, ist unermeßlich. Weil viele Sprachen nur rudimentär dokumentiert sind, läßt sich der bevorstehende geistige, kulturelle und wissenschaftliche Verlust noch nicht einmal richtig abschätzen.

Sprache, Denken, Wirklichkeit

Sprache ist vom Denken zu unterscheiden, das durch mentale Repräsentationen und Schlußfolgerungen gekennzeichnet ist und sich auf sprachliches Material (Wörter, Sätze) beziehen kann, aber nicht muß. Es gibt auch nichtsprachliche Gehalte des Denkens (Bilder, abstrakte Begriffe und Propositionen, Melodien usw.), so daß auch Tiere, Säuglinge und Aphasiker ohne Sprache denken können. Denken ist also nicht mit Sprache identisch, aber in vielerlei Hinsicht von ihr geprägt und abhängig. Bis weit ins 18. Jh. herrschte im abendländischen Kulturraum die fast allgemeinverbindliche Auffassung, die Sprache stelle lediglich eine Art Spiegel des Denkens dar, ein bloßes Hilfsmittel des Verstandes, der die Wirklichkeit getreu zu erfassen vermag. Durch Überlegungen von Johann Georg Hamann, Johann Gottfried Herder und Wilhelm von Humboldt sowie linguistische und ethnologische Studien von Franz Boas, Edward Sapir und Benjamin Lee Whorf wurde jedoch fraglich, inwiefern menschliches Denken nicht entscheidend von der Struktur der jeweiligen Einzelsprache abhängen könnte, inwiefern diese ein konstitutiver Faktor im Erkenntnisprozeß ist, inwiefern jeder Sprache eine besondere Weltsicht innewohnt und sich Sprecher verschiedener Sprachen gleichsam in verschiedenen gedanklichen Welten bewegen (Sapir-Whorf-Hypothese). "Sind unsere Begriffe von 'Zeit', 'Raum', und 'Materie'", so ist mit Whorf zu fragen, "wesentlich durch die Erfahrung bestimmt und daher für alle Menschen gleich, oder sind sie zum Teil durch die Struktur besonderer Sprachen bedingt? Gibt es faßbare Affinitäten zwischen a) kulturellen Normen und Verhaltensregeln und b) großen sprachlichen Strukturen?" Inwieweit können wir unsere Um- und Mitwelt nur durch die "Brille" unserer Muttersprache wahrnehmen? Zappeln wir wie Fliegen in ihrem Begriffsnetz, sind wir Marionetten unseres Wortschatzes und unserer Grammatik, sind die Grenzen unserer Sprache also die Grenzen unserer Welt? Muß uns die Wirklichkeit jenseits der Sprache verschlossen bleiben? Und sind die Weltbilder anderer Kulturen mit anderen Sprachen so grundverschieden, daß eine Verständigung zur Farce wird?

Als Prinzip wäre die Sapir-Whorf-Hypothese im strengsten Sinn höchstens illustrierbar, aber nicht hintergehbar und schon gar nicht wissenschaftlich zu überprüfen, und dann womöglich eine leere Tautologie. Eher scheint die These aber eine Grundannahme der Forschung zu sein und somit eine regulative Idee. Oft ist sie jedoch als wissenschaftliche Hypothese gelesen worden und hat zu vielen Untersuchungen angeregt ( siehe Tab. 4 ). Zu unterscheiden sind ferner die Interpretationen der Sapir-Whorf-Hypothese 1) als kognitive Abhängigkeitsthese, nach der das mit einer bestimmten Sprache übernommene Begriffsschema Erfahrung und Denken des einzelnen Menschen prägt; 2) als Sprachabhängigkeitsthese, die das Begriffsschema als notwendig sprachlich erweist; 3) als Relativitätsthese, die besagt, daß die verglichenen Sprachen unterschiedliche Begriffsschemata enthalten, denen jeweils eine verschiedene Weise des Denkens und des Erfahrens entspricht. Relativistische Positionen können total oder radikal sein (es gibt keine oder nur wenige Gemeinsamkeiten zwischen zwei Begriffsschemata), sie können sich aber auch auf kleine oder nur irgendwelche Unterschiede (sogar bloß einen) beschränken. Bei genauer Betrachtung stecken also mindestens zwei Behauptungen in der Sapir-Whorf-Hypothese, nämlich eine deterministische (Denken und Weltsicht eines Individuums sind durch die Sprache bestimmt) und eine relativistische (die Einzelsprache bedingt durch ihre Struktur die Weltsicht eines Individuums bzw. einer Gesellschaft, und unterschiedliche Sprachstrukturen implizieren unterschiedliche Weltbilder). Beide Behauptungen können in einem schwachen und in einem starken Sinn gelesen werden: im Sinn einer mehr oder weniger großen Beeinflussung, aber auch im Sinn einer notwendigen (kausalen), womöglich nicht hintergehbaren Bedingung.

Sprache kann das Denken auf verschiedene Weise beeinflussen: auf der semiotischen Ebene (wie wirkt sich die Existenz von Sprache überhaupt auf Denkvorgänge aus?), auf der strukturellen Ebene (wie wirkt sich eine bestimmte Sprache im Vergleich zu einer anderen aus, z.B. Hopi versus Englisch?) und auf der funktionellen Ebene (welche Auswirkungen hat eine bestimmte Form einer Einzelsprache, z.B. ein Fachwortschatz?). Entsprechend läßt sich dieser Einfluß auf verschiedenen Stufen empirisch erforschen ( siehe Tab. 4 ). Solche Studien haben ebenso wie theoretische Überlegungen ( siehe Zusatzinfo 9 ) gezeigt, daß die starke deterministische und relativistische Interpretation des sprachlichen Relativitätsprinzips unplausibel ist, daß die Einzelsprache jedoch in vielen Fällen durchaus das Denken und Weltbild beeinflußt. Dabei muß man nicht behaupten, daß Sprecher verschiedener Sprachen nicht fähig seien, bestimmte Unterscheidungen zu machen (bzw. diese nicht erlernen könnten). Es geht vielmehr darum, ob Unterscheidungen auch wirklich (und häufig und systematisch) gemacht werden und welchen Anteil daran die jeweilige Sprache hat. Tatsächlich ist bei komplizierteren Wortfeldern, die etwa psychische Zustände und abstrakte soziale Systeme wie Recht oder Religion betreffen, eher anzunehmen, daß bestimmte Unterscheidungen sprachabhängig sind und deshalb typischerweise getroffen werden, etwa im Deutschen die zwischen "klug, weise, intelligent, schlau und vernünftig", als daß sie unabhängig von der Einzelsprache gemacht, aber in manchen Kulturen nicht ausgedrückt werden (können). Es ist also gar nicht so relevant, ob eine bestimmte Sprache etwas grammatisch ausdrücken kann oder nicht, sondern ob sie es mit relativ wenig Aufwand auszudrücken vermag oder nicht bzw. sogar, ob sie es ausdrücken muß oder nicht. Wesentlich ist daher nicht eine mutmaßliche Unüberbrückbarkeit der Konzepte, sondern die Tatsache, daß diese Konzepte in manchen Sprachgemeinschaften automatisch, ohne Anstrengungen, unbewußt, konventionell, ohne Ausnahme und fast jederzeit (im Sprechen, Hören und sogar Träumen) verwendet werden und auch grammatisch fixiert sind, in anderen Sprachgemeinschaften jedoch nicht. Solche Unterschiede können einen Einfluß auf Alltag und Kommunikation haben. In einer Sprache, deren grammatisches Ausdrucksvermögen in einer bestimmten Hinsicht weniger reichhaltig oder eindeutig ist als in einer anderen, müssen die Informationslücken deshalb, wo nötig, auf andere Weise geschlossen werden. Hinzu kommt die unterschiedliche Lastenverteilung von Sprecher und Hörer: Je detailierter der Sprecher das sagt, was er mitteilen will, und um so höher also sein Aufwand ist, desto leichter fällt es dem Hörer, ihn zu verstehen. Und je weniger die Grammatik einer Sprache zu bestimmten Differenzierungen zwingt, desto mehr muß der Hörer leisten, damit Mißverständnisse oder Informationsdefizite vermieden werden können.

Das letzte Wort soll der Dichter haben, denn die Sprache ist sein Medium, und nicht selten auch sein Thema: "das verhaeltnis von woertern zu dingen? / neinnein; das gibts nicht. / zu klaeren waeren / das verhaeltnis von woertern zu gewissen hirnzellen / und / das verhaeltnis von dingen zu gewissen hirnzellen / und dann vielleicht / das verhaeltnis der einen gewissen zu den anderen gewissen hirnzellen." (tomas schmit).

Lit.: Aitchison, J.: Words in the Mind. Oxford 1994. Aitchison, J.: The Seeds of Speech. Cambridge 1996. Bickerton, D.: Language and Human Behavior. Seattle, London 1995. Blanken, G. u.a. (Hrsg.): Linguistic Disorders and Pathologies. Berlin, New York 1993. Calvin, W.H., Bickerton, D.: Lingua ex Machina. Cambridge 2000. Carruthers, P., Boucher, J. (Hrsg.): Language and thought. Cambridge 1998. Cavalli-Sforza, L.L.: Gene, Völker und Sprachen. München, Wien 1999. Chomsky, N.: Language and Mind. New York 1972. Deacon, T.: The Symbolic Species. New York 1997. Dunbar, R.I.M.: Klatsch und Tratsch. München 1998 (1996). Fletcher, P., MacWhinney, B. (Hrsg.): Handbook of Child Language. Oxford 1994. Friederici, A.: Neuropsychologie der Sprache. Stuttgart 1984. Fromkin, V., Rodman, R.: An Introduction to Language. New York 1997. Garman, M.: Psycholinguistics. Cambridge 1990. Garner, M.: Artificial languages. London 1987. Gipper, H. (Hrsg.): Kinder unterwegs zur Sprache. Düsseldorf 1985. Grewendorf, G., Hamm, F., Sternefeld, W. (Hrsg.): Sprachliches Wissen. Frankfurt 1988. Hauser, M.D.: The Evolution of Communication. Cambridge 1996. Jablonski, N.G., Aiello, L.C. (Hrsg.): The Origin and Diversification of Language. San Francisco 1998. Keller, R.: Sprachwandel. Tübingen 1994. Lenneberg, E.H.: Biologische Grundlagen der Sprache. Frankfurt 1972 (1967). Leuninger, H.: Neurolinguistik. Opladen 1989. Levelt, W.J.M.: Speaking. Cambridge 1989. Lieberman, P.: The Biology and Evolution of Language. Cambridge 1984. Lyons, J.: Die Sprache. München 1987 (1981). Nettle, D., Romaine, S.: Vanishing Voices. Oxford 2000. Noble, W., Davidson, I. (Hrsg.): Human Evolution, Language, and Mind. Cambridge 1996. Pinker, S.: Der Sprachinstinkt. München 1996 (1994). Poeck, K.: Sprache im Gehirn: eng lokalisierbar? Spektrum der Wissenschaft 5 (1995), S. 92-98. Sascha, F., Kanngiesser, S., Reckheit, G. (Hrsg.): Kognitive Linguistik. Opladen 1989. Savage-Rumbaugh, S., Shanker, S., Taylor, T.: Apes, Language and the Human Mind. Oxford 1998. Sprachen. Spektrum der Wissenschaft Dossier 1 (2000). Studdert-Kennedy, M., Hurford, J.R., Knight, C.: The Evolutionary Emergence of Language. Cambridge 2000. Vaas, R.: Die sprechenden Affen von Atlanta. bild der wissenschaft 8 (2000), 36-41. Vaas, R.: Evolving language, I-consciousness and free will. In: Dessalles, J.-L., Ghadakpour, L. (Hrsg.): Evolution of Language. Paris 2000, S. 230-235. Vaas, R.: Sprache, Denken, Wirklichkeit. In: Stoll, G., Vaas, R.: Spurensuche im Indianerland. Stuttgart, Leipzig 2001, Kap. 6.

Sprache

Abb. 1: Hauptkomponenten der Sprachen bzw. Sprachwissenschaft

Sprache

1 Laute und Zellverbände:

Gesprochene Sprache liegt im Schallfrequenzbereich von 100 bis etwa 3000 Hz, die zeitliche Auflösung beträgt circa 0,02 s. Weltweit gibt es rund hundert verschiedene bedeutungsunterscheidende Sprachlaute (Phoneme); die meisten Sprachen haben zwischen 20 und 40. Im Deutschen gibt es 8 Vokale und 21 Konsonanten. Sie werden sehr schnell zu Silben und Wörtern kombiniert (rund 25 Elemente pro Sekunde). Etwa 0,2 bis 0,25 Silben werden beim normalen Sprechen pro Sekunde erzeugt.

Vermutlich gibt es im auditorischen Cortex spezielle Neuronengruppen, die Phoneme anhand von bestimmten Unterscheidungsmerkmalen identifizieren. Die Aktivierung eines Zellverbands oder eines bestimmten nachgeschalteten Neurons könnte den diskreten Charakter der Phonemerkennung hervorrufen. Auch die Produktion von Phonemen basiert wohl auf einzelnen Zellverbänden, die bei der Bildung von Silben nacheinander zu Neuronengruppen-Ketten verschaltet werden könnten (synfire chain).

Sprache

Tab. 1: Sprachverwendung und nichtaphasische Störungen der Kommunikationsfähigkeit

| ||

| Quantität: Der Gesprächsbeitrag enthält Informationen, die für das Verständnis der Mitteilung notwendig sind | eingeschränkte Kohärenz: Patient neigt zu Weitschweifigkeit, Redundanz, Gedankensprüngen, Konfabulation | |

| Qualität: Der Gesprächsbeitrag ist glaubhaft | eingeschränkte Integration kontextabhängiger Informationen: Probleme beim Verständnis von Ironie, Metaphern, Mehrdeutigkeiten | |

| Relation: Der Gesprächsbeitrag ist der Situation angemessen | eingeschränkte Relevanz: unmotivierte Themenwechsel, unspezifische referentielle Kennzeichnungen | |

| Modalität: Der Gesprächsbeitrag ist klar und eindeutig formuliert | eingeschränkte Kohäsion: Schwierigkeiten bei der Satzverknüpfung durch Konjunktionen und Adverbien (hierarchische und sequentielle Strukturebene) sowie bei der Bezugnahme einzelner Informationen | |

| Intonation: Der Gesprächsbeitrag ist im richtigen Tonfall formuliert und moduliert | affektive Dysprosodie: modulationsarme, emotionslose Sprechweise (löst leicht Mißverständnisse aus) |

Sprache

2 Sprachlateralisierung bei Schimpansen:

Schimpansen besitzen ebenfalls asymmetrische Großhirnhälften. Die als Planum temporale bezeichnete Hirnwindung im Schläfenlappen ist in der linken Hemisphäre wesentlich größer und weiter entwickelt als in der rechten. Das ist auch bei den meisten Menschen der Fall, wo das Planum temporale zur Wernicke-Region gehört. Da eine unabhängige evolutionäre Parallelentwicklung unwahrscheinlich ist, war die cerebrale Asymmetrie vermutlich schon bei den gemeinsamen Vorfahren von Menschen und Schimpansen vor rund acht Millionen Jahren ausgeprägt. Ob sie schon damals eine Sprachfunktion besaß, ist ungewiß.

Sprache

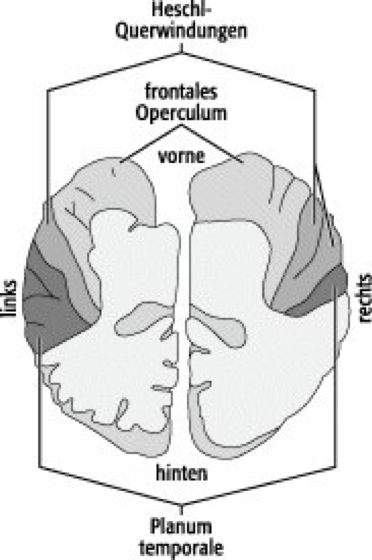

Abb. 2: Sprachregionen der Großhirnrinde, die eine neuroanatomische Asymmetrie aufweisen

Neuroanatomisch sind drei Strukturen der Großhirnrinde asymmetrisch angelegt, die alle mit der Sprachfähigkeit zu tun haben: das Planum temporale (mit der Wernicke-Region), die Heschl-Querwindungen (primärer auditorischer Cortex) und das frontale Operculum (Broca-Region). Allerdings ist das linke Planum temporale nur bei 65% der Menschen größer als das rechte (im Gegensatz zur sprachlichen Linksdominanz bei über 95%), der Bereich der Heschl-Querwindungen ist sogar überwiegend rechts größer. Das frontale Operculum ist von außen betrachtet meist rechts größer, doch wenn der Cortex in den Sulci mit einbezogen wird, ist es links größer.

Sprache

Abb. 3: Die primären Sprachareale der linken Großhirnrinde. Die Zahlen bezeichnen die Brodmann-Areale.

Sprache

3 Repräsentation verschiedener Sprachen im Gehirn:

Theoretisch gibt es drei Möglichkeiten, wo zwei verschiedene Sprachen im Gehirn verarbeitet werden: In derselben Region (E extended system hypothesis), in zwei getrennten Regionen (E dual system hypothesis) oder überlappend bzw. getrennt in einer beide Teilbereiche einschließenden Region (E subset hypothesis). Daß verschiedene Sprachen, die eine Person beherrscht, nicht notwendigerweise in denselben Gehirnbereichen repräsentiert werden, haben spezifische Aphasien gezeigt, die den Ausfall einer oder mehrerer Sprachen zur Folge haben (nicht unbedingt der Muttersprache!), aber eine andere weniger beeinträchtigen. Epilepsien und elektrische Stimulationen der Großhirnrinde können zu ähnlichen Effekten führen. Daß die Repräsentation zweier Sprachen im Cortex vom Zeitpunkt ihres Erwerbs abhängt, zeigten Messungen mit der funktionellen Kernspinresonanztomographie: Bei Menschen, die zweisprachig aufgewachsen sind, also zwei Sprachen in ihrer Kindheit erworben haben (nicht unbedingt gleichzeitig), werden dieselben Orte im motorischen Broca-Areal aktiv, unabhängig davon, welche Sprache sie gerade sprechen. Bei Menschen, die die zweite Sprache erst später gelernt haben, z.B. in der Schule, ist deren Repräsentation im Broca-Areal von derjenigen der Muttersprache räumlich getrennt. Die Aktivitätszentren liegen um so weiter auseinander (4,5-9 mm), je mehr Zeit zwischen dem Erwerb der beiden Sprachen verstrichen ist. Bei den Aktivitäten im sensorischen Wernicke-Areal zeigten sich jedoch keine Unterschiede. Hier überlappt die Repräsentation der Sprachen fast vollständig, unabhängig vom Zeitpunkt ihres Erwerbs.

Sprache

4 Aktivität beim Lesen:

Die Schreibweisen in unterschiedlichen Sprachen haben einen Einfluß auf das Lesen und die damit korrelierten neuronalen Aktivitätsmuster. Wie Sprache schriftlich symbolisiert wird, wirkt sich auf die Schnelligkeit des Lesens aus und geht mit unterschiedlichen Gehirnaktivitäten einher. Menschen mit Englisch als Muttersprache z.B. brauchen mehr Zeit, bis sie ein Wort gelesen haben, als Italiener. Im Italienischen stehen einzelne Buchstaben oder Buchstabenkombinationen nämlich fast immer für dieselben Laute, während im Englischen z.B. "cough", "bough", "dough" und "tough" ganz unterschiedlich ausgesprochen werden. PET-Messungen zeigten, daß dabei zwar dieselben Hirnregionen aktiv sind, aber ihre Gewichtung verschieden ist. Bei englischen Muttersprachlern sind der linke vordere und der hintere innere Schläfenlappen besonders aktiv, während bei Sprechern des Italienischen der linke untere Schläfenlappen stärker durchblutet wird. Alle diese drei Hirnregionen sind notwendig für die Lesefähigkeit. Die Messungen eröffnen die Chance, besser zu verstehen, wie Lese-Rechtschreib-Schwächen zustande kommen und wie die Kultur die Organisation des Gehirns beeinflußt.

Sprache

Abb. 4: Lokalisation bestimmter Teilbereiche der Sprachfähigkeit.

Sprache

Tab. 2: Wichtige neuronale Grundlagen der Sprachfähigkeit

| ||

| phonologische Analyse | Bereich um die Sylvius-Furche: Wernicke-Region, Insula, Gyrus supramarginalis | |

| Kategorisierung in Wörter, aussprechbare Nichtwörter und andere Reize (z.B. einfache Töne, Vokale, Buchstaben); der Unterschied muß erlernt werden | Aktivierung der primären und sekundären visuellen bzw. auditorischen Hirnrinde; nur beim Lesen bzw. Hören bekannter Wörter oder aussprechbarer Nichtwörter zusätzliche Aktivierung einer Region im linken Hinterhauptslappen bzw. in der Wernicke-Region; bei der Lektüre von Wörtern, die sich reimen (z.B. E "row" und "though", nicht aber "lint" und "pint" [gesprochen "paint"]) werden auch auditive Areale aktiv | |

| Kategorisierung und phonematische Etikettierung, primär mittels Substantiven | Schaltkreise im Schläfenlappen, mit Grundverschaltung der Objekterkennung verknüpft | |

| Verarbeitung von visuellen und auditiven sprachlichen Inputs | sensorische Areale und präfrontaler Cortex; visuelle Informationen können phonologisch analysiert werden, müssen aber nicht | |

| Syntax (betrifft primär den Gebrauch der Verben als phonematische Etiketten von Bewegungen) | Verarbeitung von Syntax und Verben im Frontallappen (insbesondere im ventralen präfrontalen Cortex und im prämotorischen Areal), zum Teil auch im vorderen Gyrus cinguli; möglicherweise findet im Frontallappen eine Kategorisierung ähnlich wie die Kategorisierung sensorischer Informationen im Schläfenlappen statt. | |

| Wortanalyse | präfrontaler Cortex, vorderer Gyrus cinguli (vermittelt wahrscheinlich die Aufmerksamkeit), rechte Kleinhirn-Hemisphäre | |

| kategoriespezifisches Wissen, lexikalisch-semantische Verarbeitung | Schläfenlappen (z.B. Personennamen im Temporalpol, Tiernamen im unteren vorderen Schläfenlappen, Werkzeugbezeichnungen im hinteren Schläfenlappen und in der Übergangsregion des Schläfen-, Scheitel- und Hinterhauptslappens), lateraler und medialer Frontallappen (Verben), Gyrus angularis, dorsolateraler präfrontaler Cortex | |

| automatische Sprachverarbeitung (z.B. bei stereotypen Antworten) | Insula | |

| nichtautomatische Sprachverarbeitung (z.B. neue Antworten nach kognitiver Verarbeitung) | Frontallappen und hinterer Schläfenlappen der linken Hemisphäre, vorderer Gyrus cinguli, rechtes Kleinhirn | |

| Kurzzeitgedächtnis für gehörte oder gelesene Wörter während einer Unterhaltung oder der Lektüre | Frontallappen (insbesondere für Verben) und hinterer Schläfenlappen (insbesondere für Substantive) | |

| Repräsentation gelernter Wörter | hinterer Schläfenlappen (wird von sinnlosen Konsonantenfolgen nicht aktiviert) | |

| Wortassoziation, z.B. "Hammer" als Antwort auf "Nagel" | Frontallappen (insbesondere links innen) einschließlich des Broca-Areals; hinterer Schläfenlappen, vorderer Gyrus cinguli, Kleinhirn | |

| Bildung von Silben und Übergängen zwischen diesen | prämotorische Regionen und hinterer Scheitellappen (vielleicht analog zur Kontrolle der Extremitätenbewegung) | |

| Wiederholung vorgegebener Worte | bilaterale Aktivierung des motorischen und sensorischen Gesichtsareals, des supplementären Sprachareals, der Insula und des rechten Kleinhirns (dort motorische Steuerung), nicht aber des Wernicke- und Broca-Areals | |

| Artikulation/Sprachproduktion | supplementär-motorisches Areal (Initiation) und Broca-Areal mit den umliegenden vorderen Regionen, nachgeschaltete motorische Rindenfelder und Teile der Insula (fortlaufende Kontrolle) | |

| Verständnis und Produktion kommunikativer und emotionaler Betonungen (Prosodie) | rechte Hemisphäre (insbesondere unterer motorischer Cortex und Operculum) | |

| Pragmatik (Kohärenz von Erzählungen, Angemessenheit der Wortwahl abhängig von der Situation, Verständnis von Witzen), Kommunikationskonventionen | rechte Hemisphäre (insbesondere präfrontale und dorsolateral-frontale Areale) |

Sprache

Abb. 5: Auswirkung von Läsionen in verschiedenen Bereichen des Schläfenlappens auf die Sprachfähigkeit

1 auditorischer Cortex: zentrale Taubheit; 2 Wernicke-Region: phonetische Störungen des Sprachverständnisses; 3 semantische Störungen des Sprachverständnisses; 4 Störungen bei der Benennung und Namen-Wiederholung; 5 Paralyse der Sprechmuskulatur; 6 Broca-Region: Störung der Artikulation und Grammatik; 7 Probleme bei der Initiierung des Sprechens.

Sprache

5 Lokalisation von Sprachstörungen:

Obwohl es viele Befunde zur Korrelation von Sprachfunktionen und Hirnregionen gibt ( siehe Tab. 2 ), ist die Lokalisation sprachlicher Fähigkeiten nicht so eindeutig und strikt, wie in den früheren Modellvorstellungen vermutet (Wernicke-Geschwind-Modell und modernere Nachfolger). Zum einen können die Ausfallssymptome trotz ähnlicher Läsionsorte stark variieren, zum anderen gehen Aphasien in den ersten sechs Monaten nach der Läsion trotz weiterbestehender Gewebedefekte teilweise stark zurück. Auch methodische Probleme spielen eine Rolle: Eine stabile Hirnläsion läßt sich mittels Computertomographie erst etwa einen Monat nach der Schädigung erkennen, wenn die zellulären Abräumvorgänge größtenteils beendet sind. Und PET-Studien müssen aufgrund der relativ schlechten zeitlichen Auflösung über viele Versuche mitteln und nichtsprachliche Hirnaktivitäten (Sehen, Hören, Aufmerksamkeit, Gedächtnis usw.) subtrahieren. Außerdem gehen manche Funktionsstörungen nicht mit anatomisch sichtbaren Defekten einher. So scheinen die aphasischen Syndrome häufig weniger die neuroanatomische Organisation der Sprache im Gehirn widerzuspiegeln als die Gefäßversorgung der Sprachregionen. Meistens sind nämlich Durchblutungsstörungen im Versorgungsgebiet der mittleren Hirnarterie Ursache für eine Aphasie: Ein Infarkt im gesamten Gebiet dieser von der inneren Halsschlagader abzweigenden Arterie läßt sich einer globalen Aphasie zuordnen, ein Schlaganfall im Versorgungsgebiet einer Verzweigung (Arteria praerolandica) führt zur Broca-Aphasie, und ein Infarkt in der hinteren Abzweigung (Arteria temporalis posterior) hat die Wernicke-Aphasie zur Folge. Die Sprache scheint im Gehirn also nicht eng lokalisiert zu sein, sondern auf einer relativ großräumigen Netzwerk-Organisation mit wechselnden, dynamischen Verschaltungen zu beruhen.

Sprache

6 Sprachexperimente mit Menschenaffen:

Cathy und Keith Hayes versuchten in den 1950er Jahren am Yerkes Laboratory of Primate Biology, Atlanta, der Schimpansin Vicky Wörter beizubringen. Sie lernte aber nur "Mama, Papa, cup, up" zu sagen. Menschenaffen haben nicht den anatomischen Apparat, um menschliche Sprache zu erzeugen.

Beatrix und Allen Gardner begannen 1966 an der University of Nevada, Menschenaffen Gesten einer Gebärdensprache beizubringen, der american sign language (Abk. ASL). Mit Roger Fouts gelang es ihnen, der Schimpansin Washoe über 1000 Zeichen zu lehren, davon gebrauchte sie 200 unter verschärften Testbedingungen und schuf auch Innovationen wie "Wasser-Vogel" für einen Schwan. Die Schimpansin Lucy bezeichnete einen Rettich mit "Schreien-Wehtun-Nahrung". Washoe setzte die Zeichen auch Artgenossen gegenüber ein. So signalisierte sie einem Affen, als sie diesen von einer Schlange bedroht sah, "komm-Umarmung" und zog ihm schließlich mit der Hand von der Gefahr weg, als er nicht verstand. Fragen stellte Washoe kaum mit Hilfe von Pronomen, sondern durch ein Hochziehen der Augenbrauen und durch lange Gebärden, ähnlich wie es Taubstumme tun. Washoe machte auch Zeichen zu sich selbst, wenn niemand anwesend war, wie versteckte Kameras dokumentierten. So kommentierte sie "schlecht, schlecht, schlecht", als ein jugendlicher Schimpanse namens Loulis ihr ein Magazin wegnahm. Dieser lernte ASL nur durch Beobachtung anderer. Wenn es wichtig war, wurde auch die Syntax berücksichtigt. So machte es einen Unterschied, ob die Schimpansin "Washoe kitzeln Roger" oder "Roger kitzeln Washoe" signalisierte.

David Premack von der University of Pennsylvania versuchte, der Schimpansin Sarah beizubringen, zahlreiche bunte, verschieden geformte Plastikplättchen wie Wörter und kurze Sätze zu verwenden. Sie lernte zwar, Anweisungen wie "Sarah nehmen Banane wenn-dann Mary [die Pflegerin] nicht geben Schokolade Sarah" erfolgreich auszuführen, doch blieb umstritten, inwiefern das nicht bloß Dressur war. Denn Menschen lernten in ähnlichen Versuchen das richtige Verhalten, verstanden aber oft nichts.

Duane Rumbaugh und Sue Savage-Rumbaugh begannen in den 1970er Jahren an der University of Georgia in Atlanta mit Schimpansen und Bonobos mit Hilfe von Symbolen auf einer Computer-Tastatur (Lexigramme) zu kommunizieren. Die Affen lernten mehrere hundert Zeichen und zeigten sprachliche Fähigkeiten wie ein 2,5-jähriges Kind.

Nicht nur mit Schimpansen und Bonobos wurden Sprachexperimente gemacht. Francine Patterson von der Gorilla Foundation in Woodside (Calif.) lehrte dem Gorilla-Weibchen Koko über 500 Zeichen in der Gebärdensprache ASL. Koko prägte auch neue Bedeutungen wie "Flasche-Streichholz" für Feuerzeug und "Auge" für Maske. Lyn Miles brachte an der University of Tennessee dem Orang Utan-Männchen Chatek über 150 ASL-Zeichen bei. Seit einigen Jahren wird auch versucht, mit Delphinen via visueller Symbole zu kommunizieren.

Sprache

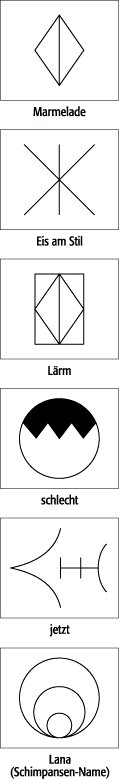

Abb. 6: Lexigramme zur Kommunikation mit Menschenaffen

Sprache

Tab. 3: Einige spekulative Hypothesen zum Sprachursprung, die jedoch alle nicht vollständig überzeugend sind

| ||

| Pfui-Pfui-Theorie (Interjektionstheorie) | Instinktive und emotionale Schreie von Schmerz, Lust, Ekel, z.B. "Ohhh!, Iiih!, Ah!" usw. | |

| Babbel-Theorie | Kleinkindliches Babbeln hat sich zu komplexen Sprachen ausdifferenziert | |

| Gesang-Theorie | Melodien, z.B. mütterliche Wiegenlieder | |

| La-la-Theorie (Spiel-Theorie) | Wörter aus spielerischen Lautäußerungen, z.B. dem Singsang von Kindern oder dem zärtlichen Stammeln Verliebter | |

| Hauruck-Theorie (synergistische Theorie) | Zurufe und rhythmische Unterstreichungen des Taktes bei der gemeinsamen Arbeit | |

| Wau-Wau-Theorie | Nachahmung von Tierlauten, Geräuschen usw. (Onomatopoeie, Lautmalung), z.B. "Wauwau, Kickerickie, Uhu, Kuckuck" | |

| Mundgebärden-Theorie | Hinweise mit Lippen; aus den unterschiedlichen Mundstellungen bildeten sich die Vokale, z.B. für nah/fern ("hier/da", "this/that", "voici/voilà") | |

| Grooming-Theorie | Sprache als verbales "Lausen" zur sozialen Bindung als Ersatz der Fellpflege bei vielen Primaten (z.B. um die Hände frei zu haben und weil die Gruppen zu groß wurden) | |

| Gestik-Theorie | Signale mit den Händen, Mimik und Körpersprache wurden zu einer Lautsprache umcodiert | |

| Schöpfer-Theorie | Gott blies den Menschen die Sprache ein und hat sie später verwirrt (Turmbau zu Babel) |

Sprache

7 Anatomie und Evolution des menschlichen Vokaltrakts:

Nicht nur corticale Neuerungen waren für die Evolution der Sprachfähigkeit notwendig, sondern auch solche des Vokaltrakts. Bei Menschen liegt der Frequenzbereich der von den Schwingungen der Stimmlippen (Lautquelle) erzeugten Laute zwischen 500 Hz (Kleinkind) und 100 Hz (erwachsener Mann). Doch nicht nur die von der Lautquelle erzeugte Tonhöhe prägen die Lautsprache, sondern auch die erzeugten Formanten. Diese akustischen Vokalanteile prägen die Klangfarbe (Timbre), prägen maßgeblich die individuelle Stimmqualität und entstehen durch Resonanzen und Breitband-Filterwirkung in Kehlkopf, Mund- und Nasenhöhle. (Bei vielen Affen gehören auch bis zu 6 l Luft fassende Luftsäcke zum Vokaltrakt, deren genauer Zweck allerdings noch unbekannt ist.) – Bei den meisten Säugetieren, vom Delphin bis zum Menschenaffen, sitzt der Kehlkopf sehr hoch im Hals, praktisch gegenüber den ersten drei Halswirbeln. Dadurch ragt er bis in den Hohlraum nahe der hinteren Nasenhöhlenöffnungen (Choanen) zum Rachenraum (Pharynx). Der oberste Knorpel des Kehlkopfs (Kehldeckel, Epiglottis) liegt über dem Gaumensegel. So läßt der Kehlkopf den Luftweg zwischen Nase und Lunge frei. Zugleich vermag Nahrung in Form von Flüssigkeit oder Speisebrei an beiden Seiten des Kehlkopfs vorbei in Speiseröhre und Magen zu fließen, ohne den Luftweg zu kreuzen. Deshalb können Säugetiere gleichzeitig atmen und trinken, ohne sich zu verschlucken. Allerdings ist die Skala der produzierbaren Laute dadurch drastisch eingeschränkt. Es bleibt lediglich eine schmale supralaryngale Zone, mit der die von den Stimmlippen aus dem Luftstrom erzeugten Laute nur geringfügig verändert werden können. Auch die Modulation mit Mundraum und Lippen reicht nicht aus, um das große Repertoire einer menschlichen Sprache (über hundert verschiedene Laute) zu erzeugen, insbesondere die Vokale. Der Atemtrakt des menschlichen Säuglings gleicht dem der übrigen Säugetiere. Der Kehlkopf liegt ebenfalls im Bereich der ersten drei Halswirbel, und die Kleinkinder schlucken, atmen und geben auf dieselbe Weise Geräusche von sich, wie etwa Affen dies tun. Mit der Röntgenkinematographie läßt sich das deutlich verfolgen. Im Verlauf des Wachstums verschiebt sich die Lage des Kehlkopfs dann ab dem dritten Lebensmonat halsabwärts und innerhalb von etwa vier Jahren bis zur Höhe des vierten bis siebten Halswirbels (ein weiterer, geringerer Abstieg erfolgt beim "Stimmbruch" der Jungen in der Pubertät). Der Kehldeckel reicht dann nicht mehr ans Gaumensegel, womit sich Speise- und Luftweg oberhalb des Kehlkopfs kreuzen. Beim Schlucken senkt sich der Kehldeckel reflexhaft über die Luftröhre, so daß im Normalfall keine Nahrung in die Atemwege gelangen kann (Schluckreflex). Nun steht, und das ist der Vorteil dieser Entwicklung, der für das Sprechen unumgängliche Resonanzraum bereit: der vergrößerte Rachenraum oberhalb der Stimmlippen. Nur durch ihn sind die feinsten lautlichen Nuancierungen möglich. Evolutionsbiologisch interessant ist, daß hier die individualgeschichtliche Entwicklung gleichsam die stammesgeschichtliche der Menschwerdung rekapituliert. Läßt sich die Frage, ab wann der Mensch sprechen konnte, vielleicht durch die Paläolaryngologie beantworten, d.h. die Untersuchung der Evolution des Vokaltrakts? Hier kann die Neigung der Schädelbasislinie Auskunft geben, mit der die Lage des Kehlkopfs zusammenhängt: Ist die Schädelbasis flach, liegt der Kehlkopf oben im Hals, ist sie gewölbt, liegt er weiter unten. Schädelvermessungen zeigten, daß bei den Australopithecinen, die vor 4-1,5 Millionen Jahren in den Savannen Ost- und Südafrikas lebten, die Schädelbasis nicht gewölbt ist und derjenigen der heutigen Menschenaffen ähnelt. Sie verfügten demnach nur über ein begrenztes Lautrepertoire. Bei 300000 bis 400000 Jahren alten Schädeln des Homo erectus hingegen scheint der anatomische Abstieg des Kehlkopfs schon begonnen zu haben. Beim Neandertaler, der sich vor 100000 bis etwa 35000 Jahren von Westeuropa bis nach Israel und Zentralasien ausgebreitet hatte, ähnelten die Verhältnisse denen des modernen Homo sapiens. Das gilt auch für das nur wenige Zentimeter große Zungenbein (Hyoid), das zwischen Zungenbasis und Kehlkopf liegt und nicht mit anderen Knochen verwachsen ist. Sehnen und insgesamt elf Muskeln verbinden es mit Unterkiefer, Zunge und Kehlkopf. Für das Sprachvermögen ist es wichtig, denn die Muskeln, die hier ansetzen, verändern die Lage des Kehlkopfs und folglich auch das Volumen des Stimmrohrs. Ein gefundenes Neandertaler-Zungenbein von der Kebara-Höhle auf dem Berg Karmel in Israel unterscheidet sich in seinen Abmessungen und Muskelansatzstellen nicht von dem der Jetztmenschen. Doch daraus läßt sich nicht die Kehlkopfstellung der Neandertaler ablesen. Andere Tiere, z.B. Schweine, haben ein sehr ähnliches Zungenbein, ohne sprechen zu können, während Papageien menschliche Laute verblüffend genau mit einem ganz anderen Vokaltrakt nachahmen können. Auch die Größe des Canalis hypoglossalis bei heutigen und früheren Menschen wurde herangezogen, um deren Sprachfähigkeit abzuschätzen. Durch diesen Kanal verläßt der Hypoglossus den Schädel. Die Variationsbreite der Kanalöffnung läßt aber bislang keine verläßlichen Rückschlüsse auf den Durchmesser des Hypoglossus zu, über den die Zungenmuskulatur gesteuert wird, obwohl man sich erhofft hat, diesen Durchmesser als indirektes Maß für die Kontrolle der Sprechmotorik zu verwenden. Wie gut die Neandertaler sprechen konnten, bleibt also vorläufig eine offene Frage. Möglicherweise wurde sein Aussterben durch eine Verdrängung des modernen Homo sapiens verursacht, weil dessen besseres Denk- und Sprachvermögen ein Grund seiner reproduktiven Überlegenheit war. Die Lage des Kehlkopfes ist dabei wohl zweitrangig, zumal Vokale bei aller Wichtigkeit für die Unterscheidung und Geschwindigkeit von Lautfolgen im Vergleich zu Konsonanten von geringerem Informationswert sind. Werden z.B. alle Konsonanten eines Satzes durch m ersetzt ("Mommmem mie meammemmamem mmmemmem?"), wird er wesentlich schwerer verstanden als beim Ersetzen aller Vokale z.B. durch a ("Kanntan daa naandartalar sprachan?"). Doch das phylogenetische Herabsteigen des Kehlkopfs, das ja die Gefahr des Erstickungstods nach sich zieht, muß einen Selektionsvorteil besessen haben. Dafür scheint nur die verbesserte Lautbildung in Frage zu kommen. Das bedeutet aber, daß eine gewisse sprachliche Fähigkeit schon vorhanden gewesen sein mußte, die sich durch die Larynxvergrößerung weiterentwickelte. Das Sprachvermögen wäre damit also nicht ausschließliche Folge des tieferliegenden Kehlkopfs, sondern auch Ursache in dem sich wechselseitig bedingenden Evolutionsprozeß. Allerdings dürften auch hier andere Faktoren wirksam gewesen sein. So korreliert nämlich ein längerer Vokaltrakt (und damit tiefer Kehlkopf) mit einem größeren Körper. Und wenn, wie es auch bei anderen Primaten sowie Hunden, Löwen, Hirschen, vielen Vögeln und Alligatoren der Fall ist, z.B. die Körpergröße für die Partnerwahl eine Rolle spielte (sexuelle Selektion), dann war nicht ein verbessertes Sprechvermögen, sondern ein akustischer Größenindikator der entscheidende Selektionsfaktor für die evolutionäre Tieferlegung des Kehlkopfes: je größer das Individuum einer Art, desto tiefer steht sein Kehlkopf. Die tiefe Lage des Kehlkopfes ist also per se noch kein Ausdruck menschlicher Sonderstellung. Und mit der Röntgenszintigraphie konnte sogar gezeigt werden, daß es auch eine vorübergehende dynamische Kehlkopfabsenkung gibt (z.B. bei bellenden Hunden und meckernden Ziegen), so daß eine permanente Tiefenlage gar nicht unbedingt erforderlich ist. Diese Befunde zeigen aber auch, wie die vergleichende Anatomie zu einem besseren Verständnis der Randbedingungen für die Evolution von Sprechen und Sprache beitragen kann. Evolution der Nervensysteme und Gehirne.

Sprache

8 Hypothesen zu den Selektionsvorteilen der Sprachfähigkeit:

Heute wird Sprache zu vielen Zwecken verwendet: Informationen übermitteln, Anweisungen geben, Fragen stellen, Gefühle ausdrücken, sozialer Austausch sowie Sprachspiel und Poesie usw. Doch was waren die ursprünglichen Funktionen? Hierzu gibt es zahlreiche Vorschläge, z.B.:

- Kommunikation zwischen Mutter und Kind

- Kommunikation in Situationen ohne Sichtkontakt (Dunkelheit, Wald usw.)

- Kommunikation über Gegenstände und Sachverhalte in der Umgebung

- Kommunikation von Vorstellungen über momentan nicht wahrnehmbare Dinge (inkl. Zeitvergegenwärtigung, Bedürfnisantizipation, Planung, Vorsorge, z.B. Brennholzsammeln fürs Feuer)

- verbesserte Koordination von Jagd, Kriegszügen und anderen Gruppenaktivitäten

- besserer Umgang mit der Welt durch Kategorisierung und feinere Begriffsbildung

- Sprache als Mittel der Informationsspeicherung und Traditions-Bildung

- forcierte Intelligenzentwicklung durch erweiterte und flexiblere Symbolmanipulation und Problemlösefähigkeiten

- Sprache als Mittel der Zuschreibung mentaler Zustände anderer und sich selbst gegenüber (Reflexion)

- Sprache als Mittel des sozialen Zusammenhalts, der Werbung um Bündnis- und Geschlechtspartner usw.

- Sprache als Isolationsmechanismus und Genpoolkennzeichen in der Konkurrenz mit anderen Gruppen

Sprache

Tab. 4: Einfluß der Sprache auf Kognition und Verhalten: empirische Überprüfung von Whorf-Effekten

| ||