Lexikon der Neurowissenschaft: Kybernetik

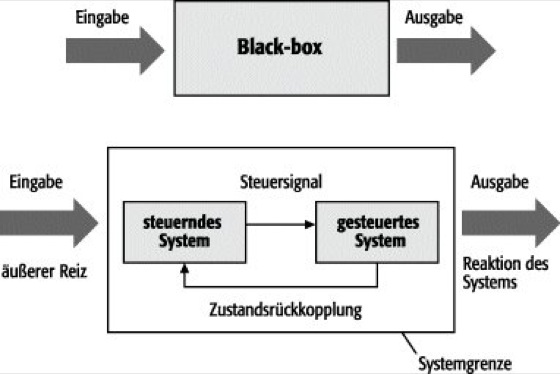

Kybernetik w [von griech. kybernetike = Steuermannskunst], E cybernetics, allgemein die Wissenschaft der Steuerung, Regelung und Nachrichtenübertragung. Der Begriff Kybernetik geht auf Norbert Wiener zurück und ist mit der Tagung 1943/44 in Princeton (USA) verbunden, auf der auch das Maß für die Information, das Bit begründet wurde. In ihr wird das Verhalten von technischen und biologischen Systemen (Biokybernetik) mit Methoden der Regelungstheorie (Regelung), der Systemtheorie, der Informationstheorie, der Algorithmentheorie (Algorithmus) und der Automatentheorie (Automat) beschrieben und erforscht (analysiert, modelliert und prognostiziert). Der Informationsbegriff (Information) und die Informationsverarbeitung stehen im Vordergrund, unabhängig von der physikalischen Realisierung, sei sie mechanisch, elektrisch, optisch oder anders. So sind auch Regelungsmechanismen im menschlichen Körper kybernetische Systeme. Die Kybernetik behandelt jedes beliebige System nach der Frage aller möglichen Ein- und Ausgaben und nicht nur nach der Maxime "was passiert bei dieser bestimmten Eingabe". Damit wird die wichtige Rolle der Informationstheorie offensichtlich, da sich diese eigentlich mit Mengen von Möglichkeiten beschäftigt. – Die Kybernetik läßt sich in mehrere Teilgebiete untergliedern. Die allgemeine Kybernetik beschäftigt sich mit grundlegenden Strukturen und Funktionen von Regelungssystemen, sie benutzt dazu Analogie- und Modellverfahren (Black-box-Verfahren, s.u.). Die angewandte Kybernetik umfaßt diejenigen Teilbereiche anderer Disziplinen, z.B. der Ökonomie, Technik, Biologie, Psychologie, Medizin u.a., die sich kybernetischer Methoden zur Erklärung und Modellierung bedienen. Beispiele für einfache technische kybernetische Systeme sind etwa die Drehzahlregelung einer Dampfmaschine mittels eines Fliehkraftreglers oder die Temperaturregelung über einen Raumthermostat. Auf diese Weise können unterschiedlichste Vorgänge auf eine einheitliche formale Ebene abgebildet werden. Information wird von kybernetischen Systemen aufgenommen, dies führt zu einer Zustandsänderung im System und diese führt wiederum zu einer Aktion ( siehe Abb. 1 ). Kybernetische Systeme werden unterschiedlich eingeordnet, je nachdem, ob die Anzahl ihrer inneren Freiheitsgrade vollständig oder nicht vollständig durch die Eingangswerte bestimmt ist, und ob das System Gedächtnis besitzt oder nicht. Systeme, deren innere Freiheitsgrade nicht vollständig durch die Eingangswerte bestimmt sind, werden stochastisch genannt, die anderen deterministisch. Systeme mit Gedächtnis werden als dynamisch bezeichnet. Kybernetische Systeme reagieren je nach ihrer Konstruktion auf unterschiedliche Weise auf Eingangsinformation, adaptieren sich an die Umgebung oder versuchen, vorgegebene Ziele zu erreichen. Ein in kybernetischen Systemen häufig auftretendes Prinzip ist das der Selbstregulierung. Diese Selbstregulierung wird durch eine Rückkopplung innerhalb des Systems erzielt. Gewisse innere Parameter werden dazu benutzt, das zeitliche Verhalten des Systems zu stabilisieren. Zwei verschiedene Ansätze zur Modellierung oder Analyse von Systemen können unterschieden werden ( siehe Abb. 1 ): 1) Eine makroskopische Betrachtung, bei der das System als ein schwarzer Kasten (Black-box) gesehen wird, der über seine Ein- und Ausgänge charakterisiert ist. Bedeutung hat dabei die Analyse des Informationsflusses, die Repräsentation der Information (Code) und die Bestimmung einer Abbildung vom Eingang zur Ausgabe (z.B. Reiz zu Reaktion). Ein Ansatz bei der Modellierung konkreter Systeme ist dabei die Annahme einer minimalen Komplexität des Modells ("Occam´s razor"). Ein anderer Gesichtspunkt ist das Ersetzen nicht berechenbarer Teile eines größeren Gesamtsystems durch möglichst einfache Teilmodelle, die deren meßbare Eigenschaften wiedergeben. 2) Eine mikroskopische Betrachtungsweise, die hierbei die Bildung eines kybernetischen Modells aus einem steuernden und einem gesteuerten Teilsystem erlaubt (Steuerungs- und Regelungstechnik). Einerseits können wie unter 1) die Einzelsysteme analysiert und modelliert werden, andererseits ist eine Analyse der Interaktion der Teilsysteme möglich, z.B. mit Hilfe der Regelungstheorie oder der Graphentheorie. – Inhaltlich konkretere Beschreibungen der Kybernetik und ihrer Ziele sind heute anhand des inzwischen gut entwickelten Begriffssystems besser möglich. Dieses umfaßt u.a. die Begriffe System, Information, Steuerung und Regelung.

Information, Code und Codierung: Basierend auf den Arbeiten von Claude Shannon (1948) werden durch die Informationstheorie kürzeste Beschreibungen der Information aus einer Informationsquelle möglich, und es können Grenzen der Übertragbarkeit von Information über einen Kanal angegeben werden (s.u.). Die Informationstheorie benutzt zur Formulierung ihrer Ergebnisse die Wahrscheinlichkeitstheorie und erfaßt damit naturgemäß einen beschränkten Teil aller möglichen Deutungen von Information. Eine Informationsquelle generiert eine Nachricht aus einer Menge von möglichen Nachrichten. Das Problem der Speicherung oder Übertragung von Nachrichten beschränkt sich nun auf die Länge der Repräsentation der Nachricht und ist getrennt von deren Bedeutung. Falls es nur eine Nachricht gibt, wird durch das Senden dieser Nachricht keine Information übertragen. Die Menge an Information, die übertragen wird, ist damit in Bezug zu deren Unsicherheit gesetzt. Wenn das Auftreten eines Ereignisses sehr wahrscheinlich ist, ist nicht viel Information bei dessen Auftreten gewonnen. Der einfachste Fall ist bei zwei gleich wahrscheinlichen Nachrichten gegeben. Diese Nachrichten können durch die Symbole 0 und 1 repräsentiert werden, die Menge an übertragener Information ist bei einer dieser Nachrichten 1 Bit. Bei vier gleich wahrscheinlichen Nachrichten können die Nachrichten durch jeweils 2 Bit repräsentiert werden (00, 01, 10, 11). Für gleich wahrscheinliche Nachrichten steigt die Anzahl der benötigten Bits logarithmisch (zur Basis 2) mit der Anzahl der möglichen Nachrichten. Für nicht gleich wahrscheinliche Nachrichten verwendet man das gewichtete Mittel (Erwartungswert), um die Anzahl der benötigten Bits zu berechnen. Die Nachrichtenquelle wird dabei als Zufallsvariable X mit den Werten xi und den zugehörigen Wahrscheinlichkeiten P(X = xi) modelliert. Diesen Wert nennt man Entropie, und er bezeichnet die mittlere Unsicherheit der Zufallsvariable X:

![]()

Der Informationsgehalt des Ereignisses (oder der Nachricht) X = xi ist hierbei

![]()

.

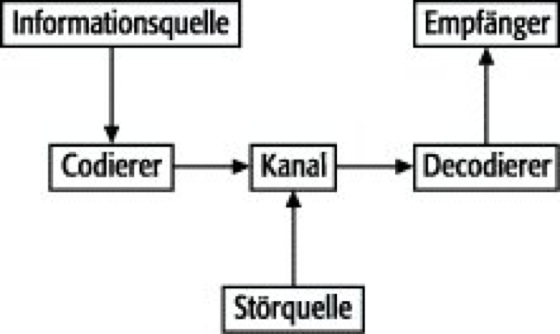

Es kann gezeigt werden, daß die Entropie einer Zufallsvariable eine untere Schranke für die mittlere Länge jeder eindeutig decodierbaren Repräsentation der Zufallsvariable darstellt. Eine gleich verteilte Zufallsvariable, welche 2k verschiedene Werte annehmen kann, hat eine Entropie von k Bit. Entsprechend dem oben beschriebenen Repräsentationsverfahren kann jeder dieser Werte durch eine 0/1 Sequenz der Länge k dargestellt werden. Ganz allgemein könnte diese Repräsentation z.B. eine Folge von "Strom an" für 1 und "Strom aus" für 0 bedeuten, jedoch wären auch ganz andere Darstellungsformen möglich, z.B. eine Abfolge von Basenpaaren auf der DNA oder Licht an/aus usw. Ist die angesprochene Zufallsvariable nicht gleich verteilt, so ist es möglich, eine geringere mittlere Beschreibungslänge durch Zuweisung kürzerer Repräsentationen an häufig auftretende Werte und längerer an selten auftretende Werte zu erhalten, wie es z.B. im Morsealphabet geschieht. Falls beispielsweise die Zufallsvariable X die Werte A, B, C, und D mit den Wahrscheinlichkeiten 0,5, 0,25, 0,125 und 0,125 annimmt, dann könnte der Code 0 für A, 10 für B, 110 für C und 111 für D diese vier Werte repräsentieren. Die mittlere Codelänge wäre dann 1,75 Bit. Dies ist kürzer als die 2 Bit, die für eine Repräsentation im gleich wahrscheinlichen Fall nötig wären. In diesem Fall ist die mittlere Codewortlänge gleich der Entropie der Zufallsvariablen. Generell ist jedoch die Entropie eine untere Schranke für die mittlere Länge eines eindeutig decodierbaren Codes, und es existiert eine Codierung mit einer mittleren Codewortlänge, die kleiner ist als die Entropie der Zufallsvariablen plus 1 Bit. Zur Informationsübertragung siehe Abb. 2 .

Nachrichtenverarbeitung und Systemverhalten: Nachrichtenverarbeitung in kybernetischen Systemen beschreibt jeden Vorgang, durch den eine empfangene Nachricht verändert oder mit anderen Nachrichten kombiniert wird, um dann erst in dieser neuen Form das Systemverhalten zu beeinflussen. Zwei Teilbereiche sind demnach zu unterscheiden, einerseits die Verknüpfung und Verarbeitung der Information und andererseits die Verhaltensbeeinflussung durch die verknüpften Nachrichten. Dies kann das Auslösen eines speziellen Verhaltens oder einer Tätigkeit sein, z.B. eine Instinkthandlung oder das Einschalten des Lichts oder einer Maschine. Ebenso werden beim Steuern und Regeln Nachrichten verarbeitet und das Systemverhalten geändert. Beim Steuern handelt es sich um eine zielgerichtete Beeinflussung eines Verhaltens ( siehe Abb. 1 , unterer Teil, Übergang vom steuernden zum gesteuerten System), z.B. können durch ein Relais oder einen Transistor große Energieflüsse durch kleine beeinflußt werden. Beim Steuern erfolgt im Gegensatz zum Regeln keine Veränderung des Steuerungsverfahrens durch das Systemverhalten, es existiert kein Rückkopplungspfad. Folgende Arten der Steuerung sind zu unterscheiden: a) Die Führungs-Folge-Steuerung, bei der beim Fehlen von Störgrößen zwischen der Führungs- (wird dem Steuergerät von außen zugeführt) und Aufgabengröße zumindest im Beharrungszustand (stationäres Verhalten) ein gewünschter Zusammenhang hergestellt wird, und b) die Programmsteuerung, die sich weiter in Zeitplansteuerung (z.B. Ampelsteuerung), Wegplansteuerung (z.B. Erzeugen der Führungsgröße durch Abtasten eines Modells beim Kopierfräsen) und Ablaufsteuerung (z.B. Aufzugsteuerung) untergliedern läßt. Im Gegensatz zum Steuern erfolgt beim Regeln eine Rückwirkung des Systemverhaltens auf die Art der Systembeeinflussung. Es wird eine Regelgröße erfaßt, beispielsweise die Drehzahl; eine Differenz zwischen Ist- und Soll-Drehzahl (Führungsgröße) führt zu einem Signal, welches durch die Steuerung dann zu einer Drehzahlveränderung in Richtung auf die Sollgröße führt. Diese Art der negativen Rückkopplung wird zur Stabilisierung des Systemverhaltens verwendet. Zwei Arten von Regelungen können unterschieden werden: a) die Festwertregelung; bei ihr bleibt der Wert der Führungsgröße (Sollwert) während des Regelvorgangs fest eingestellt, der Wert der Regelgröße (Istwert) soll auch beim Vorhandensein von Störungen möglichst nahe beim Sollwert gehalten werden (z.B. Temperatur-, Spannungs- oder Drehzahlregelung), und b) die Folgeregelung: der Wert der Regelgröße folgt auch bei vorhandenen Störungen dem sich ändernden Sollwert zu jedem Zeitpunkt möglichst exakt nach (z.B. Nachführen einer Satellitenbodenantenne). – Bei Steuerung und Regelung wird dem System ein Ziel von außen vorgegeben, während dem Vorgang des Anpassens ein Systemverhalten zugrunde liegt, welches einen Ausgleich mit der Umwelt anstrebt. Eine wichtige Form dieser Anpassung ist das Lernen, sie setzt voraus, daß das System Gedächtnis besitzt. Einige Beispiele aus der Vielzahl der Lernprozesse sind u.a. das Erlernen eines bedingten Reflexes, Lernen durch "Versuch und Irrtum", assoziatives Lernen (sowohl in biologischen Systemen als auch im Assoziativspeicher) sowie überwachtes und unüberwachtes Lernen in künstlichen neuronalen Netzen. Lernen als Anpassung innerer Parameter in künstlichen Systemen wird meist als Optimierungsverfahren (mit heuristischen Anteilen) auf Computern realisiert (Optimierung). Von Bedeutung ist bei maschinellen Lernverfahren oftmals eine starke Wechselwirkung mit der Repräsentation des zu lernenden Wissens (Wissensrepräsentation und -verarbeitung im Bereich der künstlichen Intelligenz). Bei den künstlichen Lernverfahren ist das innere Modell der Umwelt, deren Parameter angepaßt werden, nicht notwendigerweise fest vorgegeben, sondern die interne Repräsentation von Wissen paßt sich während des Lernens (oder der Trainingsphase) der Umwelt an.

H.K.

Lit.: Wiener, N.: Kybernetik: Regelung und Nachrichtenübertragung im Lebewesen und in der Maschine. Düsseldorf 1992. Cover, T.M. und Thomas, J.A.: Elements of Information Theory. New York 1991. Schmidt, G.: Grundlagen der Regelungstechnik. Berlin 1987. Flechtner, H.-J.: Grundbegriffe der Kybernetik. München 1984. Shannon, C.E., Weaver, W.: The Mathematical Theory of Communication. Chicago 1963. Ashby, W.R.: An Introduction to Cybernetics. London 1957.

Kybernetik

Abb. 1:

Der obere Teil der Abbildung zeigt den makroskopischen Ansatz zur Modellierung oder Analyse von Systemen, bei der das System als Black-box gesehen wird, der über seine Ein- und Ausgänge charakterisiert ist.

Der untere Teil verdeutlicht eine mikroskopische Betrachtungsweise, die die Bildung eines kybernetischen Modells aus einem steuernden und einem gesteuerten Teilsystem erlaubt.

Kybernetik

Abb. 2: Informationsübertragung

Ein Information übertragendes System besteht aus einer Informationsquelle, einer Codiereinrichtung, einem Kanal über den die codierten Nachrichten übertragen werden, einem Decodierer und schließlich dem Empfänger der Nachrichten. Es handelt sich dabei um einen Spezialfall eines allgemeinen Kommunikationssystems, in dem nicht "irgendwelche" Mitteilungen oder Signale übertragen werden, sondern Information als eine quantitativ bestimmbare Größe; ebenso fließt in diese Modellierung keine Bedeutung der Nachrichten ein. Das System Kanal könnte noch weiter in einen Kanalcodierer, Kanal mit möglichen Störungen und einen Kanaldecodierer untergliedert werden. Typischerweise wird vom Codierer die eingehende Information komprimiert, d.h. ein Code gefunden, welcher mit möglichst kleiner mittlerer Codewortlänge die Information repräsentiert. Der Kanalcodierer hat dann wiederum die Aufgabe, gezielt Redundanz hinzuzufügen, so daß die Codewörter auch nach Übertragung im gestörten Kanal noch identifiziert werden können. Als eigentlichen Kanal kann man sich z.B. eine Telephonleitung, eine Funkstrecke oder das Axon eines Neurons vorstellen, an denen entlang Impulse weitergeleitet werden. Ist H(X) die Entropie der Informationsquelle oder der Informationsgehalt, der in den Kanal gegeben wird, so sei der Informationsgehalt am Kanalausgang H(Y). Bei einem störungsfreien Kanal gilt H(X)=H(Y). Bei einem Kanal mit Störungen, d.h. in allen praktischen Fällen, gilt H(X

![]()

H(Y). Als Maß für die über den gestörten Kanal verlorengegangene Information wird von Shannon die bedingte Entropie der Nachricht (gegeben das Signal am Kanalausgang) folgendermaßen definiert:

![]()

Die Rate der tatsächlichen Information über den Kanal ist nun:

![]()

R wird auch Transinformation genannt. Die Kanalkapazität ist dann der Maximalwert von R:

![]()

.

Ist die Entropie der Quelle H(X) kleiner als die Kapazität C des Kanals, so läßt sich die Eingangsinformation am Ausgang des Kanals mit vernachlässigbarem Fehler wiederherstellen.

Schreiben Sie uns!