Lexikon der Mathematik: Faktorenanalyse

Die Faktorenanalyse ist eine Methode zur Analyse von Beziehungen von untereinander abhängigen zufälligen Merkmalen.

Dabei versucht man, diese Merkmale auf gemeinsame wenige Ursachenkomplexe, die sogenannten Faktoren zurückzuführen. Die Methode wurde von Hotelling (1933), Lawley (1940) und Thurstone (1947) im Rahmen der mathematischen Statistik begründet und findet insbesondere in der Psychologie und Soziologie breite Anwendung.

Mathematisch formuliert ist die Faktorenanalyse eine Methode zur Untersuchung der Kovarianzmatrix eines reellen zufälligen Vektors \(\overrightarrow{X}=(X_{1},\ldots,X_{m})\) dessen Komponenten Xi, i = 1, …, m die zufälligen Merkmale beschreiben. Hierbei legt man das folgende Modell zugrunde:

<?PageNum _121Xi – sind die vorher standardisierten zufälligen Merkmale, d. h., es gilt EXi = 0 und V(Xi) = 1,i = 1, …, m; (diese Standardisierung erreicht man immer durch die lineare Transformation \({X}_{i}:=\frac{{X}_{i}-E{X}_{i}}{\sqrt{V({X}_{i})}}\))

Fj – sind die sogenannten zufälligen Faktoren mit EFj = 0 und V(Fj) = 1, j = 1, …, s;

aij – sind reelle Koeffizienten, die den Einfluß des Faktors Fj auf das Merkmal Xi wiedergeben und als Ladungen bzw. Faktorladungen bezeichnet werden, i = 1, …, m; j = 1, …, s;

ϵi – sind untereinander und mit Fj, j = 1, …, s, unkorrelierte Zufallsgrößen mit Eϵi = 0 und \(V({\varepsilon }_{i})={\sigma }_{i}^{2}\), i = 1, …, m; diese werden häufig als die durch die s Faktoren nicht erklärbaren Reste bezeichnet.

Für die Kovarianzmatrix \({\Sigma }_{\overrightarrow{X}}=Cov (\overrightarrow{X})\) des Merkmalsvektors \(\overrightarrow{X}\) ergibt sich unter diesen Modell-Annahmen:

wobei

die Matrix der Faktorladungen,

die Kovarianzmatrix von \(\overrightarrow{\varepsilon }\), und

die Kovarianzmatrix des Vektors der zufälligen Faktoren \(\overrightarrow{F}=({F}_{1},\ldots,{F}_{s})\) sind.

Die Gleichung (1) wird als Hauptgleichung der Faktorenanalyse bezeichnet. Häufig fordert man (aus Gründen der Vereinfachung des Problems), daß die Faktoren unkorreliert sind, daß also \({C}_{\overrightarrow{F}}\) gleich der Einheitsmatrix ist; die Hauptgleichung der Faktorenanalyse lautet dann:

Dies bedeutet, daß die Kovarianzen \({\sigma }_{{X}_{i}{X}_{j}}\) von Xi und Xj und die Varianzen von Xi sich wie folgt beschreiben lassen:

und

Man bezeichnet

als Kommunalität von Xi bzgl. der s Faktoren. \({h}_{i}^{2}\) ist der durch die Faktoren erklärte Anteil an der Varianz von Xi. Die Aufgabenstellung der Faktorenanalyse besteht nun darin, eine derartige Zerlegung der Kovarianzmatrix \({\Sigma }_{\overrightarrow{X}}\) zu finden. Da die Matrix \({\Sigma }_{\overrightarrow{X}}\) unbekannt ist wird sie durch die empirische Kovarianzmatrix

der standardisierten Merkmale Xi ersetzt, die auf der Basis einer konkreten Stichprobe \({\overrightarrow{x}}_{k}=({x}_{1k},\ldots,{x}_{mk})\), k = 1, …, n von \(\overrightarrow{X}\) vom Umfang n berechnet werden. (Im allgemeinen sind die Merkmale Xi nicht von vorneherein standardisiert. In diesem Fall werden die Beobachtungen xik von Xi zunächst gemäß der Transformation

standardisiert, wobei \({\bar{x}}_{i}\) und si der empirische Mittelwert und die empirische Streuung der Beobachtungen von Xi sind.)

Die Aufgabe der Faktorenanalyse lautet damit: Finde die Zahl s der Faktoren, A und \({\sigma }_{i}^{2}\) so, daß gilt

bzw. finde s und A so, daß gilt:

Gemäß (4) ergibt sich dann als Schätzung für \({\sigma }_{i}^{2}\) :

Die Aufgabe ist so, wie sie gestellt ist, nicht eindeutig lösbar, auch dann nicht, wenn die Zahl s der Faktoren gegeben ist. Es gibt zur Lösung der Aufgabe verschiedene Verfahren, die unterschiedliche Nebenbedingungen fordern, um die Lösung eindeutig zu machen.

Die am häufigsten verwendeten Methoden der Faktorenanalyse sind die Maximum-Likelihood-Methode, die Hauptkomponentenmethode und die Zentroidmethode.

Bei dem durch Lawley und Maxwell [1] in die Faktorenanalyse eingeführten Maximum-Likelihood-Schätzprinzip <?PageNum _122wird vorausgesetzt, daß sowohl der zufällige Merkmalsvektor \(\overrightarrow{X}\) als auch der Vektor der Reste \(\overrightarrow{\varepsilon }\) einer m-dimensionalen Standardnormalverteilung genügen und voneinander unabhängig sind. Die Anzahl s der Faktoren wird fest vorgegeben. Aufgrund der Kenntnis der Verteilung der Kovarianzmatrix \({S}_{\overrightarrow{X}}\) (Wishart-Verteilung) erhält man für eine mathematische Stichprobe \({\overrightarrow{X}}_{k}=({X}_{1k},\ldots,{X}_{mk})\), k =1, …, n vom Umfang n die folgende Likelihoodfunktion:

Dabei sind K eine (nur von m und n abhängige) Konstante, Sp der Spuroperator (Summe der Hauptdiagonalelemente), und |·| bezeichnet die Determinante. Man erhält durch Maximierung der Likelihoodfunktion (Ableitung nach aij) und Berücksichtigung der Beziehung (4) folgende Schätzgleichungen:

Um die Eindeutigkeit der Schätzungen aij und \({\sigma }_{i}^{2}\) zu sichern, fordern Lawley und Maxwell, daß die Matrix \({A}^{T}{D}_{\overrightarrow{\varepsilon }}^{-1}A\) diagonal ist. Die Schätzwerte für aij erhält man dann mit geeigneten numerischen Verfahren zur Lösung des nichtlinearen Gleichungssystems (7), (8).

Zur Bestimmung der Anzahl s der Faktoren wird dieses Verfahren in der Regel mehrmals für s = 2, 3,… angewendet. Der Vektor der Faktorladungen \({\overrightarrow{a}}_{j}=({a}_{1j},\ldots,{a}_{mj})\) zu einem neu hinzukommenden Faktor Fj soll dabei wenigstens in zwei Elementen stark von 0 verschieden sein, d. h. der Faktor Fj soll wenigstens zwei Merkmale beeinflussen, andernfalls bricht das Verfahren ab. Ansonsten bricht das Verfahren mit dem kleinsten s ab, ab dem sich die Kommunalitäten nicht mehr wesentlich voneinander unterscheiden, d. h. man wählt die kleinste Anzahl s von Faktoren, durch die die Varianz der Merkmale erklärt werden kann und die wenigstens zwei Merkmale beeinflussen. Unter der obigen Voraussetzung der Normalverteilungen ist auch ein χ2-Test zum Testen der Anzahl s entwickelt worden (siehe auch [1]).

Bei der Hauptkomponentenmethode wird schrittweise ein orthogonales Koordinatensystem von Faktoren konstruiert. Dabei wird in jedem Schritt versucht, die verbliebene Reststreuung maximal auszuschöpfen, d. h. zu verringern. Numerisch führt dieses auf die schrittweise Lösung eines Eigenwertproblems.

Bei der Zentroidmethode handelt es sich eben-falls um ein iteratives, geometrisch motiviertes Extraktionsverfahren der Faktoren auf der Basis der Kovarianzmatrix der Merkmale, dessen Ergebnisse (Ladungen) nicht eindeutig sind. Dabei wird versucht, durch schrittweise Konstruktion eines orthogonalen Koordinatensystems der Faktoren die Kommunalitäten zu maximieren.

Bei der Anwendung der Faktorenanalyse in der Praxis erweist sich häufig die Vorgabe der Anzahl s der Faktoren als auch deren Interpretation als kompliziert. Deshalb wird oft wie oben beschrieben durch schrittweise Erhöhung der Faktorenzahl – dem entspricht eine Änderung des Modells – versucht, interpretierbare Lösungen zu erhalten.

Beispiel. Es ist zu untersuchen, ob sich die Leistung (erreichte Punktzahl Xi, i = 1, …, 5) in den 5 Fächern Mechanik (Me), Analytische Geometrie (AG), Lineare Algebra (LA), Analysis (An) und elementare Statistik (St) auf wenige gemein-same Faktoren zurückführen läßt. Von n = 88 Studenten wurden die jeweils erreichten Punktzahlen bei den 5 Klausuren Me, AG, LA, An und St erfaßt. Auf die Angabe der Datenmatrix xil, i = 1, …, 5, l = 1, …, 88 sei hier verzichtet. Bei der Durchführung der Faktorenanalyse werden zunächst für jedes Merkmal Xi, i = 1, …, 5 aus den beobachteten Daten xil, l = 1, …, 88 der empirische Mittelwert \({\overrightarrow{x}}_{i}\) und die empirische Streuung \({s}_{i}^{2}\) des Merkmals berechnet. Anschließend werden alle Beobachtungen gemäß

standardisiert und mit den standardisierten Daten die empirische Kovarianzmatrix \({S}_{\overrightarrow{X}}\) berechnet:

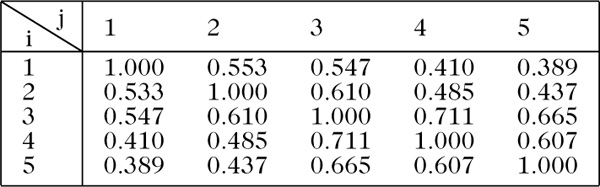

In unserem Beispiel erhalten wir als Ergebnis für \({S}_{\overrightarrow{X}}\) die Matrix:

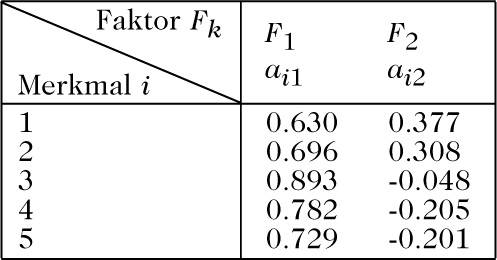

Werden s = 2 Faktoren angesetzt, so ergibt sich als geschätzte Ladungsmatrix nach der Maximum-Likelihood-Methode die in folgender Tabelle angegebene Matrix:

<?PageNum _123

Aus dieser Matrix ergeben sich für die Kummunalitäten der 5 Merkmale:

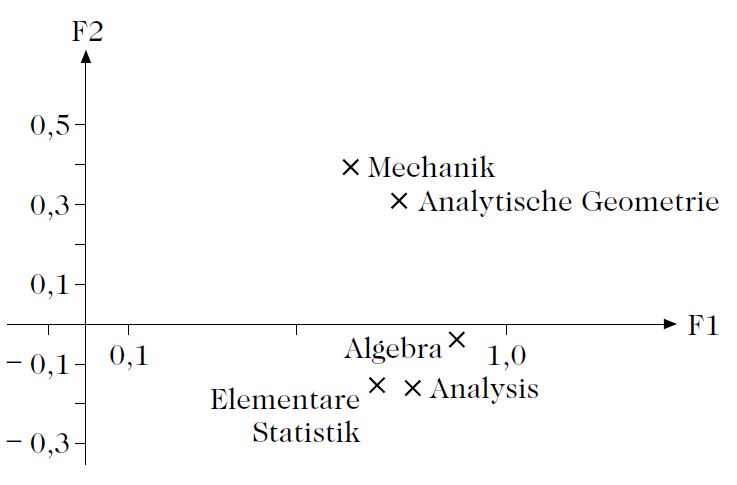

Wir stellen die 5 Merkmale im orthogonalen Koordinatensystem der beiden Faktoren dar; das erste Merkmal (Me) wird dort zum Beispiel durch den Punkt mit den Koordinaten (a11, a12) dargestellt, siehe Abbildung.

Darstellung der 5 Merkmale (Klausurpunkte in 5 Fächern) im Koordinatensystem von 2 Faktoren.

Der Ladungsmatrix A in obiger Tabelle sieht man an, daß sich die Ladungen auf die erste Spalte, d. h. den ersten Faktor, konzentrieren. Dies ist ein Hinweis darauf, daß als Ursache für die erreichten Leistungen in den 5 Fächern schon ein Faktor ausreichend wäre. Führt man die Maximum-Likelihoodschätzung mit s = 1 durch, so ergibt sich für den Ladungsvektor

Die Kommunalitäten für diesen Fall \(({h}_{i}^{2}={a}_{i1}^{2})\) unterscheiden sich (in der Summe) nicht wesentlich vom Fall s = 2. In einem anschließenden χ2-Test wäre die Vermutung H0 : s = 1 zu überprüfen.

Literatur

[1] Hartung, J., Elpelt, B.: Multivariate Statistik. R. Oldenbourg Verlag, München Wien 1989.

[2] Jahn, W., Vahle, H.: Die Faktorenanalyse. Verlag Die Wirtschaft, Berlin 1970.

[3] Lawley, D.N., Maxwell, A.E.: Factor Analysis as a Statistical Method. Butterworths, London 1971.

[4] Überla, K.: Faktorenanalyse. Springer-Verlag, Berlin 1968.

Wenn Sie inhaltliche Anmerkungen zu diesem Artikel haben, können Sie die Redaktion per E-Mail informieren. Wir lesen Ihre Zuschrift, bitten jedoch um Verständnis, dass wir nicht jede beantworten können.