Lexikon der Mathematik: Korrelationsanalyse

Verfahren der mathematischen Statistik zur Untersuchung der Korrelationen, d. h. der stochastischen Abhängigkeiten von zufälligen Merkmalen anhand von Stichproben bzw. Punktschätzungen der entsprechenden Korrelationskoeffizienten.

1. Korrelationsanalyse mittels des einfachen Korrelationskoeffizienten. Es sei (X, Y) ein zweidimensionaler zufälliger Vektor und (X1, Y1), …, (Xn, Yn) eine mathematische Stichprobe von (X, Y). Der einfache Korrelationskoeffizient wird dabei durch den empirischen Korrelationskoeffizienten \(\hat{\varrho }\), auch als Pearsonscher oder Stichprobenkorrelationskoeffizient bezeichnet, geschätzt. Unter der Annahme, daß (X, Y) eine zweidimensionale Normalverteilung besitzt und X und Y unkorreliert sind, besitzt die Größe

eine t−Verteilung mit n − 2 Freiheitsgraden. Damit läßt sich ein Korrelationstest zum Prüfen der Hypothesen

konstruieren; die Hypothese Ho wird akzeptiert, wenn |T| < tn−2(1 − α) ist, andernfalls abgelehnt. Dabei ist tn−2(1 − α) das (1 − α)-Quantil der t-Verteilung mit (n − 2) Freiheitsgraden. α ist der vorgegebene Fehler erster Art dieses Signifikanztests.

Zur Konstruktion eines (asymptotischen) Tests zum Prüfen der Hypothese Ho : ϱ = ϱo(0 < | ϱo | < 1), zur Konstruktion eines (asymptotischen) Konfidenzintervalls, sowie zur Konstruktion von Tests zum Prüfen der Gleichheit zweier einfacher Korrelationskoeffizienten wird die sogenannte Fishersche Z-Transformierte (Z-Transformation) herangezogen.

In der deskriptiven Statistik ist es häufig üblich, ohne jedes Testverfahren folgende Klassifikation vorzunehmen:

- Wenn \(|\hat{\varrho }|\lt 0.2\) dann X, Y unkorreliert.

- Wenn \(0.2\le |\hat{\varrho }|\lt 0.5\) dann X, Y schwach korreliert.

- Wenn \(0.5\le |\hat{\varrho }|\lt 0.8\) dann X, Y korreliert.

- Wenn \(0.8\le |\hat{\varrho }|\) dann X, Y stark korreliert.

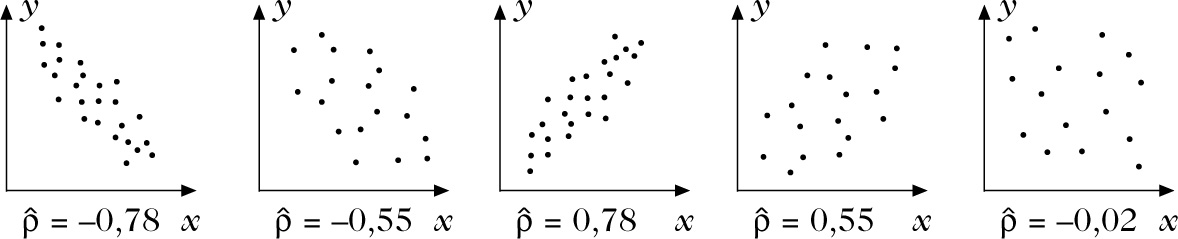

Man spricht von positiver Korrelation, wenn \(\hat{\varrho }\gt 0\), und von negativer Korrelation, wenn \(\hat{\varrho }\lt 0\). Da die einfache Korrelation den Grad der linearen Abhängigkeit zwischen den Zufallsgrößen widerspiegelt, gibt es einen typischen Zusammenhang zwischen der Gestalt der Stichprobenwerte als Punktwolke im kartesischen Koordinatensystem und dem Korrelationskoeffizienten \(\hat{\varrho }\), siehe Abbildung.

Ist wenigstens eines der beiden zufälligen Merkmale X und Y ordinal skaliert, so verwendet man zur Schätzung von ϱ einen Rangkorrelationskoef-fizienten, z. B. den Spearmanschen Korrelationskoeffizienten oder auch ein Assoziationsmaß wie Kendalls τ-Koefizient, und verwendet die parameterfreien Methoden der Rangkorrelationsanalyse zur Untersuchung des Zusammenhangs zwischen X und Y.

Korrelationsanalyse: Graphische Darstellung von Stichproben vom Umfang n = 20 bei verschiedenen stochastischen Abhängigkeiten.

2. Korrelationsanalyse mittels der partiellen Korrelationskoeffizienten. Es sei \(\overrightarrow{X}=({X}_{1},\ldots,{X}_{m})\) ein zufälliger Vektor mit dem Erwartungswert \(E\overrightarrow{X}=\overrightarrow{\mu }\) und der Kovarianzmatrix Bx = B. Weiterhin bezeichne (X(1), X(2)) eine Zerlegung von X mit

sowie

Sei \(\overrightarrow{X}=({X}_{i1},\ldots,{X}_{im})\), i =1, …, n eine zugehörige mathematische Stichprobe von \(\overrightarrow{X}\) vom Umfang n. Die Matrix

mit den Elementen

wobei

für i = 1, …, m, heißt Stichprobenkovarianzmatrix, die \(\hat{{b}_{ij}}\) Stichprobenkovarianzen und \(\hat{{b}_{ii}}\) die Stichprobenstreuungen. Für eine konkrete Stichprobe \({\overrightarrow{x}}_{i}=({x}_{i1},\ldots,{x}_{im})\), i =1, …, n, spricht man von der empirischen Kovarianzmatrix \(\hat{B}\), sowie den empirischen Kovarianzen und Varianzen \({\hat{b}}_{ij}\) und \({\hat{b}}_{ii}\).

Die Elemente \({\hat{\sigma }}_{ij.p+1,\ldots,m}\), i, j = 1, …, p der Matrix \(\hat{{B}_{11}}-{\hat{B}}_{12}{\hat{B}}_{22}^{-1}{\hat{B}}_{21}\) sind die ‚partiellen Stichprobenkovarianzen‘, und

(i, j = 1, …, p) im Falle ϱij·p+1,…, m = 0 t-verteilt mit (n − (m − p) − 2) Freiheitsgraden. Tij kann folglich als Testgröße zum Prüfen der Hypothese

verwendet werden.

Zum Prüfen der Hypothese

ist eine Teststatistik auf der Basis der Fisher-schen Z-Transformation entwickelt worden. Für weitere sogenannte verteilungsfreie Methoden der Korreationsanalyse vergleiche man Rangkorrelationsanalyse.

3. Korrelationsanalyse mittels der multiplen Korrelationskoeffizienten. Ist in 2. p = 1, d. h., X(1) = (X1) und X(2) = (X2, …, Xm), so ist

Der Wert \({\hat{\varrho }}_{1(\mathrm{2\cdots}m)}\) heißt multipler Stichprobenkorrelationskoeffizient bzw., wenn er auf der Basis einer konkreten Stichprobe berechnet wird, empirischer multipler Korrelationskoeffizient. Falls \(\overrightarrow{X}\) normalverteilt ist, stellt \({\hat{\varrho }}_{1(\mathrm{2\cdots}m)}\) die Maximum-Likelihood-Schätzung von ϱ1(2···m) dar, und

ist F-verteilt mit (n − 1, n − m) Freiheitsgraden. T kann folglich zum Prüfen der Hypothese

herangezogen werden.

Für weitere sogenannte verteilungsfreie Methoden der Korreationsanalyse vergleiche man Rang-korrelationsanalyse.

Wenn Sie inhaltliche Anmerkungen zu diesem Artikel haben, können Sie die Redaktion per E-Mail informieren. Wir lesen Ihre Zuschrift, bitten jedoch um Verständnis, dass wir nicht jede beantworten können.