Lexikon der Mathematik: Perceptron-Lernregel

eine spezielle Lernregel für Neuronale Netze, die bereits gegen Ende der fünfziger Jahre von Frank Rosenblatt vorgeschlagen wurde und gewisse Defizite der Hebb-Lernregel kompensieren sollte; die Perceptron-Lernregel kann, etwas vereinfacht gesagt, als Delta-Lernregel für nicht differenzierbare Transferfunktionen angesehen werden.

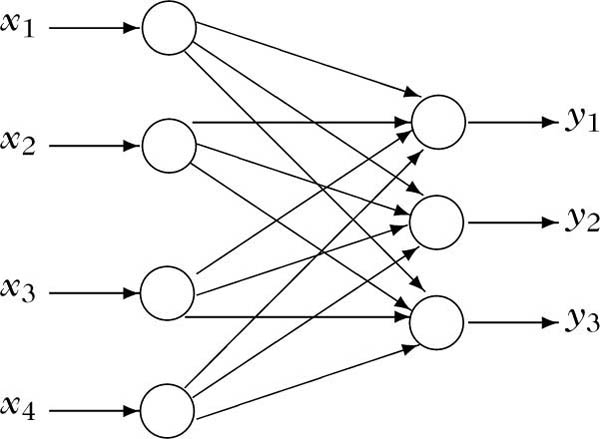

Im folgenden wird die prinzipielle Idee der Perceptron-Lernregel kurz im Kontext diskreter zweischichtiger neuronaler Feed-Forward-Netze mit Ridge-Typ-Aktivierung und nicht differenzierbarer sigmoidaler Transferfunktion in den Ausgabe-Neuronen erläutert (vgl. Abbildung):

Struktur eines Perceptrons

Es sei T : ℝ → {0, 1} mit T(ξ) ≔ 0 für ξ< 0 und T(ξ) ≔ 1 für ξ ≥ 0 die für die Ausgabe-Neuronen des Netzes gegebene sigmoidale Transferfunktion. Wenn man diesem zweischichtigen Feed-Forward-Netz eine Menge von t Trainingswerten

Um dies zu erreichen, geht man bei der Perceptron-Lernregel wie folgt vor, wobei λ > 0 ein noch frei zu wählender sogenannter Lernparameter ist, der zum Teil in der Literatur fest auf λ = 1 gesetzt ist:

1. Gewichte wij, 1 ≤ i ≤ n, 1 ≤ j ≤ m:

2. Schwellwerte Θj, 1 ≤ j ≤ m:

Die sukzessive Anwendung des obigen Verfahrens für alle s ∈ {1,…,t} und anschließende Iteration bezeichnet man nun als Perceptron-Lernregel. Es läßt sich zeigen, daß man nach endlich vielen Schritten des obigen Vorgehens ein perfekt auf den Trainingswerten arbeitendes Netz erhält (d.h. alle quadrierten Fehler sind Null), falls für alle j ∈ {1,…,m} die beiden Teilmengen

Aufgrund dieses Resultats muß man also für eine gegebene Menge von Trainingswerten lediglich a priori sicherstellen, daß sie streng linear separierbar ist, um gewährleisten zu können, daß das Netz nach endlich vielen Lernschritten im Ausführ- Modus perfekt auf den Trainingswerten arbeitet. Eines der Probleme des Perceptron-Lernens besteht jedoch genau darin, daß es im allgemeinen ausgesprochen schwierig ist, einer gegebenen Menge von Trainingswerten anzusehen, ob sie streng linear separierbar ist oder nicht. Man müßte zum Beispiel Trennungsalgorithmen für konvexe Mengen einsetzen, wie sie in der Optimierung gebräuchlich sind, allerdings für den Preis eines erheblichen zusätzlichen Rechenaufwands.

Es drängt sich natürlich die Frage auf, was geschieht, wenn man ganz naiv die Perceptron-Lernregel ohne vorherigen Test auf strenge lineare Separierbarkeit anwendet. Im günstigsten Fall bricht das Perceptron-Lernen irgendwann ab, da das Netz perfekt auf den Trainingswerten arbeitet; die gegebene Menge von Trainingswerten ist streng linear separierbar. Im ungünstigsten Fall bricht das Perceptron-Lernen auch nach einer sehr großen Zahl von Iterationsschritten nicht ab, da immer noch einige Trainingswerte nicht beherrscht werden; die Menge der Trainingswerte ist vielleicht nicht streng linear separierbar, oder man hat nur zu früh mit dem Lernen aufgehört. Letztere Situation ist natürlich für die praktische Anwendung des Perceptron-Lernens ein ausgesprochenes Dilemma und Gegenstand verschiedenster Modifikationen und Verbesserungen.

Wenn Sie inhaltliche Anmerkungen zu diesem Artikel haben, können Sie die Redaktion per E-Mail informieren. Wir lesen Ihre Zuschrift, bitten jedoch um Verständnis, dass wir nicht jede beantworten können.