Lexikon der Mathematik: statistische Informationstheorie

beschäftigt sich mit der mathematischen Beschreibung, der Analyse und Bewertung von Systemen, die – in einem sehr weiten Sinne – als Nachrichtenübertragungssysteme aufgefaßt werden können.

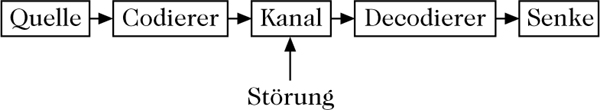

Als Geburtsdatum der Informationstheorie kann das Erscheinen der Arbeiten von C.E. Shannon in den Jahren 1947–1948 angesehen werden. Dabei stehen die statistischen Aspekte, die sich auf eine Wahrscheinlichkeitsverteilung der informationstragenden Elemente (z. B. Zeichen) beziehen, im Vordergrund. Man spricht deshalb auch von der ‚Shannonschen Informationstheorie‘. Der Shannonschen Informationstheorie wird das in der Abbildung dargestellte Modell einer gestörten Nachrichtenübertragung zugrunde gelegt.

Modell der gestörten Nachrichtenübertragung

Für die in der Abbildung enthaltenen Blöcke ‘Quelle’ und ‘Übertragungskanal’ werden wahrscheinlichkeitstheoretische Modelle entwickelt, mit denen die Quellinformation und die vom Kanal unter dem Einfluß von Störungen übertragenen Information (Transinformation) berechnet werden können. Unter der Quelle vertsteht man dabei eine Vorrichtung, die in einer Zeiteinheit genau eines aus einer Menge von Signalen (Zeichen) aussendet. Vom Standpunkt eines außenstehenden Beobachters erscheint das Austreten von Nachrichten aus einer Quelle als ein Zufallsprozeß. Mathematisch wird die Quelle durch ihr Alphabet AQ (die Menge der möglichen Signale) und ein Wahrscheinlichkeitsmaß μ auf der σ-Algebra bzgl. der Menge aller Nachrichten ψ = (…, ψ−1, ψ0, ψ1, …), ψj ∈ AQ, die aus Zeichen des Alphabets AQ gebildet werden können, beschrieben; es ist μ(C) = P(ψ ∈ C). Ein Kanal wird mathematisch durch ein Tripel [AK, vx, BK] beschrieben, wobei AK das Eingangsalphabet des Kanals, BK das Ausgangsalphabet des Kanals, und vx für jede Nachricht x = (…, x−1, x0, x1, …), xj ∈ AK, ein Wahrscheinlichkeitsmaß auf der σ-Algebra bzgl. der Menge aller am Kanalausgang konstruierbaren Nachrichten y = (…,y−1, y0, y1,…), yj ∈ BK ist, falls x gesendet wurde; es gilt

Um eine Nachricht von einer Quelle zu einer Senke zu übertragen, muß sie in der Regel codiert werden. Von der Codierung der Information ist wesentlich die Effektivität der Informationsübertragung abhängig. Dabei geht es um zwei grundlegende Aspekte: Einerseits soll die Quellinformation in einer übertragungsfähigen Form eindeutig und rationell dargestellt werden (Quellcodierung); andererseits soll die Quellinformation gegen Störungen auf dem Übertragungskanal geschützt werden (Kanalcodierung). Einen Code kann man als Abbildung aller mit AQ konstruierten Nachrichten ψ in die Menge aller im Eingangsalphabet AK möglichen Nachrichten x auffassen. Shannon zeigte in seinem ersten Satz, daß es – unter Voraussetzungen, die in den Anwendungen als weitgehend erfüllt angesehen werden können – durch geeignete Wahl eines Codes zwischen AQ und AK immer möglich ist, auch über einem gestörten Kanal Nachrichten beinahe fehlerfrei zu senden. Genauer gesagt gab er hinreichende Bedingungen dafür an, daß sich – bei gegebenen AQ und AK – zu beliebigem ε > 0 immer ein n ∈ ℕ und ein Code zwischen AQ und AK so finden lassen, daß sich ein von der Nachrichtenquelle ausgesendetes Wort ψ(n) = (ψ1, …, ψn), ψi ∈ AQ, aus n Buchstaben des Alphabets AQ anhand des am Kanalausgang empfangenen Wortes y = (…, y−1, y0, y1, …), yj ∈ Bk, mit einer Wahrscheinlichkeit von mehr als 1 − ε richtig bestimmen läßt. Der zweite Shannonsche Satz beinhaltet, daß dabei die Informationsmenge, die ein am Kanalausgang ankommender Buchstabe im Mittel mitbringt (die sogenannte Entropie), nur um beliebig wenig von der Informationsmenge abweicht, die ein Buchstabe am Kanaleingang im Mittel besitzt.

Sätze, die sich mit der Existenz, Konstruktion und den Eigenschaften solcher Codes befassen, heißen Codierungssätze und bilden den Inhalt der Codierungstheorie. Die Informationstheorie bestimmt dagegen die Möglichkeiten und Grenzen der Informationsübertragung bei einer geeigneten Codierung. Aus diesem Grunde spricht man auch von der ‚Informations- und Codierungstheorie‘ häufig im Zusammenhang.

[1] Mildenberger, O.: Informationstheorie und Codierung. Braunschweig/Wiesbaden: Vieweg, 1990.

[2] Heise, W.; Quattrocchi, P.: Informations- und Codierungstheorie. Springer-Verlag Berlin/Heidelberg/New York, 1995.

Wenn Sie inhaltliche Anmerkungen zu diesem Artikel haben, können Sie die Redaktion per E-Mail informieren. Wir lesen Ihre Zuschrift, bitten jedoch um Verständnis, dass wir nicht jede beantworten können.