Statistik: Der Fluch des p-Werts

Für einen kurzen Augenblick stand Matt Motyl an der Schwelle zum wissenschaftlichen Ruhm. Im Jahr 2010 entdeckte er bei einem Experiment, dass Extremisten die Welt in Schwarz und Weiß sehen – und das ganz buchstäblich.

Seine Ergebnisse waren "klar wie der helllichte Tag", erinnert sich der Psychologiedoktorand an der University of Virginia in Charlottesville. Seine Studie an 2000 Probanden ergab, dass die Links- oder Rechtsextremen unter den Teilnehmern diverse Grauschattierungen schlechter unterscheiden können als politisch moderater eingestellte Menschen.

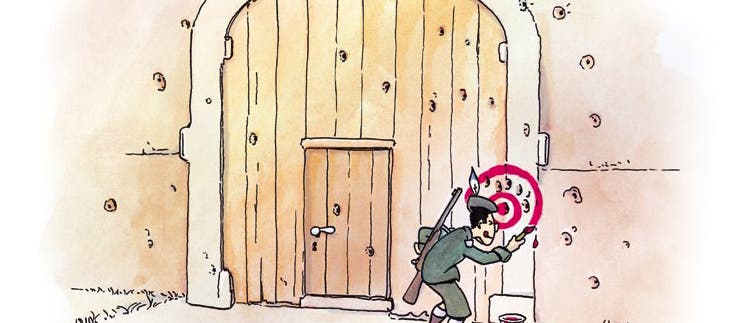

Dann aber kam ihm die Realität in die Quere. Da Motyl und seinem Betreuer Brian Nosek der Streit über die mangelnde Reproduzierbarkeit wissenschaftlicher Studien geläufig war, wiederholten sie vorsichtshalber das Experiment. Mit den neuen Daten sprang der p-Wert auf 0,59 – weit jenseits der Schwelle von 0,05, unterhalb der ein Ergebnis als signifikant gilt. So verschwand der Effekt, und mit ihm Motyls Traum vom frühen Ruhm.

Wie sich später herausstellte, war dem Doktoranden nicht etwa eine mangelhafte Datenerhebung oder ein Rechenfehler unterlaufen. Schuld war vielmehr die trügerische Natur des p-Werts selbst. Der ist nämlich keineswegs so verlässlich und objektiv, wie die meisten Wissenschaftler annehmen. "p-Werte leisten nicht, was sie sollen, weil sie es nicht können", sagt Stephen Ziliak von der Roosevelt University in Chicago, Wirtschaftswissenschaftler und prominenter Kritiker des üblichen Umgangs mit Statistik. ...

Schreiben Sie uns!

3 Beiträge anzeigen