Gehirn-Computer-Schnittstelle: Hirnimplantat lässt Mann mit natürlicher Betonung sprechen und singen

Ein Mann mit einer schweren Sprachbehinderung kann dank einer Gehirn-Computer-Schnittstelle, die neuronale Aktivität unmittelbar in Worte umsetzt, ausdrucksstark sprechen und singen. Das Hirnimplantat überträgt Tonwechsel, wenn er Fragen stellt, betont die von ihm gewählten Wörter und ermöglicht es ihm, eine Reihe von Noten in drei Tonhöhen zu summen.

Das in »Nature« beschriebene System – eine so genannte Gehirn-Computer-Schnittstelle (im Englischen Brain-Computer Interface, BCI) – nutzte künstliche Intelligenz (KI), um die elektrische Hirnaktivität zu decodieren, während der Mann zu sprechen versuchte. Das Gerät ist das erste, das nicht nur die von einer Person beabsichtigten Worte wiedergibt, sondern auch Merkmale der natürlichen Sprache wie Tonfall, Tonhöhe und Betonung, die dazu beitragen, Bedeutung und Emotionen auszudrücken.

Eine synthetische Stimme ahmte dabei jene des Teilnehmers nach und erzeugte Worte innerhalb von zehn Millisekunden nach der neuronalen Aktivität, die seine Sprechabsicht signalisierte. Das System stellt eine erhebliche Verbesserung gegenüber früheren BCI-Modellen dar, bei denen die Sprache innerhalb von drei Sekunden gestreamt oder erst erzeugt wurde, nachdem eine Person einen ganzen Satz nachgeahmt hatte. »Dies ist der heilige Gral der Sprach-BCIs«, sagt Christian Herff, Neurowissenschaftler an der Universität Maastricht, der nicht an der Studie beteiligt war. »Das ist jetzt echte, spontane, kontinuierliche Sprache.«

Decoder in Echtzeit

Der Studienteilnehmer, ein 45-jähriger Mann, verlor seine Fähigkeit, deutlich zu sprechen, nachdem er an amyotropher Lateralsklerose (ALS) erkrankt war. Hierbei handelt es sich um eine Motoneuronen-Erkrankung, bei der jene Nerven geschädigt werden, die die Muskelbewegungen steuern – einschließlich derer, die für die Sprache zuständig sind. Er konnte zwar noch Laute erzeugen und Wörter aussprechen, aber seine Sprache war langsam und undeutlich.

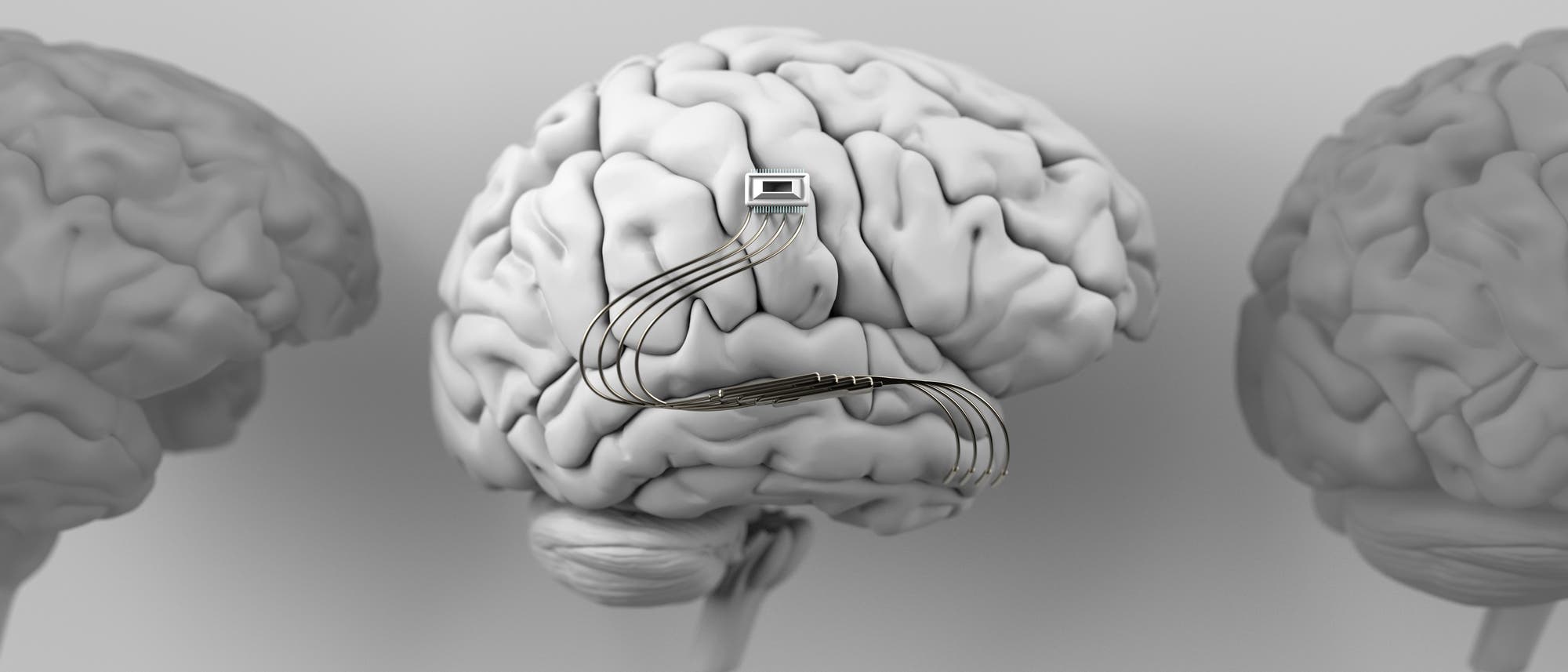

Fünf Jahre nach Beginn seiner Symptome wurde der Mann operiert. Dabei wurden ihm 256 Siliziumelektroden mit einer Länge von je 1,5 Millimetern in eine Hirnregion eingesetzt, die Bewegungen kontrolliert. Maitreyee Wairagkar von University of California, Davis, und ihre Kollegen trainierten dafür Deep-Learning-Algorithmen, um die Signale in seinem Gehirn alle zehn Millisekunden zu erfassen. Ihr System decodiert in Echtzeit die Laute, die der Mann zu produzieren versucht, und nicht etwa seine beabsichtigten Worte.

»Wir benutzen nicht immer Worte, um zu kommunizieren, was wir wollen. Wir haben Zwischenrufe. Wir haben andere ausdrucksstarke Vokalisationen, die nicht im Wortschatz enthalten sind«, erklärt Wairagkar. »Um das zu erreichen, haben wir diesen völlig freien Ansatz gewählt.« Das Team passte die synthetische Stimme auch so an, dass sie wie die Stimme des Mannes klang. Hierzu trainierte es KI-Algorithmen mit Aufnahmen von Interviews, die er vor dem Ausbruch seiner Krankheit geführt hatte.

Die Fachleute baten den Teilnehmer, Zwischenrufe wie »aah«, »ooh« und »hmm« zu machen und erfundene Wörter zu sagen. Das BCI produzierte diese Laute erfolgreich und zeigte damit, dass es Sprache erzeugen kann, ohne einen festen Wortschatz zu benötigen.

Freiheit der Sprache

Mit dem Gerät buchstabierte der Mann Begriffe, antwortete auf offene Fragen und sagte, was er wollte, wobei er einige Wörter verwendete, die nicht zu den Trainingsdaten des Decoders gehörten. Er erzählte den Forschern, dass er sich beim Hören der synthetischen Stimme »glücklich« fühle und diese sich wie seine »echte Stimme« anhöre. In anderen Experimenten erkannte das BCI, ob der Teilnehmer versuchte, einen Satz als Frage oder als Aussage zu formulieren. Das System stellte auch fest, wann er verschiedene Wörter im selben Satz betonte, und konnte den Tonfall seiner synthetischen Stimme entsprechend anpassen. »Wir bringen all diese verschiedenen Elemente der menschlichen Sprache ein, die wirklich wichtig sind«, sagt Wairagkar. Frühere BCIs konnten nur flache, monotone Sprache erzeugen.

»Dies ist eine Art Paradigmenwechsel in dem Sinne, dass es wirklich zu einem realen Werkzeug führen kann«, sagt Silvia Marchesotti, Neuroingenieurin an der Universität Genf. Die Funktionen des Systems seien »entscheidend für die Übernahme in den täglichen Gebrauch für die Patienten der Zukunft«.

Wenn Sie inhaltliche Anmerkungen zu diesem Artikel haben, können Sie die Redaktion per E-Mail informieren. Wir lesen Ihre Zuschrift, bitten jedoch um Verständnis, dass wir nicht jede beantworten können.