Hirnforschung: Belauscht

Mit einem Programm, das die Hirnaktivität im Hörkortex in den ursprünglich gehörten Klang zurückübersetzt, sind Wissenschaftler der Verarbeitung gesprochener Sprache auf der Spur. Das Verfahren der Forscher um Brian Pasley funktioniert bereits so gut, dass sich das Wort erkennen lässt, das sie ihrem Probanden vorsprachen.

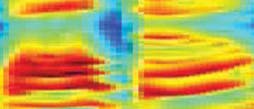

Für ihre Studie hatten sich die Wissenschaftler der University of California in Berkeley an Freiwillige gewandt, denen eine Gehirn-OP im Bereich des linken Schläfenlappens bevorstand und deren Schädel daher für genauere Untersuchungen geöffnet werden musste. Der Grund: Um an die nötigen Daten zu gelangen, mussten Pasley und Kollegen dünne Elektroden direkt auf der Kortexoberfläche ihrer 15 Patienten befestigen. Mit ihnen registrierten sie die elektrischen Signale der Nervenzellen, während die Probanden einsilbige Wörter hörten. Dann ließen sie den Computer lernen, aus dem Aktivierungsmuster auf die klangliche Gestalt des Ausgangsworts zurückzuschließen.

Wie Pasley und Kollegen erläutern, sei ein solches Verfahren für Hirnforscher vor allem deshalb interessant, weil es ihnen etwas über die Art verrate, wie die Areale der Hörwahrnehmung Informationen kodieren und weiterverarbeiten. Ihr Mustererkennungsprogramm kann nämlich nur dann richtig funktionieren, wenn sie mit ihren Annahmen über den zu Grunde liegenden Kode richtig lagen.

So zeigte sich beispielsweise, dass die Neurone in den untersuchten Arealen nicht nur auf die reine Frequenzverteilung spezialisiert sind, die einen Gesamtklang ausmachen. Vielmehr spiegelt die Nervenzellaktivität auch schnelle Frequenzveränderungen wider, wie sie für Sprachlaute typisch sind. Als die Wissenschaftler den Computer danach suchen ließen, ob in den Hirnaktivitätsmustern solche Frequenzverschiebungen kodiert sind, erhielten sie merklich genauere Rekonstruktionen.

Noch zählen die Experimente eher zur Grundlagenforschung, meinen die Wissenschaftler. Eines Tages könnte ein ähnliches System jedoch auch Patienten zugutekommen, die auf Grund einer Krankheit die Fähigkeit zum Sprechen verloren haben: Da innerer Monolog vermutlich dieselben Hirnareale aktiviert, welche die Forscher jetzt im Fokus hatten, könnte ein weiterentwickeltes Rekonstruktionsprogramm den Patienten eine Stimme zurückgeben. Dazu wird es allerdings auch nötig sein, die Hirnaktivitätsmuster auf einem weniger invasiven Weg zu erfassen.

Wenn Sie inhaltliche Anmerkungen zu diesem Artikel haben, können Sie die Redaktion per E-Mail informieren. Wir lesen Ihre Zuschrift, bitten jedoch um Verständnis, dass wir nicht jede beantworten können.