Neuroprothese : Hirnchip mit Passwortschutz liest Gedanken

Ein Hirnimplantat kann die Gedanken einer Person entschlüsseln – und übersetzt sie nur dann, wenn jemand an ein voreingestelltes Passwort denkt. Die Gehirn-Computer-Schnittstelle (im Englischen Brain-Computer Interface, BCI) erkannte dabei bis zu 74 Prozent der gedachten Sätze korrekt. Das Gerät begann erst dann mit der Entschlüsselung der inneren Dialoge der Nutzer, wenn diese an ein bestimmtes Schlüsselwort dachten. Dadurch wurde sichergestellt, dass das System nicht versehentlich Sätze übersetzte, die die Versuchspersonen lieber für sich behalten wollten.

Die am 14. August in »Cell« veröffentlichte Studie stellt einen »technisch beeindruckenden und bedeutenden Schritt« in der Entwicklung von BCI-Geräten dar, die innere Sprache genau entschlüsseln, sagt Sarah Wandelt, Neuroingenieurin am Feinstein Institute for Medical Research in Manhasset, New York. Sie selbst war nicht an der Arbeit beteiligt. Der Passwortmechanismus biete eine einfache Möglichkeit, die Privatsphäre der Patienten zu schützen, was für den Einsatz in der Praxis von entscheidender Bedeutung sei.

Unerwünschtes Abhören verhindern

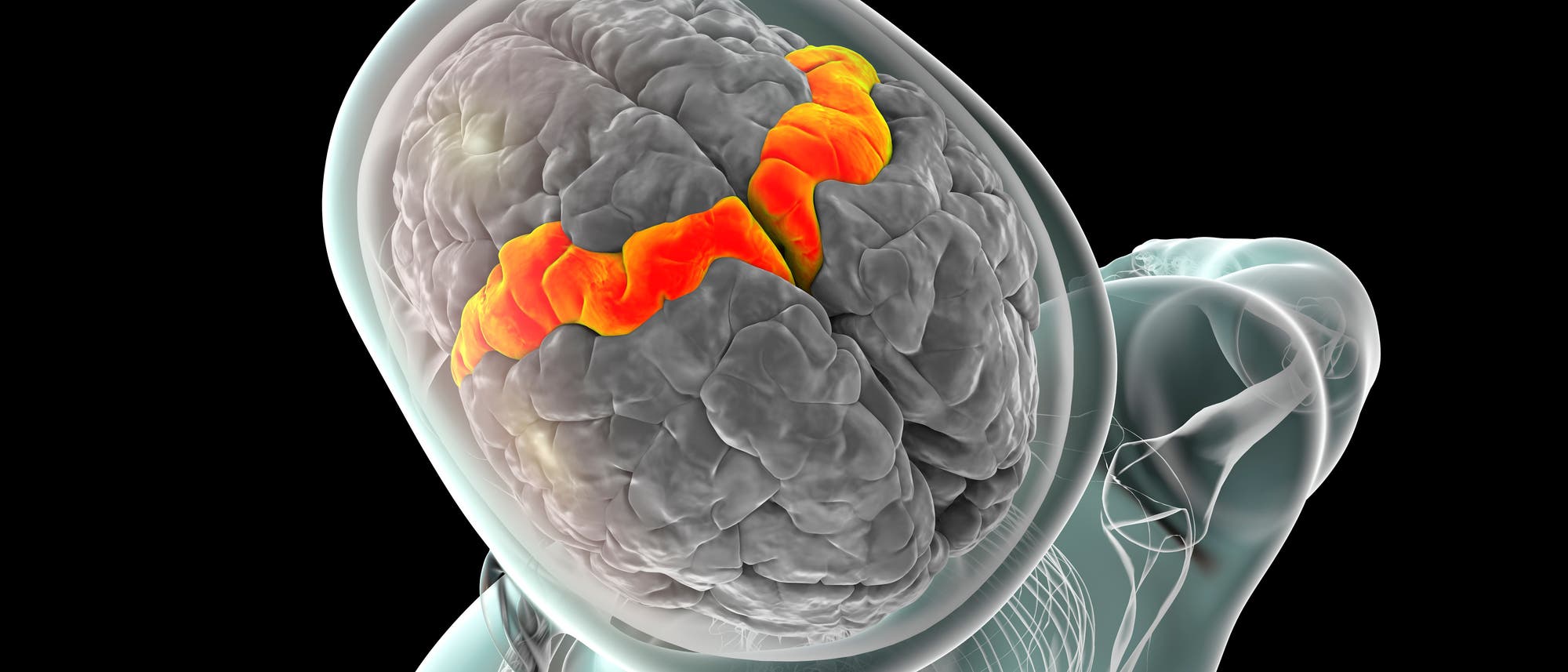

BCI-Systeme übersetzen Hirnsignale in Text oder Ton und sind vielversprechende Hilfsmittel für die Wiederherstellung der Sprachfähigkeit, zum Beispiel bei Menschen mit Lähmungen. Bei den meisten Geräten müssen die Patienten allerdings versuchen, laut zu sprechen, was anstrengend ist und die Kommunikation verlangsamt. Im Jahr 2024 entwickelten Sarah Wandelt und ihre Kollegen daher das erste BCI zur Entschlüsselung der inneren Sprache, das sich auf Signale im supramarginalen Gyrus stützt. Diese Hirnregion spielt eine wichtige Rolle bei der Sprache und beim Sprechen.

Es bestehe jedoch die Gefahr, dass die BCI-Systeme für innere Sprache versehentlich Sätze entschlüsseln, die die Nutzenden nie aussprechen wollten, sagt Erin Kunz, Neuroingenieurin an der Stanford University in Kalifornien und eine Autorin der neuen Studie. »Wir wollten dies gründlich untersuchen«, erklärt sie.

Zunächst analysierten Kunz und ihr Team die Hirnsignale von vier Freiwilligen, die mithilfe von Mikroelektroden im motorischen Kortex – der Region, die für willkürliche Bewegungen zuständig ist – aufgezeichnet wurden. Alle vier hatten Probleme beim Sprechen, eine Person aufgrund eines Schlaganfalls und drei aufgrund einer Motoneuronerkrankung, bei der eine Degeneration von Nervenzellen zum Verlust der Muskelkontrolle führt. Die Fachleute baten die Probanden, entweder zu versuchen, eine Reihe von Wörtern auszusprechen, oder sich vorzustellen, sie auszusprechen. Die Hirnaktivität offenbarte, dass das versuchte Sprechen und die innere Sprache ihren Ursprung in derselben Hirnregion hatten und ähnliche neuronale Signale erzeugten, wobei die Signale gedachter Sätze schwächer waren.

Als Nächstes trainierten Kunz und ihre Kollegen eine künstliche Intelligenz mit den Daten, um Phoneme, die kleinsten Einheiten der Sprache, in den neuronalen Aufzeichnungen zu erkennen. Mithilfe von Sprachmodellen fügte das Team diese Phoneme in Echtzeit zu Wörtern und Sätzen zusammen, die aus einem Wortschatz von 125 000 Wörtern stammen.

Hirnimplantat soll weiter verbessert werden

Das System interpretierte dabei 74 Prozent der Sätze korrekt, an die zwei der Teilnehmer denken sollten. Die Genauigkeit ist laut Kunz mit dem früheren BCI des Teams vergleichbar. In einigen Fällen entschlüsselte das Gerät auch Zahlen, die sich die Nutzer vorstellten, als sie in Gedanken rosa Rechtecke auf einem Bildschirm zählen sollten. Das deutet darauf hin, dass es spontane Selbstgespräche erkennen kann. Damit die Teilnehmenden kontrollieren können, wann die Entschlüsselung beginnt, fügte das Team ihrem System ein Passwort hinzu. Als sich ein Proband das Passwort »Chitty-Chitty-Bang-Bang« (der Name eines englischsprachigen Kinderromans) vorstellte, erkannte das BCI es mit einer Genauigkeit von mehr als 98 Prozent.

Die Studie sei spannend, weil sie die neuronalen Unterschiede zwischen innerem und versuchtem Sprechen aufdecke, findet Silvia Marchesotti, Neuroingenieurin an der Universität Genf. Künftig sei es auch wichtig, Sprachsignale in anderen Hirnregionen als dem motorischen Kortex zu untersuchen, fügt sie hinzu. Neben einer verbesserten Geschwindigkeit und Genauigkeit des Systems haben die Fachleute genau das vor: »Wenn wir uns andere Teile des Gehirns ansehen, können wir vielleicht auch weitere Arten von Sprachstörungen behandeln«, sagt Kunz.

Wenn Sie inhaltliche Anmerkungen zu diesem Artikel haben, können Sie die Redaktion per E-Mail informieren. Wir lesen Ihre Zuschrift, bitten jedoch um Verständnis, dass wir nicht jede beantworten können.