Modellansatz: Flugunfälle

Vom 10. – 13. Mai 2018 fand im ZKM und in der Hochschule für Gestaltung (HfG) die GPN18 statt. Dort traf Sebastian auf Bernd Sieker und sprach mit ihm um Unfälle mit Autopiloten mit Flugzeugen und Automobilen.

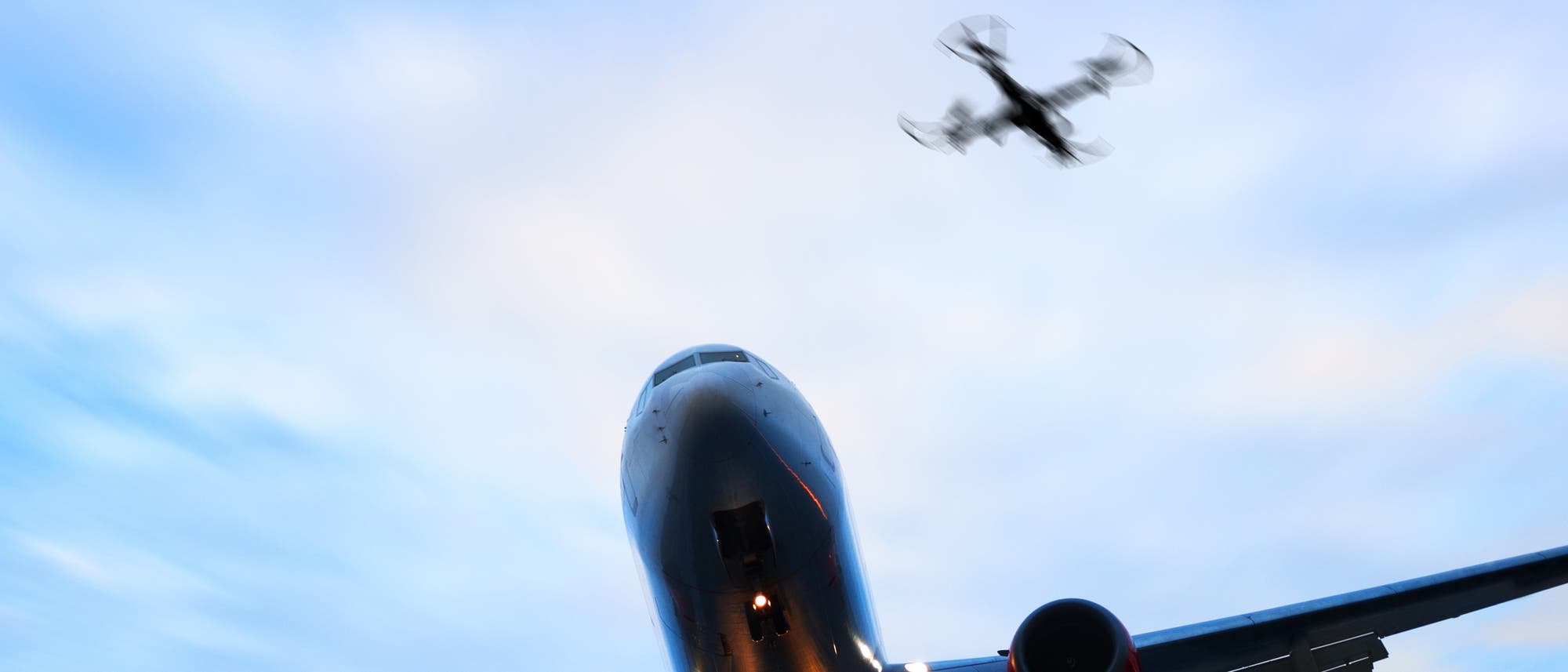

Der Flugreiseverkehr ist inzwischen sehr sicher, es verbleibt aber ein Restrisiko, das man an den sehr seltenen Flugunfällen erkennen kann. Bernd untersucht nun die wenigen Abstürze großer Airliner, die es noch gab, und fragt sich, wie es zu diesen Katastrophen kommen konnte.

Beispiele für Unfallursachen können beispielsweise Ausfälle scheinbar weniger relevanter Systeme sein, wo von der Crew Entscheidungen getroffen werden, die sie für sinnvoll halten, sich aber später als problematisch herausstellen. Technische Schäden, die unmittelbar zum Absturz führen, sind inzwischen sehr selten. Und selbst scheinbare kritische Ausfälle wie Triebwerksausfälle werden geübt und es gibt Prozeduren, wie man in diesen Fällen das Flugzeug möglichst sicher landen können sollte.

Im Segelflug gehört eine Außenlandung auf freiem Feld zum Normalbetrieb, wobei man natürlich für am Boden etwaig entstandenen Schaden aufkommen muss, falls der Landwirt darauf besteht. Eine entsprechende nicht genehmigte Sicherheits- oder Notlandung führt bei Motorflugzeugen zur Auskunfts- oder Meldepflicht mit entsprechenden Auflagen zum Abtransport oder Erlaubnis zum Wiederstart.

Bei der Untersuchung von Unglücksfällen geht der erste Blick auf offizielle Berichte oder Untersuchungen. So auch beim Air-France Flug 447 von 2009, wo ein Airbus A330-203 mitten über dem Atlantik plötzlich verschwand. Erste Indizien auf das Unglück wurden durch ACARS-System über Satellit empfangen, unter anderem über den Ausfall von Staurohren, mit denen die Geschwindigkeit des Flugzeugs gemessen wird. Das ist ein dramatischer Ausfall an Information, mit dem die Piloten aber umgehen können müssten und der eigentlich nicht zu einem Absturz führen sollte, denn die Geschwindigkeit ist noch mittels anderer Sensoren erkennbar. Erste gefundene Wrackteile deuteten darauf hin, dass das Flugzeug fast senkrecht in horizontaler Lage auf das Wasser aufgeschlagen sein musste. Dies führte auf die Vermutung, dass das Flugzeug überzogen wurde, bis es zum Strömungsabriss kam, und es daraufhin einfach herunterfiel.

Nach Bergung des Flugschreibers bestätigte sich der vermutete Ablauf. Er wurde durch einen überraschend kurzen Zeitraum von wenigen Minuten zwischen Fehlermeldung und Absturz aus Reiseflughöhe belegt. Die Piloten müssen in der widersprüchlichen Situation gewesen sein, dass ihnen der Sink"flug" angezeigt wurde, während die Nase des Flugzeugs nach oben zeigte, was laut Training normalerweise in diesem Flugzustand nicht möglich ist. Bei dem eingesetzten Fly-by-wire System wäre eigentlich auch kein Strömungsabriss möglich gewesen. Nach Ausfall der Staurohre führte nun die Verkettung zwischen unvorhersehbarem Flugzeugzustand und der dramatischen Fehlinterpretation durch die Piloten zum Absturz.

In der Ursachenanalyse ist sowohl zu beachten, dass die Warnmeldungen zum Strömungsabriss von den Piloten womöglich wegen einer Vielzahl von Warnmeldungen nicht mehr erfasst werden konnte. Ebenso wurden widersprüchliche Angaben zur Fluggeschwindigkeit und Anstellwinkeln von den Systemen des Flugzeugs irgendwann als ungültig abgewiesen und entsprechende Warnungen abgeschaltet oder nur noch widersprüchlich wiedergegeben.

Dies führt zur Betrachtung solcher Systeme unter dem Aspekt, dass sie sozio-technisch sind, mit der Einsicht, dass gerade bei der Übertragung von Aufgaben des Menschen an Technik und zurück ein besonderes und schwer vorhersehbares Fehlerpotenzial besteht. Insbesondere Autopiloten haben eine besondere Bedeutung, da sie direkt in die Aufgaben der steuernden Menschen eingreifen. Klassisch steuern Autopiloten nur in sehr engen Parametern wie einzuhaltende Richtung, Höhe, Querneigung der Sink-/Steiggeschwindigkeit. Im Auto sind schon Geschwindigkeits- und Abstandsautomatik üblich. Jedoch sind auch Landungen mit Autopilot möglich, die aber ein besonderes Training und Überprüfung von Mensch und Maschine und Verbesserung der Algorithmen und redundante Sensoren erfordern. Dies zeigt schon, wie kritisch Autopiloten im Automobil zu sehen sind, da hier bisher kein besonderes Training für die Verwendung von Autopiloten erfolgt. Eine Überraschung ist dabei, dass eine besondere Gefahr daraus entsteht, wenn Autopiloten so zuverlässig werden dass sich Menschen zu sehr auf sie verlassen. Überraschende Situationen kann aber der Mensch meist besser bewältigen.

Bei der Untersuchung von Flugunfällen stellt sich besonders die Frage, welche Ereignisse die eigentliche Ursache also für das Unglück verantwortlich sind. Wie ist hier Kausalität zu definieren? An der Uni Bielefeld wurde in der Arbeitsgruppe von Prof. Ladkin dazu die Why-Because-Analysis (WBA) entwickelt, wo die Counterfactual Test Theory von David Lewis zum Einsatz kommt. Aus der Überprüfung, ob ein Ereignis notwendig und die Menge der gefunden Ereignisse hinreichend für die Entstehung eines Ereignisses war, entsteht ein kausaler "Why-Because"-Graph (WBG), der genau nur die Ereignisse zusammenfasst, die notwendig zum Unglück führten.

Ein interessantes philosophisches Konstrukt ist hier die Nearest-Possible-World-Theory, die ein Szenario konstruiert, das dem Unglück möglichst stark ähnelt, für das aber es nicht zum Unglück gekommen wäre. Was war hier anders? Was können wir daraus lernen?

Durch Vergleich mit vorherigen dokumentierten Ereignissen können Teile des WBG auch quantitativ bewertet werden, obgleich die Datenbasis oft sehr gering ist. Dennoch können Schlüsse gezogen werden, welche Ereignisse bisher ignoriert wurden und ob dies gerechtfertigt ist.

Das National Transportation Safety Board (NTSB) befasst sich in den USA wie die Bundesstelle für Flugunfalluntersuchung (BFU) in Deutschland typischerweise mit der Aufarbeitung von Unglücksfällen, und wie diesen in Zukunft entgegengewirkt werden kann. Darüber hinaus haben ebenso Versicherungen von Fluggesellschaften ein großes Interesse an einer Aufarbeitung, da die Fluggesellschaften in vielen Bereichen für Unglücke haftbar sind, soweit sie nicht nachweisen können, dass die Hersteller verantwortlich zu machen sind.

Während des Asiana Airlines Flug 214 kam es in einer Boeing 777 im Anflug auf San Francisco 2013 im Landeanflug zu einer "Mode Confusion" beim Autopilot: Die erwartete Schubregulierung blieb aus, und es kam zu einem Absturz. Im Fall des Turkish Airlines Flug 1951 mit einer Boeing 737 nach Amsterdam gab es im Anflug einen Fehler im Radarhöhenmessgerät, wodurch der Autopilot in Erwartung der Landung aktiv den Schub zurückregelte. Die Korrektur der Piloten schlug fehl, da sie sich nicht über die genauen Abläufe im Klaren waren.

Dies deutet schon deutlich darauf, dass Schwierigkeiten beim Einsatz von Autopiloten im automobilen Umfeld zu erwarten sind. Darüber hinaus sind die erforderlichen menschlichen Reaktionszeiten im Auto deutlich kürzer, so dass Missverständnisse oder das An- oder Abschalten von Autopilot-Funktionen deutlich leichter zu Unglücken führen können. Eine wichtige Einstufung sind hier die erreichten SAE Autonomiestufen, die beschreiben, wie weit das Fahrzeug Aufgaben des Fahrens übernehmen kann. Besonders problematisch ist Autonomiestufe 3: Hier darf der Fahrer sich während der Fahrt anderen Dingen als der Fahrzeugführung zuwenden, muss aber nach einer gewisse Vorwarnzeit wieder die Führung wieder übernnehmen können. Selbst bei wenigen Sekunden wird dies bei höheren Geschwindigkeiten sehr schwer zu erfüllen sein. Bei Stufe 4 muss das Fahrzeug auch ohne Fahrerintervention sicher bleiben, notfalls durch Anhalten, Stufe 5 ist vollständig autonom von Tür zu Tür.

Ein weiterer Gesichtspunkt ist die vorhandene Sensoraustattung und deren Ausfallsicherheit oder die Interpretation der Sensormessungen. Im Fall des Unfalls eines Uber-Autos am 18. März 2018 in Arizona wurde eine Fußgängerin von den Sensoren zwar erfasst, jedoch wurden die Detektion durch die Software als Fehler zurückgewiesen und es kam zum Unfall. Die hier verwendete Software war und wird weit weniger getestet und formal geprüft als Software im Luftfahrtumfeld, da dies auch im Bezug auf neuronale Bilderkennungsverfahren schwer umzusetzen sein wird.

Ein weiterer Aspekt ist, dass selbst wenn ein sozio-technisches System sicherer als Menschen fährt, die Akzeptanz nur sehr schwer zu erreichen sein und viele rechtliche und ethische Fragen zunächst zu klären wären.

Vielen Dank an Markus Völter für die Unterstützung in dieser Folge.

Literatur und weiterführende Informationen

- D. Lewis: Counterfactuals and comparative possibility, Springer, Dordrecht, 57-85, 1973.

- P. Ladkin: Causal reasoning about aircraft accidents, International Conference on Computer Safety, Reliability, and Security. Springer, Berlin, Heidelberg, 2000.

- B. Sieker: Visualisation Concepts and Improved Software Tools for Causal System Analysis, Diplomarbeit an der Technischen Fakultät der Universität Bielefeld, 2004.

- B. Sieker: Systemanforderungsanalyse von Bahnbetriebsverfahren mit Hilfe der Ontological Hazard Analysis am Beispiel des Zugleitbetriebs nach FV-NE, Dissertation an der Technischen Fakultät der Universität Bielefeld, 2010.

- Causalis Limited

- Research Group Networks, System Safety, Embedded and Distributed Systems

- B. Sieker: Hold Steering Wheel! Autopilots and Autonomous Driving. Presentation at the Gulaschprogrammiernacht 18, ZKM/HfG, Karlsruhe, 2018.

- B. Sieker: What's It Doing Now? The Role of Automation Dependency in Aviation Accidents. Presentation at the Chaos Communication Congress 33C3, 2016.

Podcasts

- H. Butz, M. Völter: Komplexe Systeme, Folge 058 im omega tau Podcast, Markus Völter und Nora Ludewig, 2011.

- S. B. Johnson, M. Völter: System Health Management, Episode 100 in the omega tau Podcast, Markus Völter and Nora Ludewig, 2012.

- R. Reichel, M. Völter: Fly by Wire im A320, Folge 138 im omega tau Podcast, Markus Völter und Nora Ludewig, 2014.

- S., J., C., A., M. Völter: Mit Lufthansas A380 nach Hong Kong Teil 1, Folge 262 im omega tau Podcast, Markus Völter und Nora Ludewig, 2017.

- S., J., C., A., M. Völter: Mit Lufthansas A380 nach Hong Kong Teil 2, Folge 263 im omega tau Podcast, Markus Völter und Nora Ludewig, 2017.

- P. Nathen, G. Thäter: Lilium, Gespräch im Modellansatz Podcast, Folge 145, Fakultät für Mathematik, Karlsruher Institut für Technologie (KIT), 2017.

GPN18 Special

- B. Sieker, S. Ritterbusch: Flugunfälle, Gespräch im Modellansatz Podcast, Folge 175, Fakultät für Mathematik, Karlsruher Institut für Technologie (KIT), 2018. http://modellansatz.de/flugunfaelle

- A. Rick, S. Ritterbusch: Erdbebensicheres Bauen, Gespräch im Modellansatz Podcast, Folge 168, Fakultät für Mathematik, Karlsruher Institut für Technologie (KIT), 2018. http://modellansatz.de/erdbebensicheres-bauen

GPN17 Special

- Sibyllinische Neuigkeiten: GPN17, Folge 4 im Podcast des CCC Essen, 2017.

- A. Rick, S. Ritterbusch: Bézier Stabwerke, Gespräch im Modellansatz Podcast, Folge 141, Fakultät für Mathematik, Karlsruher Institut für Technologie (KIT), 2017. http://modellansatz.de/bezier-stabwerke

- F. Magin, S. Ritterbusch: Automated Binary Analysis, Gespräch im Modellansatz Podcast, Folge 137, Fakultät für Mathematik, Karlsruher Institut für Technologie (KIT), 2017. http://modellansatz.de/binary-analyis

- M. Lösch, S. Ritterbusch: Smart Meter Gateway, Gespräch im Modellansatz Podcast, Folge 135, Fakultät für Mathematik, Karlsruher Institut für Technologie (KIT), 2017. http://modellansatz.de/smart-meter

GPN16 Special

- A. Krause, S. Ritterbusch: Adiabatische Quantencomputer, Gespräch im Modellansatz Podcast Folge 105, Fakultät für Mathematik, Karlsruher Institut für Technologie (KIT), 2016. http://modellansatz.de/adiabatische-quantencomputer

- S. Ajuvo, S. Ritterbusch: Finanzen damalsTM, Gespräch im Modellansatz Podcast, Folge 97, Fakultät für Mathematik, Karlsruher Institut für Technologie (KIT), 2016. http://modellansatz.de/finanzen-damalstm

- M. Fürst, S. Ritterbusch: Probabilistische Robotik, Gespräch im Modellansatz Podcast, Folge 95, Fakultät für Mathematik, Karlsruher Institut für Technologie (KIT), 2016. http://modellansatz.de/probabilistische-robotik

- J. Breitner, S. Ritterbusch: Incredible Proof Machine, Gespräch im Modellansatz Podcast, Folge 78, Fakultät für Mathematik, Karlsruher Institut für Technologie (KIT), 2016. http://modellansatz.de/incredible-proof-machine

Wenn Sie Feedback, Lob oder Kritik zu diesem Podcast haben, können Sie die Redaktion per E-Mail kontaktieren. Wir lesen Ihre Zuschrift, bitten jedoch um Verständnis, dass wir nicht jede beantworten können.