Deep Learning: Kann man Sprache aus dem Gehirn »auslesen«?

Eigentlich will er nur ein einfaches »Hallo, wie geht's?« sagen. Doch der Mann ist von Kopf bis Fuß gelähmt. Statt seine Sprechmuskulatur zu gebrauchen, blickt er daher auf Reihen von Buchstaben auf dem Bildschirm. Jede Reihe flackert in einer anderen Frequenz – eine mit sieben, eine andere mit elf Hertz. Nun konzentriert er sich auf eine Reihe mit dem Buchstaben »H«. Sein Gehirn reagiert und zeigt als Resonanz in stärkerem Maß eine Frequenz, die der Frequenz der anvisierten Buchstabenreihe entspricht. Auf seinem Kopf trägt der Mann eine Kappe mit Elektroden, die die registrierten Hirnfrequenzen an einen Computer weiterleiten. Das Computerprogramm weiß nun zumindest schon mal, aus welcher Reihe der von dem Patienten anvisierte Buchstabe stammt. Allmählich kreist die Software das »H« ein, das der Patient als ersten Buchstaben will. So entsteht mühsam erst das »Hallo« und dann der ganze Satz.

Sind Menschen mit dem Locked-in-Syndrom nach einem Schlaganfall vollständig oder fast vollständig in ihren Körper eingeschlossen, stellen solche Computer-Hirn-Schnittstellen oft die einzige Möglichkeit dar, mit der Außenwelt in Kontakt zu treten. Aber die Kommunikation ist äußerst mühsam. Wie der »Buchstabierer« aus unserem fiktiven Fallbeispiel ringen die meisten Nutzer schon damit, auf diesem Weg mehr als 10 Wörter pro Minute von sich zu geben. Zum Vergleich: Im Durchschnitt strömen rund 150 Wörter pro Minute aus dem Munde eines gesunden Sprechers – und das ohne größere Anstrengungen.

Wie sich Hirnsignale in Sprachlaute übersetzen lassen, variiert von Mensch zu Mensch

Für Patienten würde daher ein Traum wahr, könnte man die Wörter und Sätze, die in ihrem Gehirn mit eingeschlossen sind, direkt »auslesen«. Forscher kommen diesem Ziel allmählich näher. Eine besondere Herausforderung ist dabei: Wie sich die Hirnsignale in Sprachlaute übersetzen lassen, variiert von Mensch zu Mensch. Computermodelle müssen individuell trainiert und auf die Patienten zugeschnitten werden. Und dafür brauchen sie möglichst genaue Daten. Denn das Sprechen erfordert eine extrem präzise Orchestrierung. Eine Vielzahl von Organen des Sprechtrakts wie Zunge oder die Lippen müssen äußerst fein im Bereich von Millisekunden aufeinander abgestimmt werden.

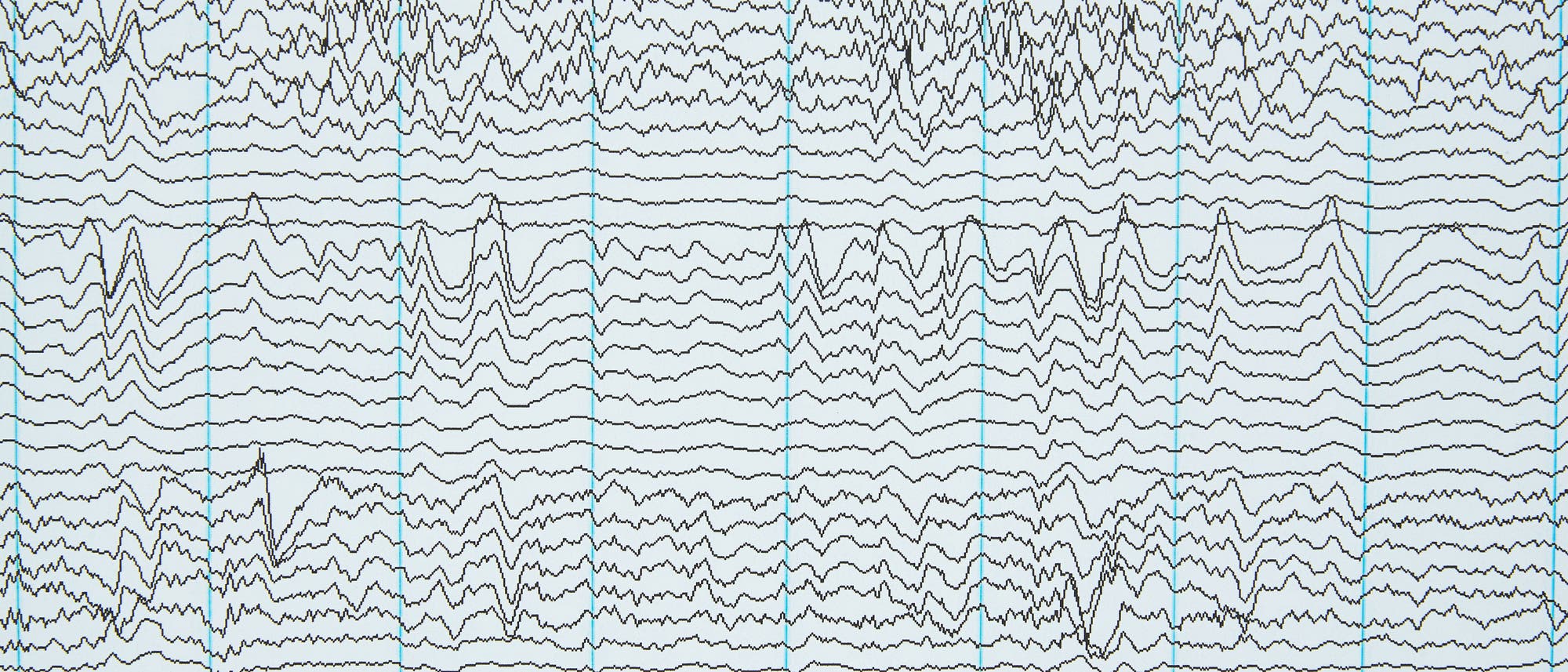

Solche Daten in der gewünschten Präzision zu bekommen, heißt daher leider auch: Man muss den Schädel öffnen. Verschiedene Forscherteams haben nun unabhängig voneinander eine seltene Gelegenheit genutzt. Denn wenn bei Epilepsiepatienten eine OP ansteht, versucht man per Elektrokortikografie den Ursprung der Anfälle zu lokalisieren. Zu diesem Zweck legt man den Patienten im Rahmen eines chirurgischen Eingriffs Elektroden auf die Gehirnoberfläche und registriert die elektrische Aktivität der Denkzentrale. Elektrokortikografie bietet eine hohe räumliche Auflösung im Bereich von Millimetern und eine hohe zeitliche Auflösung im Bereich von Millisekunden. Außerdem deckt sie eine große Breite von Hirnarealen ab – nicht ganz unwichtig, wenn man bedenkt, dass beim Thema Sprache weit verteilte Netzwerke zum Zuge kommen.

Eine solche eher rare Gelegenheit machte sich etwa ein Team um den Informatiker Nima Mesgarani von der Columbia University in New York in einer Studie zu Nutze, die 2018 auf dem Preprintserver bioRxiv erschienen ist. Mittels Elektrokortikografie registrierten die Wissenschaftler die Hirnmuster bei fünf Epilepsiepatienten, während diese verschiedenen Kurzgeschichten lauschten. Anschließend trainierten sie ein tiefes neuronales Netzwerk (deep neural network) mit Aufnahmen vom auditorischen Kortex: Den Patienten hatte man Elektroden über der primären Hörrinde und zudem über dem superioren temporalen Gyrus implantiert.

Letzterer ist Teil des Temporallappens und beheimatet unter anderem das Wernicke-Areal, das entscheidend dafür ist, dass wir Sprache verstehen. So vorbereitet rekonstruierte das tiefe neuronale Netzwerk letztlich gesprochene Zahlen allein anhand der neuronalen Daten. Als ein Computerprogramm daraufhin die Zahlen in gesprochene Sprache umsetzte, konnten Versuchspersonen das Gehörte im Schnitt zu 75 Prozent verstehen.

Der Psychologe Jonas Obleser von der Universität Lübeck sieht das Potenzial des Ansatzes von Mesgarani und seinem Team vor allem in einer Sache: »Man könnte den Ansatz und vorgespielte Sprache nutzen, um bei Locked-in-Patienten intakte Hirnfunktionen, die gehörte Sprache verarbeiten, noch genauer einzugrenzen, als das bislang möglich ist.« Den Einsatz im Rahmen von Computer-Hirn-Schnittstellen zur Kommunikation betrachtet er eher skeptisch. Schließlich gehe es da um Sätze, die die Patienten nicht hören, sondern selbst gedanklich erzeugen. Mehr erwartet Obleser daher von Forschergruppen, die einen Schritt weitergehen und Sprache rekonstruieren, die von den Patienten selbst stammt.

Diesen Weg ging das Team um die Informatikerin Tanja Schultz von der Universität Bremen: Es griff für eine ebenfalls 2018 vorab veröffentlichte Studie auf die Daten von sechs Patienten zurück, denen man wegen einer bevorstehenden Hirntumor-OP Elektroden implantiert hatte. Die Elektroden sollten den Chirurgen dabei helfen, Bewegungs- und Sprachareale zu lokalisieren und bei der OP unangetastet zu lassen. Für die Studie nahmen Schultz und Kollegen per Mikrofon die Stimme der Tumorpatienten auf, während diese größtenteils einsilbige Wörter vorlasen.

Ein tiefes neuronales Netzwerk lernt, Zusammenhänge zwischen Hirnaktivität und Sprachaufnahmen zu finden

Die Elektroden registrierten die Aktivität von Arealen, die an der Sprachplanung beteiligt sind, sowie von motorischen Gebieten, die Befehle an den Sprechtrakt senden. Das Team um Schultz trainierte nun ebenfalls ein tiefes neuronales Netzwerk darauf, Zusammenhänge zwischen der Hirnaktivität und den Sprachaufnahmen zu finden. Anschließend rekonstruierte das Netzwerk Wörter allein anhand von Hirndaten, die es im Training nicht vorgesetzt bekommen hatte. Zwischen den Original- und den rekonstruierten Sprachdaten gab es eine Korrelation von bis zu rund 0,7, eine durchaus beachtliche Übereinstimmung.

Noch etwas weiter gingen der Neurochirurg Edward Chang von der University of California in San Francisco und seine Kollegen. Ihnen gelang es, ganze Sätze aus der Hirnaktivität rekonstruieren. Ihre Grundidee: Der Sprung von Hirndaten zum Sprach-Output ist ziemlich groß. Warum dann nicht eine ganz natürliche Zwischenstufe einschalten? Schließlich steuert das Gehirn nicht direkt das Endprodukt, den Sprachstrom, der den Mund verlässt, sondern die Bewegungen und die Artikulation im Sprechtrakt.

Deshalb zogen die Forscher nicht nur die Hirn- und die akustischen Daten von drei Epilepsiepatienten heran, die ganze Sätze vorgelesen hatten; sie griffen auch auf Daten zu den Bewegungen des Sprechapparats zurück. In einem ersten Schritt »übersetzte« dann ein tiefes neuronales Netz die Tätigkeiten von Arealen wie dem sensomotorischen Kortex in physiologische Signale des Vokaltrakts. Erst in einem zweiten Schritt wandelte ein weiteres Netz diese Daten in hörbare Sprache um. Diese »gesprochenen« Sätze setzte man in einem Onlinetest mehr als 160 Freiwilligen vor, die den jeweiligen Satz aus einem von zehn möglichen auswählen sollten. Im Schnitt lag die Trefferquote bei über 80 Prozent. Selbst mit Hirndaten, denen nur lautlose »Sprache« zu Grunde lag, konnte das Computermodell die betreffenden Sätze bis zu einem gewissen Grad rekonstruieren.

Auch die beiden letztgenannten Ansätze seien natürlich bei Locked-in-Patienten noch nicht anwendbar, sagt der Lübecker Psychologe Jonas Obleser. Schließlich könnten diese ja nicht selbst sprechen. Aber so funktioniere Wissenschaft: »Ich baue auf dieser Basis ein Modell, das möglichst nah an dem ist, was wirklich gesprochen wurde. Und gehe dann davon aus, dass es bis zu einem gewissen Grad auch bei Menschen funktioniert, die nicht mehr sprechen können.«

»Die Studien sind im Grunde nichts Neues, außer dass die ›deep neural networks‹ ein bisschen besser arbeiten als die bisherigen Algorithmen«Niels Birbaumer

Niels Birbaumer, in Sachen Computer-Hirn-Schnittstellen Pionier der ersten Stunde, zeigt sich wenig beeindruckt. »Die Studien sind im Grunde nichts Neues, außer dass die ›deep neural networks‹ ein bisschen besser arbeiten als die bisherigen Algorithmen.« Tatsächlich haben die Teams um Mesgarani, Schultz und Chang kein komplettes Neuland betreten. Schon vorher hatten Forscher Sprache aus der Hirnaktivität rekonstruiert. Doch war die Qualität des Sprach-Outputs zu schlecht, um von Menschen verstanden zu werden. Insofern sind die neuen Ansätze durchaus ein Fortschritt.

Den wundesten Punkt der Studien benennt auch Birbaumer. Hier werde nämlich nur rekonstruiert, was man vorher ohnehin schon ausgesprochen habe. »Ob das bei völlig eingeschlossenen Patienten wirklich funktioniert, ist fraglich.« Aber immerhin, man könne es verstehen. »Würden Sie sich dafür die Schädeldecke aufmachen lassen?«, fragt Birbaumer.

Dass die rekonstruierte Sprache nun tatsächlich verständlich ist, findet der Neurowissenschaftler Gerwin Schalk vom National Center for Adaptive Neurotechnologies at the New York State Department of Health in Albany ermutigend. Es gebe jedoch noch eine Reihe von Hindernissen zu überwinden. Im nächsten Schritte müsse man ähnliche Ergebnisse erzielen, wenn Menschen sich Sätze bloß vorstellten. »Dieser Schritt ist konzeptionell sehr schwer zu realisieren«, so Schalk.

Erste Versuche in diese Richtung gibt es auf jeden Fall bereits. Einer stammt aus dem Jahr 2014 von Wissenschaftlern um die Ingenieurin Stéphanie Martin, die heute an der Ecole Polytechnique Fédérale de Lausanne in der Schweiz forscht. Sie machten Aufnahmen des Gehirns von Epilepsiepatienten, während diese Kurzgeschichten vorlasen, und fütterten mit diesen Daten ein Computermodell. Es konnte daraufhin nicht bloß die laut vorgelesenen Sätze rekonstruieren, sondern sogar Sätze, die die Probanden nur still »im Kopf« lasen und damit gewissermaßen innerlich sprachen. Das war möglich, weil der menschliche Hörkortex beim inneren Sprechen ebenfalls aktiv ist.

Die Rekonstruktion des still »Gesprochenen« fiel allerdings deutlich schlechter aus als die der hörbaren Worte. Die Forscher verglichen auch bei den Durchgängen des stillen Lesens die aus den Hirndaten rekonstruierten Sätze mit den laut gesprochenen aus den ersten Durchgängen. Denn beim stillen Lesen gab es natürlich keinen eigenen Sprach-Output, den man hätte aufnehmen und mit der Rekonstruktion vergleichen können. Und darin besteht eine der größten Herausforderungen: Beim inneren Sprechen fehlt der Sprach-Output, mit dem man ein Computermodell trainieren kann. Martin und ihren Kollegen ging es vor allem um eines: zu zeigen, dass sich die neuronalen Grundlagen von äußerlichem und innerlichem Sprechen zumindest teilweise überlappen.

Ein weiterer wichtiger Schritt hin zu Computer-Hirn-Schnittstellen, die Locked-in-Patienten eine komfortablere Kommunikation als bisher ermöglichen, steht noch bevor: der Übergang von invasiver zu nichtinvasiver Technik. »Die per Elektrokortikografie registrierten Signale in den genannten Untersuchungen stammen direkt von der Hirnoberfläche«, sagt Jonas Obleser. Sie hätten damit eine Qualität, die man mit EEG-Ableitung außerhalb des Schädels nicht erreicht. »Aber wenn wir wissen, wonach wir suchen müssen, können wir sicherlich auch mittels EEG durch den Schädel hindurch die für Gesprochenes relevante elektrische Aktivität ableiten.« Das mühsame Buchstabieren von Wörtern per Computer-Hirn-Schnittstelle könnte dann endlich der Vergangenheit angehören.

Wenn Sie inhaltliche Anmerkungen zu diesem Artikel haben, können Sie die Redaktion per E-Mail informieren. Wir lesen Ihre Zuschrift, bitten jedoch um Verständnis, dass wir nicht jede beantworten können.