Informatik: Zehn Algorithmen, die die Wissenschaft revolutioniert haben

2019 eröffnete das Team des Event Horizon Telescope der Welt den ersten Blick auf ein Schwarzes Loch. Das Bild des glühenden, ringförmigen Objekts, das die Gruppe enthüllte, war jedoch kein herkömmliches Foto. Es wurde aus einer riesigen Menge an Daten berechnet, die Radioteleskope in den Vereinigten Staaten, Mexiko, Chile, Spanien und der Antarktis aufgenommen haben. Die Physiker veröffentlichten den dahinterstehenden Programmcode und dokumentierten ihre Ergebnisse in mehreren Fachartikeln. Damit wollen sie es anderen Naturwissenschaftlern ermöglichen, ihr Vorgehen nachzuvollziehen und darauf aufzubauen.

Nicht nur bei diesem wissenschaftlichen Durchbruch hat die Informatik eine bedeutende Rolle gespielt: Von der Astronomie bis zur Zoologie steht hinter jeder großen Entdeckung der Neuzeit ein Computer. Heutige Rechner haben etwa 10 000-mal mehr Speicher und eine ebenso viel höhere Taktfrequenz als vor 50 Jahren, was der Forschung völlig neue Möglichkeiten eröffnet. »Das Problem ist, dass Programmieren immer noch einiges an Fachwissen erfordert«, sagt der Biologe Michael Levitt von der Stanford University in Kalifornien, der 2013 den Chemie-Nobelpreis für seine Arbeit zur Modellierung chemischer Strukturen erhielt. Deshalb braucht man naturwissenschaftliche Informatiker. Denn leistungsstarke Computer sind nutzlos ohne die passende Software – und ohne Forscher, die sie einzusetzen wissen.

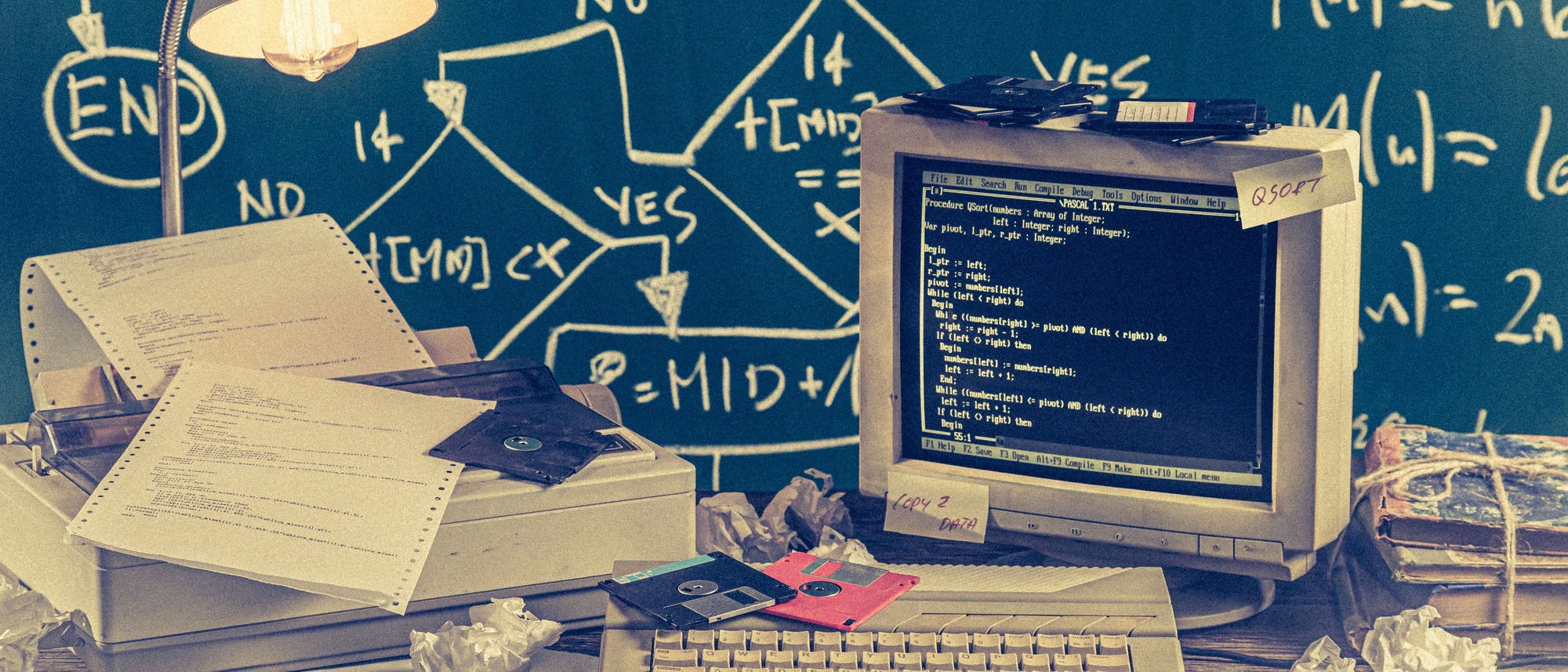

In diesem Artikel blicken wir hinter die Kulissen und stellen zehn der größten Fortschritte der Informatik vor, welche die Forschung in den vergangenen Jahrzehnten vorangebracht haben.

1. Sprachpionier: Fortran-Compiler (1957)

Die ersten modernen Computer waren nicht gerade benutzerfreundlich. Sie wurden wörtlich von Hand programmiert, indem man Schaltkreise mit Drähten verband. Spätere Maschinen- und Assemblersprachen erlaubten es den Anwendern, Programmcode zu schreiben. Doch auch das war überaus kompliziert; man musste dafür die zu Grunde liegende Computerarchitektur extrem genau verstehen. Das hielt viele Wissenschaftler von der Arbeit mit den Rechnern ab.

Mit dem Aufkommen symbolischer Programmiersprachen in den 1950er Jahren änderte sich das – insbesondere durch Fortran, das der Informatiker John Backus zusammen mit seinen Kollegen bei IBM in San José, Kalifornien, entwickelte. Dank Fortran konnten Nutzer einem Computer verständliche Anweisungen übergeben, etwa x = 3 + 5. Ein Compiler übersetzte die Befehle dann in einen effizienten Maschinencode, mit dem Rechner umgehen können.

»Zum ersten Mal waren wir in der Lage, Computer eigenständig zu programmieren«Syukuro Manabe, Klimatologe an der Princeton University in New Jersey

Verglichen mit modernen Programmiersprachen war die Eingabe des Codes kompliziert: Man brauchte dafür Lochkarten, Zehntausende für eine einzige Simulation. Dennoch, erinnert sich der Klimatologe Syukuro Manabe von der Princeton University in New Jersey, machte Fortran die Rechner nun auch für Forscher zugänglich, die keine Informatiker waren: »Zum ersten Mal waren wir in der Lage, Computer eigenständig zu programmieren.« Selbst heute, nach mehr als 70 Jahren, ist Fortran noch weit verbreitet in Forschungsbereichen, die komplexe lineare Algebra enthalten und leistungsstarke Rechner benötigen, etwa in der Klimamodellierung oder Strömungsdynamik. Denn die Sprache ist schnell, und viele Informatiker beherrschen sie. Weltweit findet man zahlreiche Supercomputer und Labore, in denen alte Fortran-Codes noch immer zuverlässig laufen.

2. Signalverarbeitung: Schnelle Fourier-Transformation (1965)

Wenn Radioastronomen den Himmel absuchen, fangen sie zahlreiche komplexe Signale ein, die sich mit der Zeit verändern. Um Radiowellen zu untersuchen, brauchen Forscher deren Verlauf allerdings nicht in Abhängigkeit von der Zeit, sondern von der Frequenz. Dafür müssen sie die Daten »Fourier-transformieren«. Diese mathematische Operation ist jedoch ziemlich ineffizient, da sie N2 Berechnungen für einen Datensatz der Größe N erfordert – bei 1000 Datenpunkten entspricht das einer Million Rechenschritte.

1965 fanden die US-amerikanischen Mathematiker James Cooley und John Tukey einen Weg, das Verfahren zu beschleunigen. Dafür zerlegten sie das eigentliche Problem so lange in kleinere Teilaufgaben, bis sie diese effizient lösen konnten. Die so genannte schnelle Fourier-Transformation (englisch: Fast Fourier Transform, kurz: FFT) braucht nur noch Nlog2(N) Schritte für N Daten. Damit verbessert sich die Geschwindigkeit enorm: Für 1000 Punkte beträgt der Zuwachs etwa das 100-Fache, für eine Million das 50 000-Fache.

Doch diese Methode stellte sich als nicht ganz neu heraus. Der berühmte Mathematiker Carl Friedrich Gauß hatte sie bereits 1805 ausgearbeitet, aber nie veröffentlicht. Erst der Aufsatz von Cooley und Tukey eröffnete Anwendungen in der digitalen Signalverarbeitung, Bildanalyse, Strukturbiologie und mehr. »Es ist eines der wichtigsten Verfahren in der angewandten Mathematik und im Ingenieurwesen«, erklärt Nick Trefethen von der University of Oxford.

3. Biologische Datenbanken (1965)

Weil Datenbanken ein so essenzieller Bestandteil der wissenschaftlichen Forschung sind, übersieht man leicht, dass sie von komplizierter Software gesteuert werden. In den vergangenen Jahrzehnten wurden die elektronischen Systeme immer größer und leistungsfähiger und haben etliche Bereiche beeinflusst, besonders die Biologie.

Die riesigen Genom- und Protein-Datenbanken verdanken wir der Arbeit von Margaret Dayhoff, einer Pionierin der Bioinformatik an der National Biomedical Research Foundation in Silver Spring, Maryland. In den frühen 1960er Jahren versuchten Biologen, die Aminosäuresequenzen von Proteinen zu entschlüsseln. Damals begann Dayhoff diese Informationen zu sammeln, um nach Hinweisen auf evolutionäre Beziehungen zwischen verschiedenen Arten zu suchen. Ihr »Atlas of Protein Sequence and Structure«, den sie 1965 zusammen mit drei Kollegen veröffentlichte, enthielt das bisherige Wissen über die Sequenzen, Strukturen und Ähnlichkeiten von 65 Proteinen. Das war die erste Sammlung, die »nicht an eine bestimmte Forschungsfrage gebunden war«, schrieb der Historiker Bruno Strasser 2010. Dayhoff codierte ihre Daten durch Lochkarten, wodurch sich die Datenbank am Computer durchsuchen und erweitern ließ.

Daraufhin folgten ähnliche Systeme: Die »Protein Data Bank«, in der heute mehr als 170 000 makromolekulare Strukturen erfasst sind, ging 1971 in Betrieb. Zehn Jahre später erstellte der Evolutionsbiologe Russell Doolittle von der University of California, San Diego, eine weitere Protein-Datenbank namens »Newat«. 1982 erschien das heute als »GenBank« bekannte DNA-Archiv, das die US National Institutes of Health unterhalten.

Im Juli 1983 erwiesen sich diese Ressourcen als besonders wertvoll. Zwei Teams unter der Leitung von Doolittle und dem Biochemiker Michael Waterfield vom Imperial Cancer Research Fund in London machten damals unabhängig voneinander eine erstaunliche Entdeckung: Sie erkannten eine Ähnlichkeit zwischen den Sequenzen eines menschlichen Wachstumsfaktors und eines Proteins in einem Virus, das bei Affen Krebs verursacht. Das legte einen Mechanismus für die Onkogenese (die Entwicklung von bösartigen Tumoren) durch Viren nahe. In der Folge begannen Biologen, Krebs durch den Vergleich von Sequenzen zu erforschen, wie James Ostell berichtet, ehemaliger Direktor des US national Center for Biotechnology Information (NCBI).

Darüber hinaus, erklärt Ostell, war das »der Start der objektiven Biologie«. Zusätzlich zu Experimenten, die Hypothesen testen, konnten Forscher frei zugängliche Datensätze auf bestimmte Zusammenhänge hin untersuchen, die den Datensammlern vielleicht nie in den Sinn gekommen wären. 1991 erweiterten die Programmierer des NCBI die Möglichkeiten, indem sie die verfügbaren Informationen miteinander verknüpften: Die Datenbank »Entrez« verbindet mehrere Biochemie-Datenbanken.

4. Wetter- und Klimavorhersage: Das allgemeine Zirkulationsmodell (1969)

Am Ende des Zweiten Weltkriegs nutzte der Informatikpionier John von Neumann Computer, die ein paar Jahre zuvor noch Flugbahnen und Waffendesigns berechnet hatten, um das Wetter vorherzusagen. Bis zu diesem Zeitpunkt, erklärt der Klimatologe Manabe von der Princeton University, machte man das rein empirisch. Man stützte sich auf Erfahrungswerte und Vermutungen, um in die Zukunft zu extrapolieren. Von Neumanns Team versuchte hingegen, eine numerische Vorhersage auf der Grundlage physikalischer Gesetze zu entwickeln.

Die dazugehörigen Gleichungen waren zwar schon seit Jahrzehnten bekannt, aber in der Praxis nicht lösbar: Man musste dafür die exakten Witterungsbedingungen bestimmen, anschließend berechnen, wie sie sich innerhalb eines sehr kurzen Zeitraums ändern würden, und dieses Prozedere immer wieder wiederholen. Das erwies sich als so zeitaufwändig, dass das Wetter die Wissenschaftler dabei einholte: 1922 verbrachte Lewis Fry Richardson Monate damit, eine Vorhersage für die nächsten sechs Stunden zu kalkulieren. Das Ergebnis erwies sich als extrem ungenau und enthielt Phänomene, die in der Realität nicht eintreten können.

1922 verbrachte Lewis Fry Richardson Monate damit, eine Wettervorhersage für die nächsten sechs Stunden zu kalkulieren

Aber die fortschreitende Computertechnik brachte eine Lösung des Problems in Reichweite. Ende der 1940er Jahre gründete von Neumann seine Forschungsgruppe für Wettervorhersagen am Institute for Advanced Study in Princeton. Etwa 15 Jahre später begann ein zweites Team in Princeton, das Geophysical Fluid Dynamics Laboratory, an einer »unendlichen Vorhersage« zu arbeiten – also dem, was man heute als Klimamodellierung bezeichnet. Manabe, der sich den Forschern 1958 anschloss, widmete sich atmosphärischen Modellen; sein Kollege Kirk Bryan befasste sich mit Simulationen des Ozeans. 1969 verbanden sie beide Ansätze und schufen einen Meilenstein im Bereich der Klimatologie.

Das kombinierte Ozean-Atmosphären-Modell von Manabe und Bryan unterteilte ein Sechstel des Globus in Quadrate von 500 mal 500 Kilometer und zerlegte die Atmosphäre in neun Schichten. Heutige Klimamodelle bestehen aus 25 mal 25 Kilometer großen Quadraten und Dutzenden atmosphärischen Ebenen. Dennoch, sagt der Geophysiker Venkatramani Balaji vom Geophysical Fluid Dynamics Laboratory, leisteten Manabe und Bryan mit ihrem Modell großartige Arbeit. Es ermöglichte erstmals, die Auswirkungen steigender Kohlendioxidwerte in einer Simulation zu untersuchen.

5. Zahlenknacker: BLAS (1979)

In vielen verschiedenen wissenschaftlichen Bereichen greift man auf relativ einfache mathematische Operationen mit Vektoren und Matrizen zurück. Das ist zwar nicht kompliziert, aber häufig aufwändig, da die betreffenden Objekte meist sehr groß sind und man extrem viele Berechnungen durchführen muss. In den 1970er Jahren gab es keine allgemeine Methode, die das ermöglichte. Deshalb verbrachten zahlreiche Wissenschaftler ihre Zeit damit, Algorithmen zu entwickeln, die elementare Rechenschritte ausführten, anstatt sich auf inhaltliche Fragen zu konzentrieren. Es fehlte eine Routine, um derartige Aufgaben anzugehen.

1979 entwickelten Programmierer schließlich die »Basic Linear Algebra Subprograms«, kurz BLAS. Diese Programmbibliothek definierte Dutzende von Lösungswegen für die Vektor- und später auch für die Matrixalgebra. »BLAS war wahrscheinlich das bedeutendste Programm für wissenschaftliches Rechnen«, urteilt der Informatiker Robert van de Geijn von der University of Texas in Austin. Neben standardisierten Namen für gängige Funktionen konnten Forscher sicher sein, dass der Algorithmus auf jedem Computer gleich funktionierte. Mehr als 40 Jahre später ist BLAS das Herzstück des Scientific Computing Stack, eines Codes, der wissenschaftliche Software zum Laufen bringt.

6. Das Must-have der Mikroskopie: NIH Image (1987)

In den frühen 1980er Jahren arbeitete der Programmierer Wayne Rasband mit einem Labor für Neuroimaging (bildgebende Verfahren für das Gehirn) der US National Institutes of Health in Maryland zusammen. Das Team hatte einen Scanner, um Röntgenfilme zu digitalisieren, aber keine Möglichkeit, sie auf einem Computer zu untersuchen. Also entwickelte Rasband ein Programm dafür.

Er schrieb den Algorithmus speziell für einen 150 000 US-Dollar teuren PDP-11-Rechner. Als Apple 1987 den Macintosh II herausbrachte, erwies sich das Gerät als weitaus benutzerfreundlicher und erschwinglicher. »Es war viel besser für die Bildanalyse geeignet«, erinnert sich Rasband. Er passte seine Software an die neue Maschine an, wodurch »NIH Image« entstand.

Mit diesem System und seinen Nachfolgern können Forscher alle Arten von Bildern auf jedem Computer analysieren und bearbeiten. Die Softwarefamilie umfasst ImageJ, eine javabasierte Version, die Rasband für Windows- und Linux-Anwender geschrieben hat. »Es ist das elementarste Werkzeug, das wir haben«, sagt die Bioinformatikerin Beth Cimini vom Broad Institute in Cambridge, Massachusetts. »Ich habe noch nie mit einem Biologen gesprochen, der ein Mikroskop benutzt hat, aber nicht ImageJ.«

Das liegt laut Rasband unter anderem daran, dass die Programme kostenlos sind. Darüber hinaus lassen sie sich an die Bedürfnisse der Nutzer anpassen, fügt der biomedizinische Ingenieur Kevin Eliceiri von der University of Wisconsin-Madison hinzu, dessen Team die Entwicklung von ImageJ seit Rasbands Pensionierung leitet. Das Programm verfügt über eine minimalistische Benutzeroberfläche, die sich in 30 Jahren kaum verändert hat.

Dank eines eingebauten Makro-Rekorders (mit dem sich Arbeitsabläufe in Form von Mausklicks aufzeichnen lassen), der umfangreichen Kompatibilität mit verschiedenen Dateiformaten und der flexiblen Plug-in-Architektur ist die Software für jeden Anwender leicht erweiterbar. So ist es inzwischen beispielsweise möglich, bestimmte Objekte in Videos zu verfolgen oder biologische Zellen automatisch zu identifizieren. »Im Gegensatz zu Photoshop und anderen Programmen kann ImageJ alles machen, was man will«, so Eliceiri.

7. Sequenzierung: BLAST (1990)

Die kulturelle Relevanz eines Produkts zeigt sich daran, wenn dessen Name zu einem Verb wird. Bei der Websuche ist es Google, in der Genetik ist es BLAST.

Mit Mutationen wie Gaps, Insertion, Deletion ist die Evolution eingebrannt in molekulare Sequenzen. Indem sie in solchen Sequenzen – insbesondere von Proteinen – nach Ähnlichkeiten suchen, können Forscher Zusammenhänge entdecken und Einblicke in die Funktion von Genen gewinnen. Hinweise darauf findet man in den schnell anwachsenden biochemischen Datenbanken.

Dazu lieferte Margaret Dayhoff 1978 einen entscheidenden Beitrag. Sie entwickelte eine so genannte »Point Accepted Mutation«-Matrix (kurz: PAM-Matrix), mit der sich die Verwandtschaft zweier Proteine nicht nur anhand der Ähnlichkeit ihrer Sequenzen bewerten lässt, sondern auch durch ihren Abstand in der Evolution.

Sieben Jahre später stellten William Pearson an der University of Virginia in Charlottesville und David Lipman am NCBI den Algorithmus FASTP vor, der Dayhoffs Matrix mit der Fähigkeit verknüpfte, schnelle Suchen durchzuführen. 1990 veröffentlichte Liman zusammen mit einigen Kollegen eine zusätzliche Erweiterung: das Basic Local Alignment Search Tool (BLAST). Es ist extrem schnell und findet zudem Übereinstimmungen, die evolutionär weiter voneinander entfernt sind. Zugleich gibt es an, wie wahrscheinlich es ist, dass die Übereinstimmungen zufällig entstanden.

»Es ist eines dieser Dinge, die zu einem Verb wurden«Sean Eddy, Bioinformatiker an der Harvard University in Cambridge, Massachusetts

Das Programm war unglaublich schnell, erinnert sich der damals beteiligte Informatiker Stephen Altschul vom NCBI. »Man konnte seine Suche eingeben, einen Schluck Kaffee trinken, und schon hatte man das Ergebnis.« Zudem war es einfach zu bedienen. In einer Zeit, bei der man Datenbanken per Post aktualisierte, richtete Warren Gish vom NCBI ein E-Mail-System und später eine webbasierte Architektur ein, mit der Benutzer Suchvorgänge auf den NCBI-Computern aus der Ferne ausführen konnten.

Das System gab dem damals aufkeimenden Feld der Genombiologie ein neues Werkzeug an die Hand, sagt der Bioinformatiker Sean Eddy von der Harvard University in Cambridge, Massachusetts. »Es ist eines dieser Dinge, die zu einem Verb wurden«, so Eddy. »Man sprach davon, seine Sequenzen zu BLASTen.«

8. Preprint-Lager: arXiv.org (1991)

In den späten 1980er Jahren schickten Hochenergiephysiker routinemäßig Kopien ihrer eingereichten Forschungsarbeiten per Post an ihre Kollegen. Das geschah entweder aus Höflichkeit oder weil sie um Kommentare baten. Wegen des Aufwands sandten sie diese jedoch nur an wenige Auserwählte. »Diejenigen, die in der Nahrungskette weiter unten standen, waren auf die Wohltätigkeit der Prominenz angewiesen. Aufstrebende Forscher an Nicht-Elite-Universitäten waren häufig völlig außen vor«, schrieb der Physiker Paul Ginsparg 2011.

Deshalb entwickelte er 1991, damals am Los Alamos National Laboratory in New Mexico, einen E-Mail-Verteiler, dessen Abonnenten täglich Listen von Preprints erhielten, jeweils mit einer Artikelkennung versehen. Mit einer einzigen E-Mail konnten Benutzer auf der ganzen Welt eine Arbeit einreichen, aus dem Computersystem des Labors abrufen sowie Listen mit neuen Artikeln erhalten oder nach bestimmten Autoren und Titeln suchen.

Ursprünglich wollte Ginsparg die Preprints drei Monate lang aufbewahren und den Inhalt auf die Hochenergiephysik beschränken. Aber ein Kollege überzeugte ihn, sie auf unbestimmte Zeit zu speichern. »In diesem Moment wandelte sich das Konzept von dem eines schwarzen Bretts zu einem Archiv«, sagt er. Plötzlich trudelten auch Artikel aus weit entfernten Disziplinen ein. 1993 migrierte Ginsparg das System ins World Wide Web, und 1998 gab er ihm den Namen arXiv.org.

Heute, im 30. Jahr seines Bestehens, beherbergt die Website etwa 1,8 Millionen Preprints – alle frei zugänglich – mit mehr als 15 000 monatlichen Einreichungen und rund 30 Millionen Downloads. »Es ist nicht schwer zu erkennen, warum der Dienst so beliebt ist«, schrieben die Redakteure von Nature Photonics anlässlich des 20-jährigen Bestehens von arXiv: »Es bietet Forschern eine schnelle und bequeme Möglichkeit, um zu zeigen, was sie wann gemacht haben, und vermeidet den Ärger und die Zeit, die für die Begutachtung in einer herkömmlichen Zeitschrift erforderlich sind.«

Der Erfolg führte zu ähnlichen Projekten in zahlreichen anderen Disziplinen, etwa der Biologie, Medizin oder Soziologie. Die Auswirkungen lassen sich aktuell an den zehntausenden Preprints ablesen, die über das Coronavirus entstanden. »Es ist erfreulich zu sehen, dass eine Methodik, die vor 30 Jahren außerhalb der Teilchenphysik-Gemeinschaft als heterodox galt, heute allgemein als natürlich angesehen wird«, schreibt Ginsparg abschließend.

9. Datenbearbeitung: IPython Notebook (2011)

Fernando Pérez war 2001 ein Doktorand »auf der Suche nach Ablenkung«, als er beschloss, sich mit einer Kernkomponente von Python, einer weit verbreiteten Programmiersprache, zu beschäftigen. Häufig griff man dabei auf ein System namens REPL (Read-Evaluate-Print-Loop) zurück: Man gibt seinen Code ein, das Programm führt ihn Zeile für Zeile aus und liefert ein Ergebnis. Das funktionierte zwar zuverlässig und schnell, aber Pérez fiel auf, dass Python nicht für das wissenschaftliche Arbeiten entwickelt worden war. Zum Beispiel war es nicht möglich, bestimmte Code-Module auf einfache Weise vorzuladen oder Datenvisualisierungen offen zu halten. Deshalb entschied Perez, selbst eine solche Version zu schreiben.

Das Ergebnis war IPython, ein interaktives Programmpaket zum Entwickeln und Ausführen von Pythonprogrammen, das Pérez im Dezember 2001 vorstellte – und das aus lediglich 259 Zeilen bestand. Zusammen mit dem Physiker Brian Granger und dem Mathematiker Evan Patterson zog er das System zehn Jahre später auf den Webbrowser um, brachte das IPython Notebook auf den Markt und löste damit eine Revolution in der Datenwissenschaft aus.

Computergestützte Notebooks bestehen nicht nur aus Programmcodes, sondern vereinen auch Texte und Grafiken in einem Dokument. Im Gegensatz zu anderen Systemen dieser Art (wie die Software Mathematica oder Maple) war IPython quelloffen und erlaubte Beiträge anderer Entwickler. Außerdem unterstützte es die Programmiersprache Python, die unter Wissenschaftlern sehr beliebt ist.

2014 entwickelte sich IPython zu Jupyter, das inzwischen mehr als 100 Programmiersprachen zulässt und es den Benutzern ermöglicht, Daten auf entfernten Supercomputern ebenso einfach zu verarbeiten wie auf ihren eigenen Laptops. »Für Datenwissenschaftler hat sich Jupyter zu einem Standardwerkzeug entwickelt«, urteilte Nature 2018. Damals gab es 2,5 Millionen Jupyter-Notebooks auf der Code-Sharing-Plattform GitHub; inzwischen hat sich die Anzahl vervierfacht.

Darunter befinden sich auch jene Notebooks, die 2016 die Entdeckung von Gravitationswellen und 2019 die Abbildung eines Schwarzen Lochs dokumentieren. »Dass wir einen kleinen Beitrag zu diesen bahnbrechenden Arbeiten geleistet haben, macht uns sehr stolz«, sagt Pérez.

10. Schneller Lerner: AlexNet (2012)

Künstliche Intelligenz (KI) gibt es in verschiedenen Varianten. Die alte Schule entwickelt künstliche Intelligenz mit kodifizierten Regeln; das heute dominierende »Deep Learning« lässt Computer selbst »lernen«, indem es die neuronale Struktur des Denkorgans nachbildet. Jahrzehntelang taten KI-Forscher den zweiten Ansatz als unsinnig ab, erklärt der Informatiker Geoffrey Hinton von der University of Toronto. Doch 2012 bewiesen seine Doktoranden Alex Krizhevsky und Ilya Sutskever mit »AlexNet« das Gegenteil.

Schauplatz war ImageNet, ein jährlicher Wettbewerb, bei dem Forscher ihre Algorithmen mit einer Million Abbildungen von Alltagsgegenständen auf Objekterkennung trainieren und anschließend mit einem separaten Datensatz testen. Bis 2012 kategorisierten die besten Programme etwa ein Viertel der Bilder falsch, erinnert sich Hinton. Das neuronale Netz AlexNet reduzierte die Fehlerquote auf erstaunliche 16 Prozent.

Eine große Menge Trainingsdaten, gute Programmierung und die zunehmende Leistung von Grafikprozessoren haben Hinton zufolge zu diesem Erfolg geführt. »Plötzlich konnten wir unser Programm 30-mal schneller laufen lassen«, sagt er, »oder von 30-mal so vielen Daten lernen.«

Der eigentliche Durchbruch habe aber schon drei Jahre zuvor stattgefunden. Damals schuf sein Labor ein neuronales Netz, das Sprache weitaus besser verarbeiten konnte als herkömmliche KI. Diese Fortschritte läuteten den Aufstieg des Deep Learning ein. Solche Algorithmen sind der Grund, warum Mobiltelefone gesprochene Anfragen verstehen und Bildanalyse-Programme biologische Zellen erkennen können. Und deshalb nimmt AlexNet einen Platz unter den Computerprogrammen ein, welche die Wissenschaft – und damit die Welt – in den vergangenen Jahren grundlegend verändert haben.

Wenn Sie inhaltliche Anmerkungen zu diesem Artikel haben, können Sie die Redaktion per E-Mail informieren. Wir lesen Ihre Zuschrift, bitten jedoch um Verständnis, dass wir nicht jede beantworten können.