Lexikon der Mathematik: Sigma-Pi-Hopfield-Netz

spezielle Realisierung eines assoziativen Speichers im Kontext Neuronale Netze, der eine Verallgemeinerung des klassischen Hopfield-Netzes durch die Berücksichtigung von multilinearen Sigma-Pi-Typ-Aktivierungen darstellt.

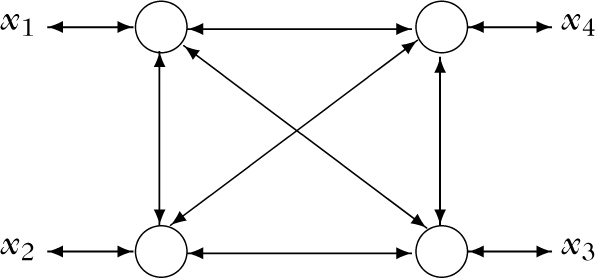

Im folgenden wird die prinzipielle Funktionsweise eines Sigma-Pi-Hopfield-Netzes erläutert (diskrete Variante). Dieses spezielle Netz ist einschichtig aufgebaut und besitzt n formale Neuronen. Alle formalen Neuronen sind bidirektional mit jeweils allen anderen formalen Neuronen verbunden (vollständig verbunden) und können sowohl Eingabeals auch Ausgabewerte übernehmen bzw. übergeben. Bei dieser topologischen Fixierung geht man allerdings implizit davon aus, daß alle Neuronen in zwei verschiedenen Ausführ-Modi arbeiten können (bifunktional): Als Eingabe-Neuronen sind sie reine fanout neurons, während sie als Ausgabe-Neuronen mit der sigmoidalen Transferfunktion T : ℝ → {−1, 0, 1},

Struktur eines Sigma-Pi-Hopfield-Netzes

Dem Netz seien im Lern-Modus die bipolar codierten Trainingswerte x(s) ∈ {−1, 1}n, 1 ≤ s ≤ t, zur Speicherung übergeben worden und aus diesen die Gewichte wR ∈ ℝ, R ⊂ {1,…,n}, #R ≤ d + 1, in irgendeinem Lern-Prozeß, z. B. mit der Hebb-Lernregel, berechnet worden. Dabei bezeichne #R wie üblich die Anzahl der Elemente der Menge R, und d ∈ {1,…,n − 1} sei eine fest vorgegebene natürliche Zahl, über die die maximale Anzahl der Faktoren in den multilinearen Sigma-Pi-Typ-Aktivierungen fixiert wird (man spricht dann auch von einem Sigma-Pi-Hopfield-Netz d-ter Ordnung). Wird nun dem Netz im Ausführ-Modus ein beliebiger bipolarer Eingabevektor

Wenn Sie inhaltliche Anmerkungen zu diesem Artikel haben, können Sie die Redaktion per E-Mail informieren. Wir lesen Ihre Zuschrift, bitten jedoch um Verständnis, dass wir nicht jede beantworten können.